人工知能(AI)

-

AIと子どもの「危険な絆」、米規制強化で最新の動き

子どもたちがチャットボットと不健全な絆を形成することで生じるリスクは、AIの安全性を抽象的な懸念から政治的な争点へと変化させた。米当局は規制強化に向けて動き出している。

-

AIは動画をどうやって 作れるようになったのか? ブレークスルーを解説

-

ようやく出てきた生成AIの電力消費、残された3つの疑問

これまで公表されていなかったAIモデルの電力消費が今夏、AI企業から相次いで発表された。だが、AIデータセンターの消費電力が急上昇している現在、依然として問題は残っている。

-

画面共有でバレたセラピストの「カンニング」、AI丸投げ問題の本質

-

「不気味の谷」越え近づく? 進化した最新AIクローン技術

-

相談中にこっそりChatGPTを使用、セラピストは何のため?

-

「コピーロボット」が現実に? AIクローンの実力を試してみた

-

eムック「AI時代の創造性 人間と機械が紡ぐ新しい表現」特集号

MITテクノロジーレビュー[日本版]はeムック Vol.76 / 2025.08をリリースした。特集は「AI時代の創造性 人間と機械が紡ぐ新しい表現」。

-

Claude「恐喝事件」の衝撃——AI終末論が政治に与える奇妙な効果

全能の人工知能(AI)に関する破滅論的なナラティブは、権力の中枢で勢力を拡大している。しかし、この奇妙な手法は、現実のAIシステムに潜む脅威の規制につながるかもしれない。

-

チャットGPTからの卒業:自分のパソコンでLLMを動かしてみよう

-

筆頭著者はAI、査読、発表も——異色の学会、主催者に聞く

AIが研究・執筆・査読のすべてを担う異色の学会が10月に開催される。物理学から医学までを1日で網羅し、AIが筆頭著者の論文をAI査読者が評価、テキスト音声変換で発表するという。主催者に狙いを聞いた。

-

1クエリでレンジ1秒分、グーグルがGeminiの消費電力を初公開

グーグルが生成AI「Gemini」のエネルギー消費量に関するデータを初めて公開した。大手テック企業として初で、同社は「日常行動と同程度で過度な心配は不要」としている。

-

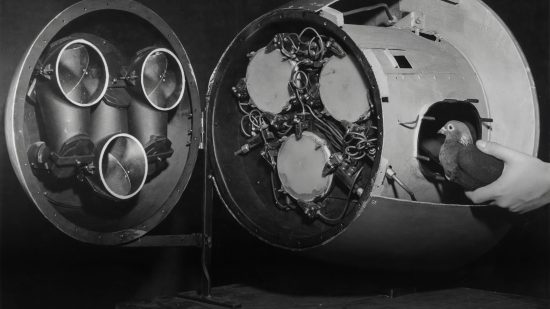

「超知能」AIの起源は 愚かな鳥・ハトの脳にあった ——学習理論の驚くべき系譜

-

迷走したチャットGPTの人格設計、問われる人間との距離感

GPT-5のリリース直後、一部のユーザーの不満を受け、オープンAIは前バージョンの再提供を余儀なくされた。このことは、サム・アルトマンCEOが、方向性を見誤っていることを示しているのかもしれない。

-

「友を失った」ユーザーの悲痛、オープンAIが見誤ったAIへの愛着

-

司法を侵食するAIの功罪、 米国では判事も ハルシネーションに騙された

-

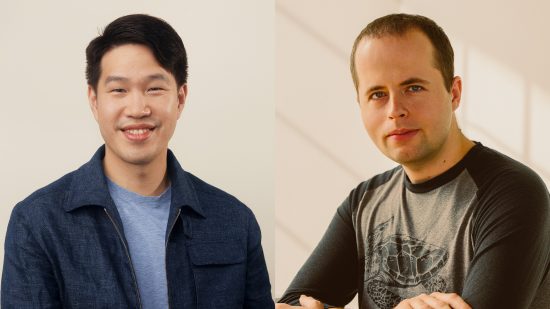

オープンAI「2人の頭脳」 独占インタビューで語った AGI実現への道筋

-

GPT-5、消えた驚き——スマホに似てきたAIモデルの発表会

オープンAIが先日リリースした最新のAIモデル「GTP-5」は、洗練されたユーザー体験を提供するが、画期的な進歩とは言い難いものだった。AI企業は誇大宣伝サイクルに陥りつつある。

-

肩透かしだったGPT-5、オープンAIの方針転換に危うさ

-

迫る「知能爆発」の兆し、 AIによるAIの進化は 5つの領域で起きている

-

相棒はチャットGPT、 幻覚剤×AIセラピストの 危うい組み合わせ

-

オープンAI、GPT-5をリリース 推論モデルを統合

-

AIエージェントがまだ 「使えない」理由—— プロトコル標準化が握る鍵

-

オープンAI、6年ぶりのオープンモデル「gpt-oss」を公開

オープンAIがようやくオープンに?——同社としておよそ6年ぶりとなるオープンウェイト・モデル「gpt-oss」をリリースした。オープンモデルで中国企業が席巻する中、重い腰を上げた格好だ。

-

毒をもって毒を制す? LLMの有害行動を防ぐ意外な新手法