人工知能(AI)

-

ディープマインド、未知のゲームもプレイできるAIエージェント

グーグル・ディープマインドの新しいAIエージェントは、人間のプレイヤーを観察することで、これまで見たことのないさまざまなゲームをプレイできる。

-

オープンAIのスピンオフ、人間のように学ぶマルチモーダル・ロボ

-

禁止では不十分なディープフェイク対策、本当に必要なこととは?

ディープフェイクについて、誰もが見て見ぬふりをしている重大な事実がある。全面的な禁止は技術的に不可能かもしれないことだ。私たちが本当に必要としているものは何だろうか。

-

プロンプト不要、生成AIで誰でも物語からマンガが作れる

-

巨大テック企業がディープフェイク対策で歩調、生成AI検出へ

グーグル、マイクロソフト、アドビ、メタなどの巨大テック企業は、AIが生成した画像に「透かし」を入れる方向で動き出した。課題は残るが、ディープフェイク対策の前進は歓迎したい。

-

手描きスケッチからマリオ風ゲームを生成、ディープマインド新モデル

大量のゲーム動画で訓練されたグーグル・ディープマインドのAIモデル「Genie」は、短いテキストやスケッチ、写真からビデオゲームを生成できる。

-

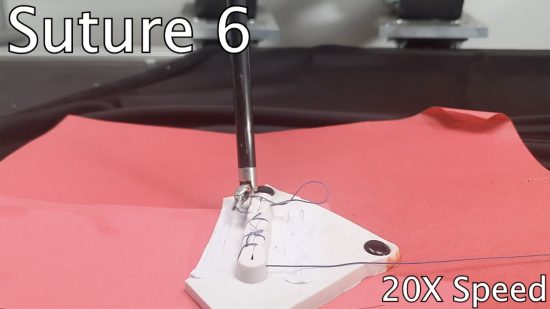

AIロボットが縫合技術を習得、6針縫うことに成功

カリフォルニア大学バークレー校の研究チームが開発したAIロボットが、人工皮膚に対する6針の縫合に成功した。この技術は、手術中の疲労やミスを減少させ、患者の治療結果を向上させる可能性がある。

-

AI批評家、ゲイリー・マーカスとの散歩で話したこと

-

AIボット導入で、メンタルヘルス・サービスの利用者が増加

英国国民健康サービス(NHS)が導入したAIチャットボットは、メンタルヘルスのサービス利用者増加につながった。スクリーニングにも役立つという。

-

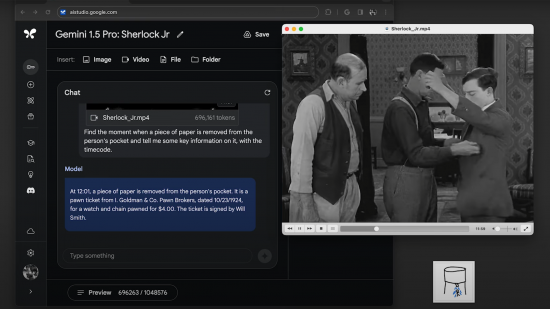

グーグルが早くも「Gemini 1.5」、最大100万トークン

グーグルが次世代AIモデルの最新版「ジェミニ(Gemini)1.5」を発表した。昨年12月のリリースから早くもアップデートされた新版では、最大100万トークンに対応する。

-

動画でも生成革命、オープンAIが新モデル「Sora」を発表

オープンAIは新たなテキスト-動画生成モデル「Sora」を発表した。公開された映像は驚異的だが、一般公開の予定はまだない。

-

AIは赤ちゃんから何を学べるのか?

現在のAIシステムは、狭い範囲でタスクを実行するのに優れているが、依然として極めて脆弱だ。赤ちゃんがどのように学習するかを研究することは、より強力なAIモデルの開発に役立つ可能性がある。

-

衛星画像とAIで南アの空間的アパルトヘイトに挑む研究者

南アフリカの黒人が多く居住するタウンシップは、すぐ近くにある裕福な住宅地に比べ公共のリソースをほとんど利用できない。研究者たちは、この問題を地図化することで状況を改善したいと考えている。

-

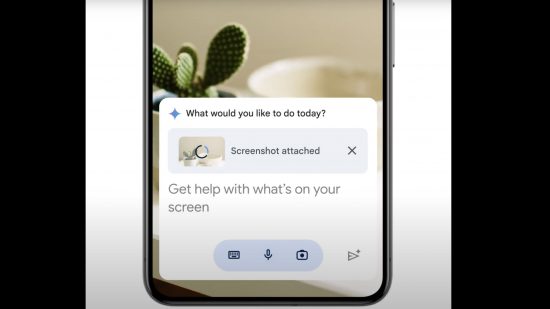

グーグルが生成AI「ジェミニ」全面展開、「バード」から切り替え

グーグルは生成AI「バード(Bard)」を廃止して、ジェミニ(Gemini)に統一する。チャットGPT型のチャット・サービスのほか、Gmailやグーグル・ドキュメントなどにも組み込む予定だ。

-

追加訓練なし、初見の部屋でも働くお片付けロボットの新研究

新しいシステムにより、ロボットはオープンソースAIモデルの助けを借りて、これまで見たことのない家の中を歩きまわれるようになった。

-

「意識を持つAI」は 存在し得るのか? 研究者の議論から見える未来

人工知能(AI)に意識が宿る日はやってくるのか? 神経科学者や哲学者たちはその可能性を探求している。AIの倫理的指針につながるだけでなく、人間の意識の本質を理解する上でも役立つかもしれない。

-

赤ちゃんは言語をどう学ぶのか?ヘッドカメラでAIを訓練した結果

幼児の頭部に装着したビデオカメラの映像を用いて訓練されたニューラル・ネットワークは、大規模言語モデルよりもはるかに少ないデータで、単語と対象物を一致させられるようになることがわかった。

-

中国テック事情:2024年のAI規制で注目すべき4つのこと

中国政府が新しいテクノロジーに迅速に対応することはよく知られている。2024年、中国におけるAI規制がどのようになるかを専門家に聞いてまとめた。

-

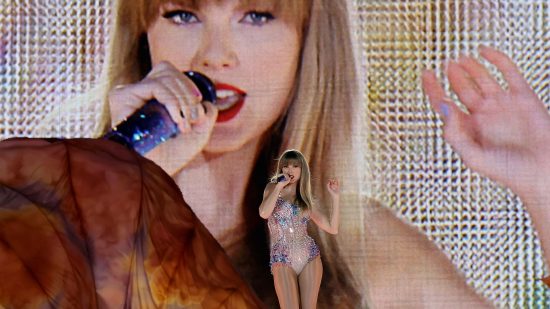

ディープフェイク被害にあったテイラー・スイフトさんへの手紙

-

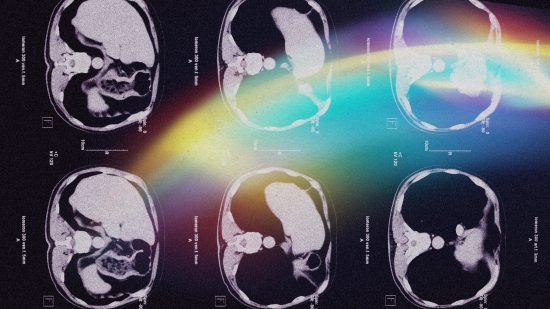

すい臓がん早期発見へ、AIベースの予測システムが新成果

新たに開発された「プリズム(PRISM)」と呼ばれる人工知能(AI)システムは、発見が難しい、すい臓がんの早期発見につながる可能性がある。

-

テイラー・スウィフトも被害、ディープフェイク・ポルノ対抗策は?

世界有数のポップスターであるテイラー・スウィフトが悪質なディープフェイク・ポルノの被害に合った。現時点での対抗策となる3つの方法を紹介する。

-

アンドリュー・エン特別寄稿:イノベーターを志す人たちへ

グーグル・ブレインを創設し、AI分野でのイノベーションを牽引してきたアンドリュー・エンが贈る、挑戦、失敗、未来についてのアドバイス。

-

中国テック事情:もう1つのロボタクシー先進国、中国の新事情

-

オープンAI、グーグルはなぜAIの「数学」能力を競うのか?

-

事故と収益化に苦しむロボタクシー業界、2024年の展開は?

米国と中国の一部都市ではすでに完全無人のロボタクシーが走行している。ロボタクシーは2024年、さらに広がるのか? 業界が直面している課題と今後の展開を専門家に聞いた。