IBMが新ニューロチップを試作、低消費電力で機械学習を効率化

ニューラル・ネットワークの処理をハードウェアで実行するチップをIBMが試作した。計算用の短期シナプスと記憶用の長期シナプスを利用することで、ソフトウェアベースのニューラル・ネットワークの1%の消費電力で、同程度の精度を実現できることがわかった。 by Will Knight2018.06.15

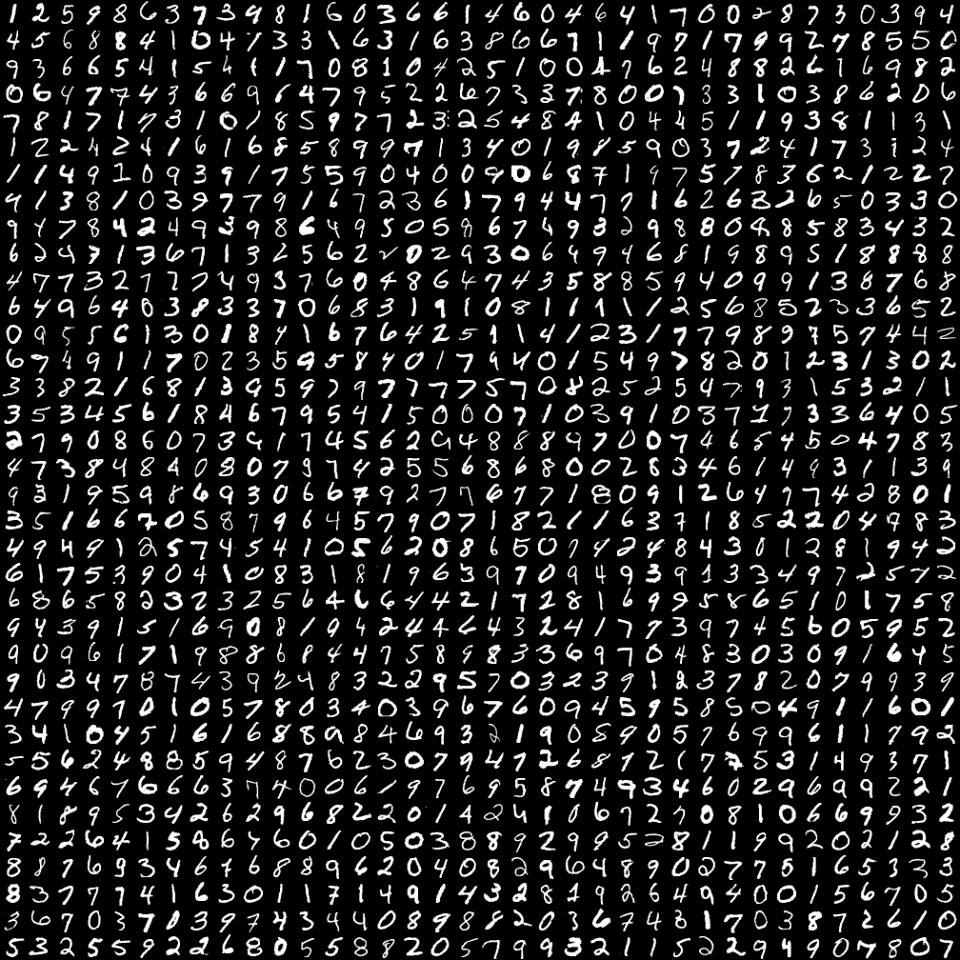

ニューラル・ネットワークは人工知能(AI)ブームの中核にある。データを猛烈な勢いで取り込み、完璧に近い精度で演説の書き起こしや画像の説明などの仕事をこなす(「10 Breakthrough Technologies 2013:Deep Learning」を参照)。

しかし落とし穴がある。それは、人間の脳の構造を大まかにモデル化したニューラル・ネットが通常、ハードウェアではなく、ソフトウェアで作られていることだ。従来のコンピューター・チップで動作するニューラル・ネットのソフトウェアは、実行に時間がかかる。

IBMは、ニューラル・ネットの重要な機能を直接シリコンで構築することで、効率が100倍になる可能性があることを示した。この方法で構築したチップは、今後数年で機械学習の効率を飛躍的に高める可能性がある。

ソフトウェアで作成したニューラル・ネットと同じように、IBMのチップは脳内のニューロン同士をつなぐシナプスを模倣している。このシナプス結合の強度を調整することで、ニューラル・ネットワークに学習させる。生体の脳では、時の経過に伴う成長または衰退という形で結合が調整される。結合の調整をソフトウェアで再現することは簡単だが、ハードウェアで再現することは至難の業であることがこれまでに分かっている。

IBMの研究者らは、微細な電子回路で作成したシナプスについて …

- 人気の記事ランキング

-

- What is vibe coding, exactly? バイブコーディングとは何か? AIに「委ねる」プログラミング新手法

- A Google Gemini model now has a “dial” to adjust how much it reasons 推論モデルは「考えすぎ」、グーグルがGeminiに調整機能

- Meet the researchers testing the “Armageddon” approach to asteroid defense 惑星防衛の最終戦略 科学者たちが探る 「核爆発」研究の舞台裏

- Anthropic can now track the bizarre inner workings of a large language model 大規模言語モデルは内部で 何をやっているのか? 覗いて分かった奇妙な回路