グーグルが指摘する、イーロン・マスクが語らないAIの本当の脅威

グーグルのAI主任は、偏見が含まれるデータによる機械学習によってAIが偏ることを心配してる。具体的で技術的な根拠もなしに「AIの脅威」を喧伝するよりも、はるかに大きな問題だという。 by Will Knight2017.10.05

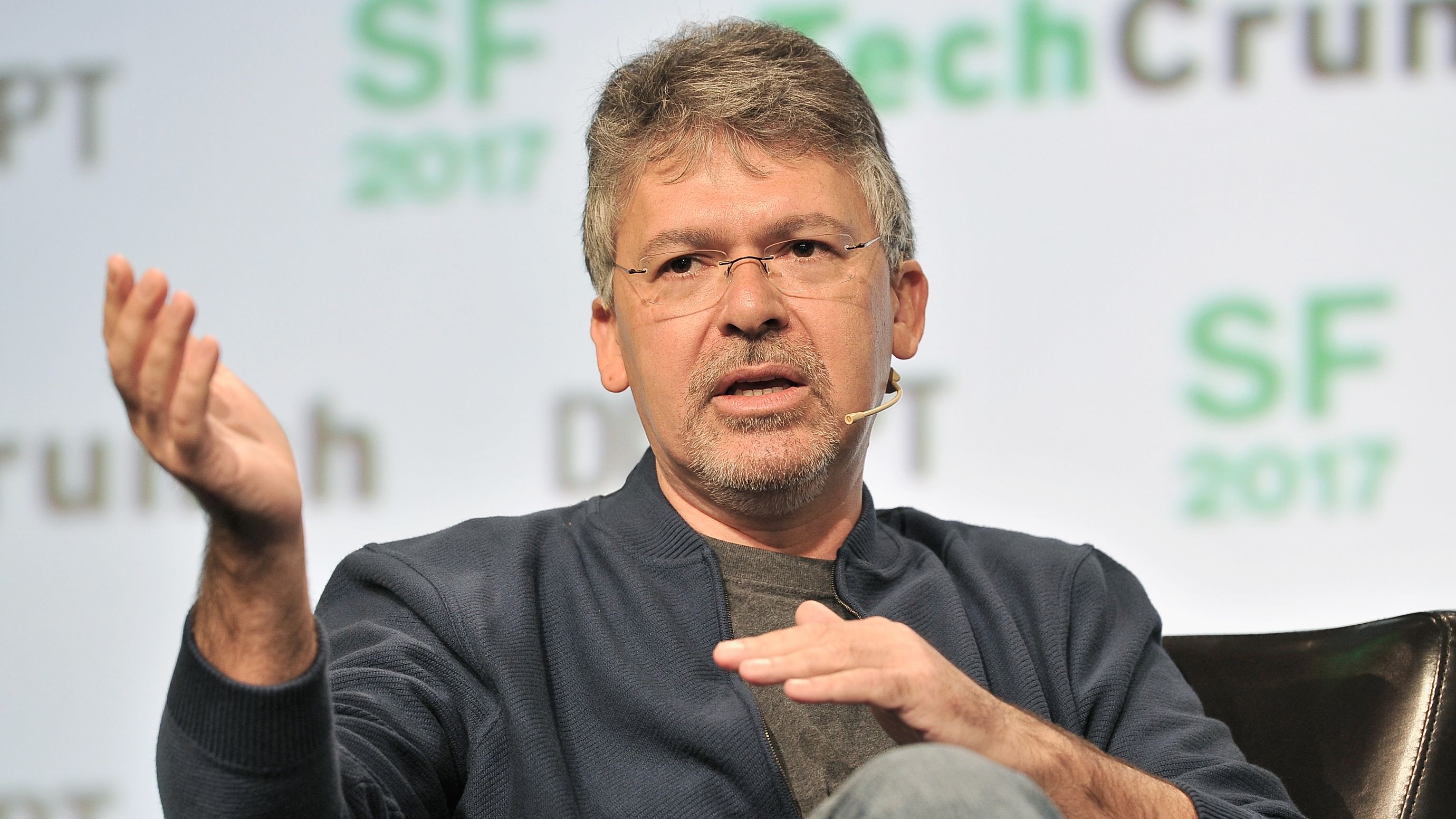

グーグルの人工知能(AI)主任であるジョン・ギアナンドレアは、非常に賢い殺人ロボットについては心配していない。ギアナンドレア主任が心配しているのは殺人ロボットではなく、毎分数百万もの決定を下す機械学習アルゴリズムに潜んでいるかもしれない脅威だ。

人とAIシステムとの関係をテーマにしたグーグルのカンファレンスの開催を前に、ギアナンドレア主任は「安全性に関する問題の本質は、偏ったデータを学習させればAIシステムは偏見を抱く、ということです」と語った。

機械学習の偏見に関する問題は、AIテクノロジーが医学や法律など重要な分野に広がるにつれて、また、テクノロジーを深く理解しないまま機械学習を活用して働く人々が増えるにつれて、今以上にずっと重要な問題になるだろう。一部の専門家は、偏見的アルゴリズムがすでに多くの業界に蔓延しているにも関わらず、問題の特定や修正に取り組んでいる人はいないと警告している(参照 「人間はアルゴリズムを信頼しすぎ」グーグルの研究者らが警鐘」参照)。

「使用する学習データの透明性が重要で、透明性が担保されていれば学習データに含まれる偏見を見つけ出せます。そうでなければ、偏ったシステムを構築することになります」とギアナンドレアは付け加えた。「たとえば、治療法の決定を支援するシステムが販売されるとしましょう。そのシステムがどのような仕組みで動くのか、どのようなデータを使って訓練されたのかが分からなければ、とても信頼できません」。

ブラックボックス化された機械学習モデルは、すでに人々の暮らしに大きな影響を及ぼしている。ノースポイント(Northpointe)が開発した、被告人の再犯可能性を予測するシステム「コンパス(COMPAS)」は、判事が受刑者に仮出所を許可するときの決定に使われている。コンパスがどのように動作するのかは秘密にされているが、公益目的の調査報道を手がける米国の非営利・独立系報道機関プロパブリカ(ProPublica)の調査では、コンパスがマイノリティに対して偏見を抱いている可能性を示す証拠が明らかになっている。

しかし、使用したデータやアルゴリズムの詳細をただ公開すればいい訳ではない。最先端の強力な機械学習手法の多くは非常に複雑で不透明であり、どんなに注意深く追求しても解明できない( 「人類に残された、AIを信用しない、使わない、という選択肢」参照)。研究者は問題に対処するため、機械学習システムにエンジニアやエンド・ユーザーに近い動作をさせる方法を模索している。

ギアナンドレア主任がAIに偏見が忍び込む可能性を強調するのには理由がある。グーグルは、自社のクラウド・コンピューティング・プラットホームのAI能力を、あらゆるビジネスに対して宣伝しているからだ。クラウド・ベースの機械学習システムは、裏側になるアルゴリズムよりもずっと使いやすく設計されている。そのため機械学習技術は利用しやすくなるだろうが、偏見も紛れ込みやすくなる。経験の浅いデータ科学者やエンジニアが、訓練用データから偏見を特定して取り除くためのチュートリアルやツールの提供も重要になってくるだろう。

グーグルが開催したカンファレンスの登壇者の中にも、偏見の問題を強調している人がいた。グーグルの研究者であるマヤ・グプタは、透明性の高いアルゴリズムを開発する社内チーム「グラスボックス(GlassBox)」の取り組みについて説明した。また、イリノイ大学のケリー・カラアリオス教授(コンピューター科学)は、たとえ平凡なアルゴリズムであっても、偏見を特定することがいかに難しいかを強調した。カラアリオス教授は、フェイスブックのニュースフィードに表示される投稿がどうフィルタリングされているか、ほとんどのユーザーが理解していないとも指摘した。一見つまらない指摘だが、実際はアルゴリズムを調査するのがどれほど困難であるかを的確に説明している。

フェイスブックのニュースフィード・アルゴリズムが、社会的相互作用や主要なニュースに対する一般大衆の認識を形成しているのは確かだろう。あるいは他のアルゴリズムによって、医療現場での治療法や、刑事裁判での扱いに関わる意思決定が微妙に歪められているかもしれない。少なくとも現時点では、殺人ロボットよりもはるかに重要な問題なのだ。

近年、AIがもたらすリスクに関して奇抜な警告が目立っているが、ギアナンドレア主任の指摘は極めて理性的なものだ。特に起業家のイーロン・マスクは、AIは「北朝鮮よりも大きな脅威である」とか、「第3次世界大戦をもたらす」などと発言しており、連日の報道で無数の見出しを飾っている。

「人類がある日突然、非常に優れた知能を持つシステムを手に入れ、それによって人類が廃れるという思い込みには反対です」とギアナンドレア主任はいう。「AIを憂慮する理由は理解できますが、そうした思い込みがあまりに喧伝され過ぎています。人類にとって脅威的なことが今にも起こる理由を説明する、具体的で技術的な根拠は1つもありません」。

- 人気の記事ランキング

-

- What is vibe coding, exactly? バイブコーディングとは何か? AIに「委ねる」プログラミング新手法

- A Google Gemini model now has a “dial” to adjust how much it reasons 推論モデルは「考えすぎ」、グーグルがGeminiに調整機能

- Meet the researchers testing the “Armageddon” approach to asteroid defense 惑星防衛の最終戦略 科学者たちが探る 「核爆発」研究の舞台裏

- Anthropic can now track the bizarre inner workings of a large language model 大規模言語モデルは内部で 何をやっているのか? 覗いて分かった奇妙な回路

- ウィル ナイト [Will Knight]米国版 AI担当上級編集者

- MITテクノロジーレビューのAI担当上級編集者です。知性を宿す機械やロボット、自動化について扱うことが多いですが、コンピューティングのほぼすべての側面に関心があります。南ロンドン育ちで、当時最強のシンクレアZX Spectrumで初めてのプログラムコード(無限ループにハマった)を書きました。MITテクノロジーレビュー以前は、ニューサイエンティスト誌のオンライン版編集者でした。もし質問などがあれば、メールを送ってください。