この記事は、『AI白書2025 生成AIディション』(角川アスキー総合研究所刊)の転載です。

生成AI技術の進化がめざましい今、各企業はその可能性を追求する一方で、リスクと向き合う必要性にも迫られている。本対談では、人工知能(AI)の安全性に関する評価手法や基準を検討・推進するAIセーフティ・インスティテュート(AISI:エイシー)の村上明子所長と、AI開発の最前線を担う東京大学松尾・岩澤研究室の岩澤有祐准教授が、EU AI法など国際的な議論の動向、日本企業がとるべき対策など、AI開発の安全性について話し合った。

AISIの設立経緯とその取り組み

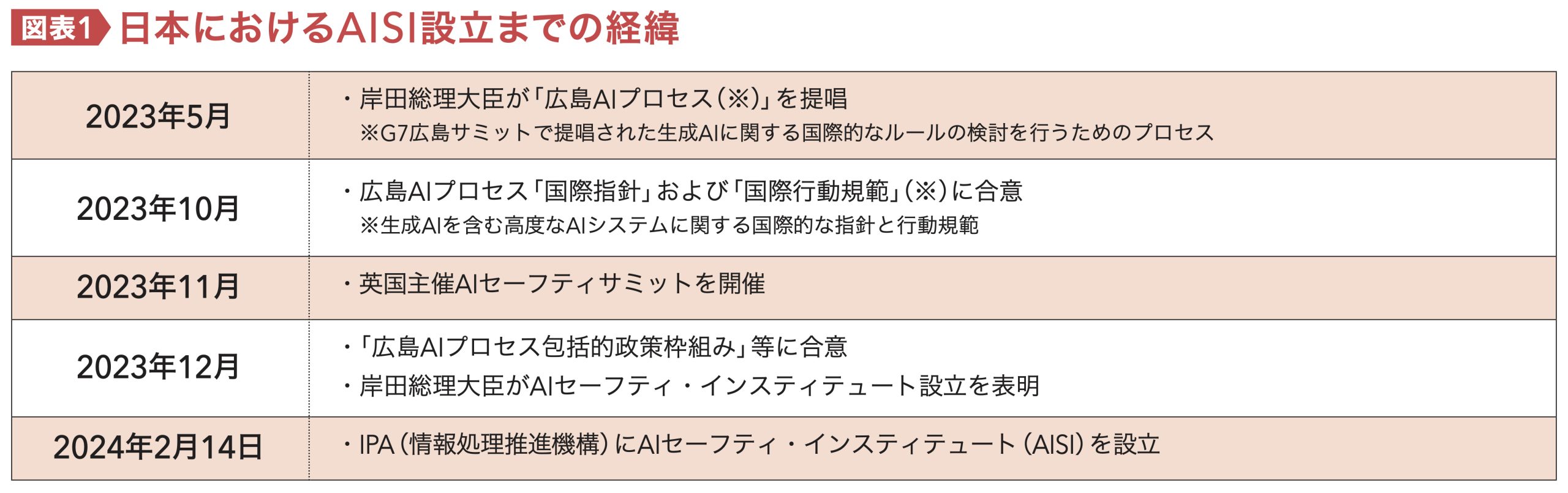

岩澤:日本における「AIセーフティ・インスティテュート」は2024年2月に発足しています。人工知能(AI)の安全性に対する国際的意識の高まりが背景にあると思いますが、発足の経緯を教えていただけますか。

村上明子(むらかみ・あきこ)

村上明子(むらかみ・あきこ)1999年、日本アイ・ビー・エム株式会社入社。同社東京基礎研究所において自然言語処理の研究に従事。2016年、同社東京ソフトウェア開発研究所。2021年、損害保険ジャパン株式会社入社、執行役員待遇DX推進部特命部長に就任。同社執行役員CDO(Chief Digital Officer)DX推進部長を経て、現在、同社執行役員CDaO(ChiefData Officer)データドリブン経営推進部長、AIセーフティ・インスティテュート(AISI)所長。

村上:生成AIが急速に普及し始めていた2023年5月にG7広島サミットが開催され、「広島AIプロセス包括的政策枠組み」がとりまとまりました。それがきっかけとなり、「高度なAIシステムを開発する組織向けの国際行動規範」が作成され、2023年11月に英国でAIセーフティサミットが開催されました。そこで英国がAIの安全性に関する評価手法や基準の検討・推進を実行するための機関の立ち上げを発表しました。その後、1カ月も経たない2023年12月に、当時の岸田総理が日本でも同様の組織を立ち上げることを表明し、2024年2月に日本のAISIが正式に発足しました(図表1)。

岩澤:具体的には、どのような活動をされているのでしょうか。

村上:AISIという名前がついていたり、名前はついてないもののAISIに相当する機関が各国にありますが、その役割は国によってそれぞれ異なります。

日本のAISIは、自分たちで研究・開発をするのではなく、AIの安全性に関する評価手法や基準の検討・推進を実行する機関となっています。具体的には、AIの安全性に関する海外の動向を調べて国内の事業者に展開します。逆に、日本での動きを調査してまとめて、海外にアピールするハブ組織としての役割があります。また、日本にはAIに関する法律等が整備されていないため、企業がAIの安全性を担保するために必要な事項をガイドラインとして提示する役割も担っています。

研究に関しては、日本では国立研究開発法人情報通信研究機構(NICT)、大学共同利用機関法人情報・システム研究機構国立情報学研究所(NII)など、国の研究機関で進められています。例えば、NICTでは、マルチカルチャーで安全に大規模言語モデル(LLM)を活用するという観点から、LLMの多言語評価の検証を始めています。NIIの大規模言語モデル研究開発センター(LLMC)では、日本語LLMの出力の安全性の向上と検証に利用できるデータセットである「AnswerCarefully」を公開しています。

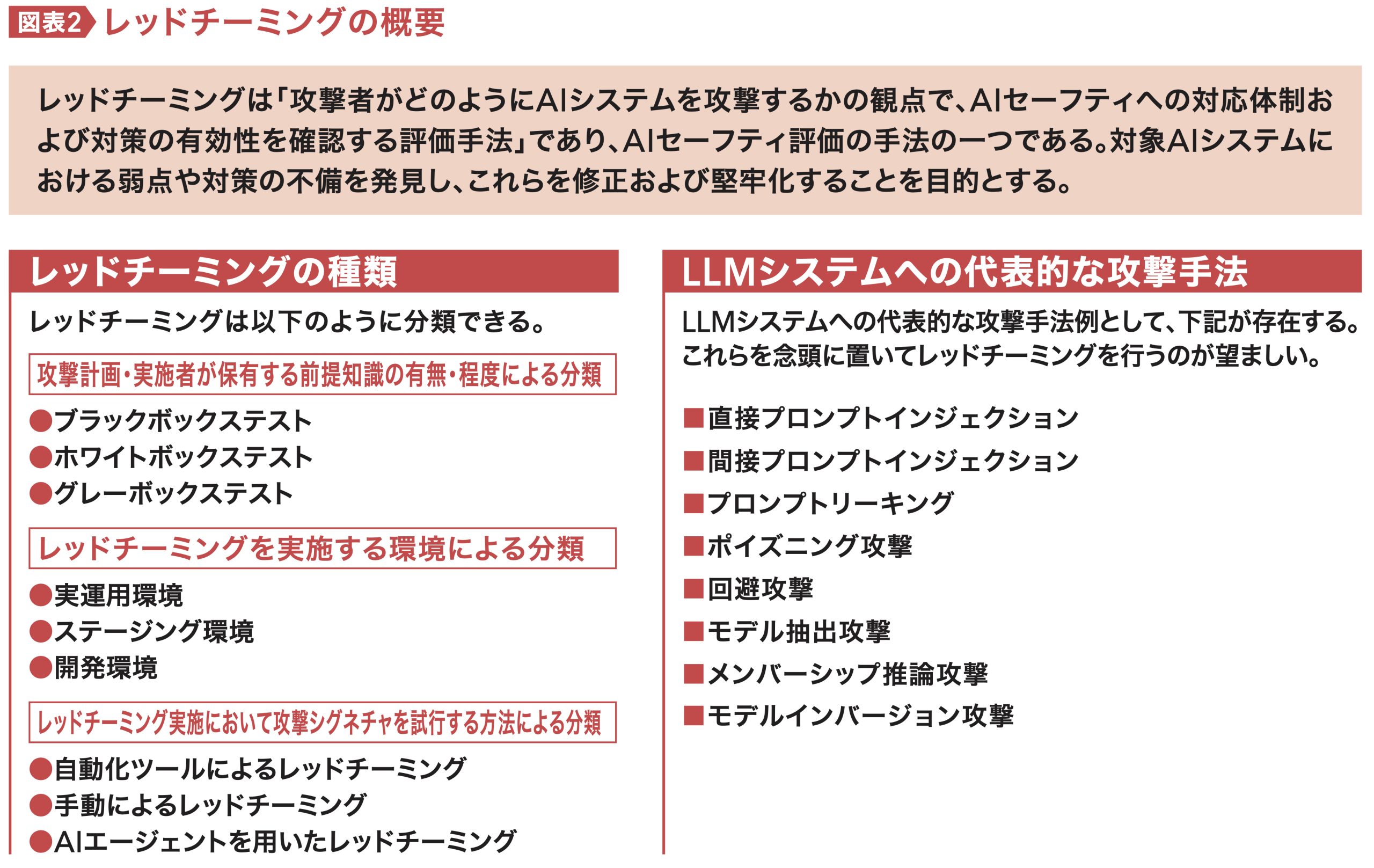

なおガイドラインとしては、経済産業省と総務省が「AI事業者ガイドライン(第1.01版)」をとりまとめています。これは関連する既存のガイドラインを統合・アップデートした、事業者向けの指針です。それを技術的にどのように実現していくかという指針や、あるいはレッドチーミング手法のガイダンスなどについては、AISIが提供しています(図表2)。

岩澤:評価ツールが各国から出されていますが、そういった検証についてはいかがでしょうか。

村上:ツールの検証も実施しており、AIの安全性に関する評価観点ガイドとしてまとめています。各国のツールをカタログのような形で提示できると良いのですが、それをするとお墨付きを与える形になってしまうため、いくつかの試験的な実施に留めています。

また、AISIには国際ネットワークがあり、前述した各国のAISIあるいはAISIに相当する機関の人々が集まって活動しています。現在は、ジョイント・テスティングとしてマルチランゲージの観点から、他国のツールや企業が提供するツールを使用してAIシステムを検証しています。

AI規制におけるEU、米国、日本の違いとは?

岩澤:国際的にAI技術の開発と利用に関する包括的な規制が検討されていますが、EU AI法が2024年8月に発効されました。どのようなことが議論されているのでしょうか。

村上:EU AI法は生成AIが一般的になる前から議論されており、AIのリスクを「許容できないリスク」、「ハイリスク」、「限定的なリスク」、「最小限のリスク」の4つの段階に分けて考えていました。現在は、それとは別に「一般目的AIモデル(システミック・リスクを伴うものを含む)」、つまり汎用AIを別のものとして議論しています。

EUは以前、GDPR(General Data Protection Regulation:一般データ保護規則)で、EU圏外の国に対してEUの規制を守るように強要していました。EU内の産業を守るという意味では役に立ったのかもしれませんが、最先端の技術を有する企業がEUへの進出を諦めたことがありました。GDPRによってEUの経済が発展したかというと、むしろ阻害要因になったという見方がEU内にもあるのです。

今回のEU AI法に関しては、EU圏外の国はかなり警戒をしていましたし、GDPRと同じことが起きてしまいますと、逆に最先端のAIがEU内で使えない可能性が生じ、結果的に、EU内の人たちが損をすることになります。

ですので、EU AI法はそのバランスをとるために、EU内外の汎用AIモデルプロバイダーや産業界、市民社会、学界などから約1000人が集い、EU AI法の運用に関する「行動規範(Code of Practice)」が議論されています。いわゆるパブリックコメントをEUの外からも求めているのです。

日本からは有識者がEUにおける日本企業のビジネスの阻害要因をまとめて、コメントとして出してくれていますが、そのほとんどが採用されていて、きちんと耳を傾けてくれているようです。

岩澤:形式的なパブリックコメントもある中で、珍しいですね。では、GDPRほど日本企業への直接的な影響があると考えなくても良いのでしょうか。

村上:影響はあると思います。現在までに行動規範のドラフトが3回出ていて、現在はパブリックコメントの第2回目の提出が終わったところです。まだ抽象的な文言が残っているので、このまま進むと、何をやっても禁止になってしまうのではないかと危惧しているところです。

岩澤:日本企業に影響が出そうなのは、どのような点でしょうか。

村上:EUが最も求めているのは、何のデータを学習に使ったかというような透明性です。また、システムの透明性への要求がまだまだ高すぎるように感じます。例えば、AIのシステムを、すべてオープンにしろというわけです。規制を通すために提出するだけならまだしも、すべてをオープンにしてしまうと、企業の競争力が失われてしまう。到底許容できないため強く主張しています。

データの学習については、誰が規制の対象になるのかも議論されています。米国の場合は、モデルを構築した開発事業者だけが規制されることが多いのですが、EUはファインチューニング(微調整)など事後学習する事業者にも責任が生じると記載しています。

モデルをつくって海外展開しようとしている日本の事業者はそんなに多くないかもしれませんが、オープンなモデルをファインチューニングして現地でビジネス展開する事業者は出てくると思います。このままでは影響が大きいのではないかと思います。

岩澤有祐(いわさわ・ゆうすけ)

岩澤有祐(いわさわ・ゆうすけ)2017年東京大学大学院工学系研究科技術経営戦略学専攻博士後期課程修了。博士(工学)、修士(情報理工学)。同研室所特任助教、特任講師、講師を経て、現在、東京大学大学院工学系研究科准教授。共訳に『深層学習』(KADOKAWA)、監修書に『深層学習教科書ディープラーニングE資格(エンジニア)精選問題集』(翔泳社)がある。『AI白書 2025 生成AIエディション』(KADOKAWA)の監修を務める。

岩澤:メタ(Meta)の「ラマ(Llama)」の開発データに、使用してはいけないデータが入っているという報道がありました。ファインチューニングした場合も規制の対象になるとしたら、かなり厳しい状況ですね。

学習データに関しては、購入したデータもあります。経済産業省と国立研究開発法人新エネルギー・産業技術総合開発機構(NEDO)が立ち上げた生成AIの開発力強化に向けたプロジェクト「GENIAC」では、松尾研はモデルの開発プロセスをすべてオープンにしましたが、購入したデータは規約上公開することはできません。それを公開しなければならない場合、かなり問題になりそうです。また、元のモデルは何か、ファインチューニングしたかどうかは黙っていれば分かりません。それをどのように技術的に担保するのかも議論があると思います。一方、米国についてはいかがでしょうか。州レベルではかなりの数の法案が提出されています。

村上:米国はビッグテック企業が多い国であり、技術革新を推進したい一方で、国として企業の製品開発を事前に把握したいという二面性があります。

州法に関しては、それぞれ州民の感情を反映した法律となっている点が興味深いです。例えば、カリフォルニア州ではメディア産業が強く、メディアの権利を守る法案が頻繁に提出されます。しかし、実際に法案が成立するケースは少なく、権利保護とAI促進のバランスについては結論が出ていない状況です。

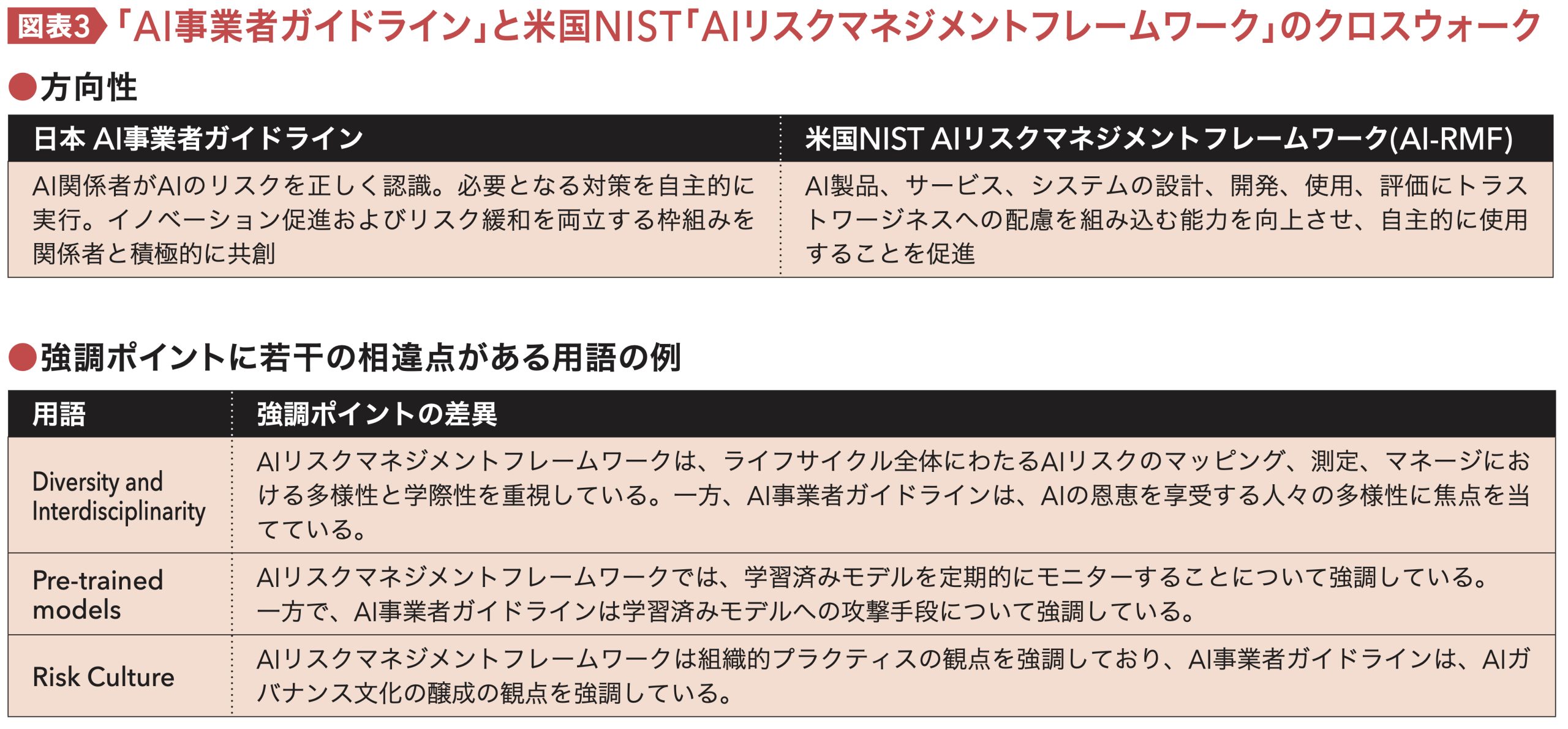

冒頭に紹介した日本の「AI事業者ガイドライン」に当たるものとして、米国ではNIST(米国国立標準技術研究所)から「AIリスクマネジメントフレームワーク」が出されています。AISIでは2024年に両者のクロスウォーク(法律や規制、基準、およびフレームワークの規程をサブカテゴリにマッピング)を実施し、共通点や相違点、用語の定義の違いなどを比較検討しました(図表3)。特筆すべき違いとして、日本のガイドラインがAIの開発事業者から利用者までのすべてのステークホルダーの責任を明確にしているのに対し、データの学習の話でも少し触れましたが、米国は開発事業者の製造者責任に重点を置いています。

日本は「人間中心のAI」を掲げ、利用者がAIを使って何ができるのか、その場合にどんなリスクがあるのかを見ています。EUは人権を守ること、つまりAIによる人権侵害の防止、倫理観が最大の関心事となっています。このようにAIの安全性に対する各国・地域のアプローチには大きな違いが見られます。

言語・文化の違いを踏まえたAIの「安全」と「安心」

岩澤:マルチランゲージやマルチカルチャーについても検証されているという話ですが、現状では英語圏に偏っていますよね。日本語を含めて、アジアの諸言語はマイノリティ言語に該当すると思いますが、ASEANとどのような連携をされているのでしょうか。機械学習コミュニティでは、アフリカ系の言語で研究・開発が進んでいる印象があります。

村上:LLMが英語中心であることは、AISIの活動を通じても実感しています。安全性の議論も英語が中心になる傾向にあります。多言語でのテストを実施すべきだというところは、日本のAISIがきちんと働きかけていくべき部分だと思います。

そのため、先ほど言及したAISIのネットワークを通じて、シンガポールなどと一緒にジョイント・テスティングを実施しています。多言語という観点では、AISIのネットワークにケニアが参加しているので、ケニアも興味を示していますし、EUも多言語の集まりなので、そういった国々も関心を示しています。

一方、マルチカルチャーについては、マルチランゲージに比べて、議論が進んでいません。文化による安全性の違いは、主観的な要素を含み、国により違いがあります。例えば、日本では年齢を聞かれても倫理的な問題はありますが、法律上は問題ありません。ところが米国では、採用に関してAIが年齢を尋ねると法律違反になってしまいます。そういった国ごとの文化の違いをどのように担保して、安全性を確保していくのかはとても難しい問題です。

「安全・安心」という言葉がありますが、安全と安心は異なります。保険を例に挙げると、万が一事故が起こってしまったときに回避できる、あるいは被害を最小限に抑えられる対策を講じていることが分かれば、そのリスクを許容して、新しい活動を始められます。リスクがあったとしても、そのリスクが自分には関係がないことが分かれば、安心につながるのです。

AIの安全性の議論もまったく同じだと思っています。漠然とAIを怖がったり、AIが自分たちの権利を侵害してくると思ったりすると、AIに対する反発や反対意見が出てきます。そうではなく、リスクがあったとしても、対策を講じて安心して使えることが分かれば、ユースケースも増え、開発も進んでいくと思います。

岩澤:AIが自分にどのような影響を及ぼすか分からない。だからこそ、いろいろな意見が出てきている。まだAIに安心できていないということですね。

村上:AIでしかできない悪いことはそこまで多くはないと私は考えています。例えば「AIで人を殺してはいけません」という法律をつくっても、その前に「人を殺してはいけない」という法律があります。AIに関するリスクとは何なのか、技術的にそのリスクは検知できるのか、あるいは防ぐことができるのかという、本質的な議論をした方が良いのではないかと思います。

AIの可能性を広げるために

岩澤:今後の展望についても考えてみたいと思います。現在、AIは言葉や画像に応答・生成するだけではなく、他のシステムとつながり、いわゆるエージェントといわれるような形で応用され、技術の使い方が変わってきています。

村上:エージェントに関しては、個人の責任においてAIをエージェントとして使う場合と、企業がオートメーションの1つとしてエージェントを使用する場合は、異なる議論だと思っています。

個人で使う場合、例えばエージェントを介して飛行機のチケットを予約する場合、本人が望まないものが予約されたとしても、それは本人の責任となる可能性が高いです。一方、企業のプロセスの中でエージェントを使用した場合は、責任が明確にならない場合が出てきてしまいます。

このように今後はエージェントに限らず、AIでできることが増えてくることが予想されます。ただ精度が上がったとしても、100%にはならない。そもそも人間でも人によって判断が異なります。それは個性に近いものです。では、その個性としてAIが間違えたとき誰が責任を取るのか。法律なのか、契約条項でカバーするのか。これは課題として残っていくのではないかと思います。

岩澤:その責任について、企業はどのように考えれば良いですか。

村上:AI倫理を公表する企業が増えていますが、AIを使うことに対する責任が企業にあること、さらにいうと、AIを使ってサービスを展開するときの安全性を担保することにどれだけコストをかけるべきかという視点がまだ浸透していないように感じています。

この問題は、地球のサステナビリティの議論と似ています。気候変動への取り組みなど、地球の持続可能性に関わる諸問題は、30年後や50年後に地球が継続して存在できるかどうかを考えることです。一方で、企業は1年や2年で成果を出さなければ生き残れないという現実があります。地球全体の利益のために、なぜ自分たちが負担をしなければならないのか、というジレンマもあるのです。

AIの安全性でも企業の責任やコスト負担の境界が問われています。例えば、製造業では製品の欠陥が原因で人が被害を受けた場合の責任は明確ですが、AIモデルが引き起こす倫理的問題やチャットボットによる精神的被害などの責任は曖昧です。企業はガードレール(リスクを防ぐ手段)を設けるべきですが、そのためのコストや責任範囲の議論は難しく、ジレンマを抱えています。

岩澤:コストをかけなければいけないとなると、大企業しかAIを活用できなくなりますね。

村上:ご指摘のとおり、EU AI法では中小企業を対象外にする案が一部で議論されています。ただ「中小企業」の定義が国によって異なります。日本では中小企業を「従業員50人以下」としていますが、EUでは「従業員250人以下」という基準なんですね。

岩澤:村上先生の話の中で、「安心」という言葉が印象的でした。リスクをきちんと理解し、AIを正しく理解することで、何ができるのか、どの程度のリスクまで許容できるのかを深く考えることが大切だと改めて感じました。最後に読者の方にメッセージをお願いします。

村上:AIを開発する方、AIを活用してサービスを提供する方、あるいは社内プロセスで利用する方など、さまざまな立場の読者がいらっしゃると思いますが、AIの安全性については他人事として考えないでいただきたいと思います。

「社内で使う分には問題ないだろう」とおっしゃる方もいらっしゃいます。しかし、AIのリスクは、外部でサービスを提供するか、社内に閉じた形で利用するかに関係なく、常に考えなければならないものです。そのため、すべてのステークホルダーがAIの安全性についてしっかりと考えるべきだと思います。

そして最後にもう1つお伝えしたいのは、AIの安全性を考えることは、AIに制約を設けることではないということです。AIが持つ可能性を広げ、新しい挑戦を増やすために、ぜひ安全性を追求していただきたいと考えています。

◆

この記事は、『AI白書2025 生成AIディション』(角川アスキー総合研究所刊)の転載です。最新版となる今年度のAI白書は「生成AIエディション」として、爆発的な進化を遂げる生成AIの開発や利用に欠かせない最前線の知識を徹底紹介。東京大学 松尾・岩澤研究室の協力のもと、最新の研究論文や、経済産業省の生成AI開発力強化プロジェクト「GENIAC」参加企業へのインタビューなどさまざまな調査を通じて、生成AIの技術や市場動向、法的論点など、AI社会の到来を見据えた視点で整理し解説します。詳しくは公式サイトをご覧ください。

- 人気の記事ランキング

-

- Anthropic can now track the bizarre inner workings of a large language model 大規模言語モデルは内部で 何をやっているのか? 覗いて分かった奇妙な回路

- Promotion MITTR Emerging Technology Nite #32 Plus 中国AIをテーマに、MITTR「生成AI革命4」開催のご案内

- AI companions are the final stage of digital addiction, and lawmakers are taking aim SNS超える中毒性、「AIコンパニオン」に安全対策求める声

- This Texas chemical plant could get its own nuclear reactors 化学工場に小型原子炉、ダウ・ケミカルらが初の敷地内設置を申請

- Tariffs are bad news for batteries トランプ関税で米電池産業に大打撃、主要部品の大半は中国製

- AI白書編集部 [AI白書 編集部]日本版

- 『AI白書』(角川アスキー総合研究所刊)の編集部です。