人間よりも優秀な「AIうそ発見器」は社会に何をもたらすか?

ドイツの大学の研究チームが、うそを見抜く能力が人間よりも格段に高いツールを開発した。だが、AIうそ発見器の利用は、人間の行動の基盤となる信頼や社会的な絆を壊す可能性がある。 by Jessica Hamzelou2024.07.11

- この記事の3つのポイント

-

- AIツールは人間よりもうそを見抜く確率が高いものの完璧ではない

- AIうそ発見器によって告発率が上昇するなど行動が変化する可能性

- 誤った判断は人間関係や社会的絆を損なう恐れがある

この記事は米国版ニュースレターを一部再編集したものです。

あなたは「うそつき」を見抜けるだろうか? さまざまな政治討論をテレビで見ていると、多くの人の頭に浮かぶ疑問かもしれない。これまでの研究では、私たちが一般的にうそと真実を見分けるのがかなり苦手であることが示されてきた。

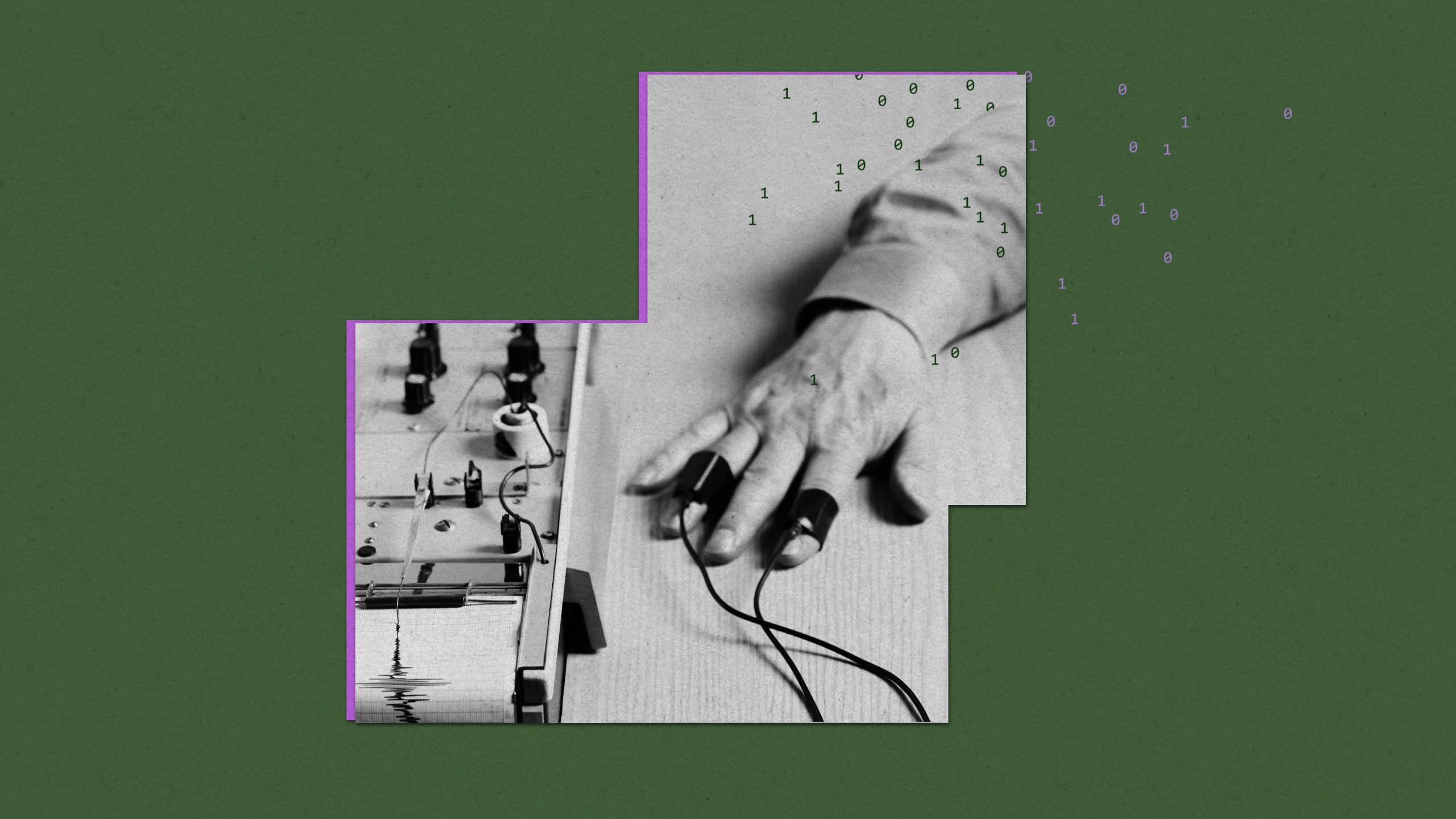

一方、一部の人たちは、人工知能(AI)がうそを見抜く確率を向上させ、ポリグラフテストのような怪しく古めかしい手法よりも良い結果を出すのに役立つかもしれないと考えている。AIベースのうそ発見システムは、いつかフェイクニュースから事実を選別したり、主張を評価したりするのに役立つ可能性がある。求人応募書類のうそや誇張を見抜くことにさえ利用されるようになるかもしれない。問題は、私たちがAIうそ発見システムを信用するようになるかどうかだ。また、信用すべきかどうかという問題もある。

最近、ドイツのヴュルツブルク大学の経済学者であるアリシア・フォン・シェンク教授らの研究チームは、人間よりも格段に優れた、うそを見抜く能力を持つツールを開発した。同チームはその後、人々のツールの使い方を調べるために、いくつかの実験を実施した。いくつかの点でこのツールは役に立った。ツールを利用した人たちは、より上手にうそを見抜くことができたのだ。だが、告発する機会も大幅に増やしてしまった。

アイ・サイエンス(iScience)誌に掲載された研究論文で、フォン・シェンク教授らは、研究ボランティアに週末の予定について文書を書いてもらった。そのうち半分は、うそをつくように仕向けられた。真実味があるものの真実ではない文書に、少額の金銭的報酬が支払われたのだ。研究チームは768人から合計1536枚の文書を集めた。

次に、これらの文書の80%を使い、グーグルのAI言語モデル「バート(BERT)」を利用して、アルゴリズムにうそと真実に関する訓練を施した。訓練が終わったツールを残りの20%の文書でテストしたところ、67%の確率で文書が真実かうそか見分けられることが分かった。典型的な人間よりもかなり優れた成功率である。私たち人間が正しく判断できるのは、通常は半分くらいだ。

うそを見抜くのにAIをどのように活用できるか調べるため、フォン・シェンク教授らは、他のボランティア2040人をいくつかの小グループに分け、一連のテストを実施した。

あるテストでは、うそを見抜いて報酬を得るのに役立つ可能性があるAIツールを少額の課金で利用できる選択肢をボランティアたちに与えた。だが、まだ全員がこのツールを積極的に使いたがるわけではないことが明らかになった。そのような選択肢を与えられたボランティアのうち、AIツールを使うことに決めたのは3分の1しかいなかった。おそらく、このテクノロジーに懐疑的なためであろうと、フォン・シェンク教授は言う(ボランティアたちは自分のうそ発見能力について楽観的すぎるのかもしれないと、同教授は付け加えた)。

しかし、AIツールを使うことにした3分の1の人たちは、このテクノロジーを実際に信頼した。「AIを使うことを積極的に選択した人々の多くは、ほとんど常にAIの予測に従います。AIの予測を非常に頼りにするのです」と、フォン・シェンク教授は言う。

このような信頼が、私たちの行動を形作ることがある。通常、人々は他人が本当のことを話していると思い込む傾向にある。そのことは、この研究でも裏付けられた。ボランティアたちは文書の半分がうそであると分かっていたにもかかわらず、うそとしてマークしたのは19%だけだった。しかし、AIツールの利用を選択すると、この状況は一変した。告発率が58%に上昇したのだ。

いくつかの点で、これは良いことである。このようなツールは、ソーシャルメディア上で出くわすことがある誤情報など、私たちが生活の中で遭遇するうそをより多く見抜くのに役立てることができる。

しかし良いことばかりではない。このようなツールは、人間の行動様式の基本的な側面であり、人間関係の形成に役立つ、信頼を損なう可能性もある。正確な判断の代償が社会的絆の悪化だとしたら、それは価値があることなのだろうか?

そして、正確性の問題もある。フォン・シェンク教授らは自分たちの研究において、うそを発見する能力が人間よりも優れているツールを作ることにしか興味がなかった。私たちのうそ発見能力の低さを考えれば、それはそれほど難しいことではない。しかしフォン・シェンク教授は、自分が開発したようなツールがソーシャルメディアの投稿の真実性を日常的に評価したり、求職者の履歴書や面接での回答にうそがないか探したりするのに利用されることも考えている。そのような場合、テクノロジーがより多くのうそを告発するようになるのであれば、単に「人間より優れている」だけでは不十分である。

評価対象の文書5つのうち4つしか真偽が正しく解釈されないことを意味する80%の正確さを、私たちは受け入れる用意があるのだろうか? 99%の正確さであっても、それで十分なのだろうか? 私は確信が持てない。

そこで、歴史的なうそ発見テクノロジーが誤りを犯しやすかったことを思い出す価値がある。ポリグラフは、心拍数やその他の 「覚醒」の兆候を測定するように設計された。それが、うそつき特有のストレスを示す兆候であると考えられたためだ。しかし、それは真実ではない。そして私たちは、昔からそのことを知っていた。だからこそ、うそ発見器の結果は一般的に米国の裁判では認められていない。にもかかわらず、ポリグラフうそ発見器テストはいくつかの環境で存続してきた。テレビのリアリティ番組では、テストに合格できなかった人に非難を浴びせるために使用され、多くの害をもたらしてきた。

不完全なAIツールは規模の拡大が非常に簡単であるため、さらに大きな影響力を持つことが考えられると、フォン・シェンク教授は言う。ポリグラフで1日に検査できる人の数はそう多くない。それに比べ、AIによるうそ発見能力は無限に近い。

「フェイクュースやデマがこれほど広がっていることを考えると、このようなテクノロジーには利点があります」と、フォン・シェンク教授は話す。「しかし、本当にしっかりとテストする必要があります。人間の判断よりも大幅に優れていることを確認しなければなりません」。もしAIうそ発見器が多くの告発を生み出す場合は、全く使わない方がいいかもしれないと、同教授は言う。

MITテクノロジーレビューの関連記事

AIうそ発見器は、顔の動きのパターンや、ごまかしに関連する「マイクロジェスチャー」を探す目的でも開発されてきた。ジェイク・ビトルが言うように、「完璧なうそ発見器という夢は、特にAIの輝きでごまかされる場合でも、消え去ることはない」。

一方、AIは多くの偽情報を生成する目的でも使われている。テイト・ライアン=モズレーが報告しているとおり、昨年10月時点において少なくとも16カ国で、「疑念を植え付けたり、反対派を中傷したり、公的な議論に影響を与えたりする」ために生成AIが使われていた。

AI言語モデルの開発方法は、そのモデルの機能の仕方に大きな影響を与える場合がある。その結果、本誌のメリッサ・ヘイッキラが昨年取り上げたように、それらのモデルはこれまでさまざまな政治的バイアスを拾い上げてきた。

AIは、ソーシャルメディアと同様に、善悪両方の可能性を秘めている。どちらの場合も、私たちがをれらのテクノロジーにかける規制上の制限によって結果か決まることになると、ネイサン・E・サンダースとブルース・シュナイアーは主張している。

チャットボットの回答はすべてでっち上げである。しかし、大規模言語モデルの出力に信頼性スコアを与えることができるツールが存在し、 ユーザーがモデルの信頼性を見極めるのに役立つ。すなわち、ウィル・ダグラス・ヘブンが数カ月前に公開した記事で表現しているように、チャットボット用のうそ発見器である。

医学・生物工学関連の注目ニュース

- 英国の科学者、倫理学者、法律家らが、合成胚(「幹細胞胚モデル(SCBEM:stem cell-based embryo models)」)を使った研究に対する新たな一連のガイドラインを発表した。研究室でSCBEMを培養する期間に制限を設ける必要があり、ヒトや動物の子宮に移植するべきではないと、このガイドラインには書かれている。また、もし将来、それらの組織が胎児に成長する可能性があるようであれば、「モデル」と呼ぶのをやめ、代わりに「胚」と呼ぶべきであるとも指摘している。

- 抗菌薬耐性はすでに毎年70万人の死因となっており、2050年までに年間1000万人の命を奪う可能性がある。広域スペクトル抗生物質の使いすぎも、その一因である。今こそ、それらの薬に課税して需要を抑える時期なのだろうか?(インターナショナル・ジャーナル・オブ・インダストリアル・オーガニゼーション)

- 宇宙飛行は人間の脳を変化させ、灰白質と白質を再編成し、脳を頭蓋骨の中で上方に移動させる可能性がある。私たちは火星に人を送る前に、このような影響や、宇宙放射線が脳に与える影響についてもっとよく理解する必要がある。(ゼ・ランセット・ニューロロギー)

- 迷走神経がソーシャルメディアで思いがけず脚光を浴びている。この神経を刺激することの利点を誇大に喧伝するインフルエンサーたちのおかげである。残念ながら、科学的根拠はない。(ニュー・サイエンティスト)

- テキサス州のある病院は、国内で初めて医師がホログラムを介して患者を診察できるようにする予定だ。ランカスターのクレセント・リージョナル病院は、患者を診察するために医師の等身大ホログラムを投影するシステム「ホロボックス(Holobox)」を導入した。(ABCニュース)

- 人気の記事ランキング

-

- Anthropic can now track the bizarre inner workings of a large language model 大規模言語モデルは内部で 何をやっているのか? 覗いて分かった奇妙な回路

- Promotion MITTR Emerging Technology Nite #32 Plus 中国AIをテーマに、MITTR「生成AI革命4」開催のご案内

- AI companions are the final stage of digital addiction, and lawmakers are taking aim SNS超える中毒性、「AIコンパニオン」に安全対策求める声

- This Texas chemical plant could get its own nuclear reactors 化学工場に小型原子炉、ダウ・ケミカルらが初の敷地内設置を申請

- Tariffs are bad news for batteries トランプ関税で米電池産業に大打撃、主要部品の大半は中国製

- ジェシカ・ヘンゼロー [Jessica Hamzelou]米国版 生物医学担当上級記者

- 生物医学と生物工学を担当する上級記者。MITテクノロジーレビュー入社以前は、ニューサイエンティスト(New Scientist)誌で健康・医療科学担当記者を務めた。