オープンAIが新モデル「GPT-4o」、音声や映像を統合

オープンAIは、新しいAIモデル「GPT-4o」を発表した。音声や映像を統合し、応答を高速化。無料版ユーザーにも提供する。 by James O'Donnell2024.05.14

オープンAI(OpenAI)は米国時間5月13日、新しい人工知能(AI)モデル「GPT-4o」を発表した。テキストや画像に加え、スマホアプリからは音声や映像を介したリアルタイムでのやり取りに対応する。同社によると、GPT-4oは今後数週間かけて段階的に展開され、アプリとWebインターフェースからすべてのユーザーが無料で使用できるという。有料プラン(月額20ドルから)では、無料版に比べて利用上限が緩和される。

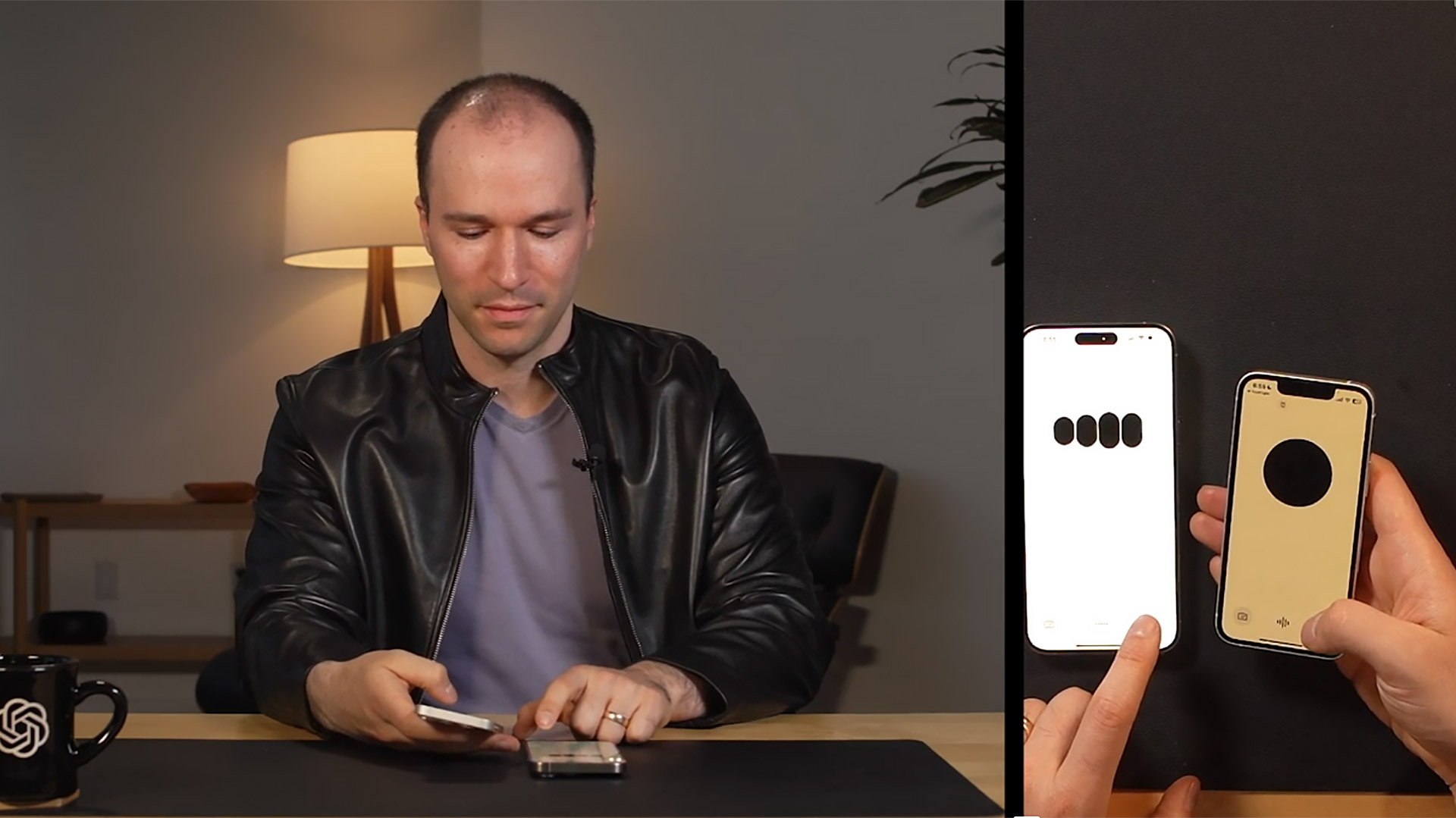

グーグルは5月15日に「グーグルI/O」を開催する予定で、最新のAI製品群の発表が予想されている。オープンAIはその前日にGPT-4oの発表をぶつけた格好だ。オンラインで開催された発表会では、同社のミラ・ムラティ最高技術責任者(CTO)がライブデモを披露した。

旧モデルのGPT-4でも音声や画像によるやり取りは可能だったが、別々のモデルを利用していたことから応答時間が長く、高い計算コストがかかっていた。新モデルのGPT-4oは、これらの機能をムラティCTOが呼ぶところの「オムニモデル 」という単一モデルに刷新。統合によって応答が速くなり、タスク間の移行もよりスムーズになったという。

この結果誕生したのが、一見するとシリ(Siri)やアレクサ(Alexa)のような会話型アシスタントだ。ただし、デモを見る限りでは、映像によるやり取りを含む複雑なプロンプト(指示テキスト)に対応できる強力な能力を持つようだ。

ムラティCTOはこのデモについて、「我々自身と機械とのインタラクションの未来を見ています」と語った。「GPT-4oは、より自然なインタラクションを実現することで、コラボレーションの未来に向けた真のパラダイムシフトを体現したと考えています」。

オープンAIの研究者であるバレット・ゾフとマーク・チェンは、GPT-4oの数あるアプリケーションについて説明した。最も印象的だったのは、ライブでの会話能力だ。モデルの応答中に対話を中断すると、モデルは応答を止めて耳を傾け、会話の内容を軌道修正する。

GPT-4oの口調を変える機能も披露された。チェンはAIモデルに「ロボットと愛に関する」寝る前の物語を読むよう頼み、直後にもっとドラマチックな口調で話すよう求めた。すると、AIモデルの口調は次第に芝居がかった声になっていった。この口調は、ムラティCTOが「説得力のあるロボットの声」に切り替えるよう要求するまでの間、続いた。

会話中にモデルが次に何を言うべきか推論する時間には予想通り短い間が何度かあったものの、そのペースは驚くほど自然で、AIの会話としては非常に優れたものだった。

GPT-4oはまた、リアルタイムでの視覚を通じた推論も実行できる。ゾフは紙に代数方程式(3x + 1 = 4)を書いている様子をスマホで撮影し、モデルにそれを解くよう要求した。GPT-4oに対し、ただ答えを示すのではなく、教師のように教えてほしいと指示した。

するとGPT-4oは「最初のステップは、片方にxを含むすべての項を持っていくことだよ」と親しげな口調で言った。「それから、プラス1の部分はどうすればいいと思う?」とも。

GPT-4oは、ユーザーとのやり取りの記録を保存する。これは同モデルが「すべての会話に対する連続性を持たせることができる」ことを意味するとムラティCTOは言う。このほか特徴的だったのは、ライブ翻訳機能、会話中に検索できる機能、リアルタイムな情報検索機能などだった。

ライブデモの性質上よくあることだが、今回のデモの最中にも何度か不具合が発生し、会話中にGPT-4oの声がぎこちなくなる場面もあった。頼んでいないにもかかわらず、司会者の服装についてもコメントしたようだ。だが、デモンストレーターが誤りを伝えるとうまく復旧した。他のモデルがまだ効果的に統合できていない複数の伝達手段に対しても、迅速かつ有益に対応できるようだ。

これまでのオープンAIのサービスでは、画像や映像を通じた推論など、優れた機能の多くは有料だった。GPT-4oの登場により、これらの優れた機能が初めて広く一般に公開されることになる。ただし、無料で利用できる範囲はまだ明らかになっていない。オープンAIは、有料プラン利用者には「無料版の最大5倍の容量が引き続き提供される 」としている。

- 人気の記事ランキング

-

- Anthropic can now track the bizarre inner workings of a large language model 大規模言語モデルは内部で 何をやっているのか? 覗いて分かった奇妙な回路

- Promotion MITTR Emerging Technology Nite #32 Plus 中国AIをテーマに、MITTR「生成AI革命4」開催のご案内

- AI companions are the final stage of digital addiction, and lawmakers are taking aim SNS超える中毒性、「AIコンパニオン」に安全対策求める声

- This Texas chemical plant could get its own nuclear reactors 化学工場に小型原子炉、ダウ・ケミカルらが初の敷地内設置を申請

- Tariffs are bad news for batteries トランプ関税で米電池産業に大打撃、主要部品の大半は中国製

- ジェームス・オドネル [James O'Donnell]米国版 AI/ハードウェア担当記者

- 自律自動車や外科用ロボット、チャットボットなどのテクノロジーがもたらす可能性とリスクについて主に取材。MITテクノロジーレビュー入社以前は、PBSの報道番組『フロントライン(FRONTLINE)』の調査報道担当記者。ワシントンポスト、プロパブリカ(ProPublica)、WNYCなどのメディアにも寄稿・出演している。