「分からなかったら聞いて」を実践するロボット新技術

人間のあいまいな指示ではロボットは判断を誤り、事故を起こす可能性がある。最近発表された「KnowNo」は、大規模言語モデルと信頼度を定量化する統計ツールを組み合わせることで、人間に助けを求めるよう訓練するモデルだ。 by June Kim2023.12.11

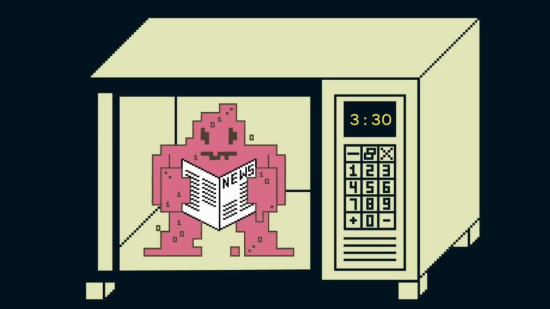

キッチンテーブルの上に2つのボウルがある。1つはプラスチック製、もう1つは金属製だ。ボウルを手に取り、電子レンジに入れるようにロボットに求めると、ロボットはどちらを選ぶだろうか?

人間は明確な説明を求めるかもしれないが、指示が曖昧だと、ロボットは金属製のボウルを電子レンジに入れて火花を散らすかもしれない。

「KnowNo(ノウ・ノー)」と名付けられた新しい訓練モデルは、命令が明確でない場合にロボットに人間の助けを求めるように教えることで、この問題に対処することを目指している。同時に、必要なときだけ説明を求めるようにし、無駄なやり取りを最小限に抑える。その結果、人の手を煩わせることなく、人の望みを理解しようとするスマートなアシスタントが生まれるのだ。

グーグル・ディープマインドの研究科学者で、この新しい手法の開発に貢献したアンディ・ゼン研究員によれば、ロボットは多くの特定の場面では力を発揮できる一方で、常識的判断を必要とする一般化されたタスクは苦手なことが多いという。

たとえば、コーラを持ってくるように頼まれたとき、ロボットはまずキッチンに行き、冷蔵庫を探し、冷蔵庫のドアを開ける必要があることを理解する必要がある。従来は、このような小さなサブステップを手動でプログラムする必要があった。そうしないと、ロボットは人が通常キッチンに飲み物を置いていることがわからないからだ。

大規模言語モデル(LLM)は、多くの常識的知識が組み込まれているため、これを解決するのに役立つとゼン研究員は言う。

今では、ロボットがコーラを持ってくるよう依頼されると、世界を常識的に理解しているLLMは、ロボットが従うべき一つひとつのステップのガイドを生成できる。

しかし、LLMの問題は、その指示がロボットにとって実行可能かどうかを保証する方法がないことだ。もしかしたら、その人はキッチンに冷蔵庫を置いていないかもしれないし、冷蔵庫のドアの取っ手が壊れているかもしれない。このような状況では、ロボットは人間に助けを求める必要がある。

KnowNoは、大規模言語モデルと信頼度を定量化する統計ツールを組み合わせることで、これを可能にする。

「ボウルを電子レンジに入れて」というような曖昧な指示が与えられると、KnowNoはまず言語モデルを用いて、次に取り得る行動を複数生成する。そして、それぞれの取りうる選択肢が最良のものである可能性を予測する信頼度スコアを作成する。

これらの信頼度推定値は、あらかじめ設定された確信度のしきい値に照らして評価される。これは、ユーザーが行動時のロボットにどの程度の自信過剰度または控えめさを求めるのかを正確に示したものだ。例えば、成功率80%のロボットは、少なくとも80%の確率で正しい判断をするはずだ。

この研究論文の最終著者であるプリンストン大学のアニルーダ・マジュンダル助教授(機械・航空宇宙工学)は、これは、さまざまな程度のリスクがある状況で役に立つという。

掃除ロボットには、あまり細かく監督しなくても済むように、あちこちで多少のミスはあっても、より自立的であってほしいと思うかもしれない。しかし、医療機器の場合は、ロボットは極めて慎重でなければならず、可能な限り高い成功レベルが伴わなければならない。

どのように進めるかについて複数の選択肢がある場合、ロボットはやみくもに続けるのではなく、一時停止して「金属製とプラスチック製、どちらのボウルを拾うべきですか?」と、明確な指示を求める。

KnownNoは3台のロボットで150以上の異なるシナリオを想定してテストされた。その結果、KnowNoで訓練されたロボットは、同じ統計計算をせずに訓練されたロボットよりも、人間の助けを必要とせず、より安定した成功率を示した。この研究について説明した論文は、11月に開催されたロボット学習学会(CoRL)で発表された。

人間の言語はしばしば曖昧であるため、ロボットに不確実性を認識し対応することを教えれば、ロボットのパフォーマンスを向上させることができる。

人間とロボットのインタラクションが専門のヴァージニア工科大学のディラン・ロージー助教授(今回の研究には関与していない)は、質問をするロボットを人間は好むことが研究でわかっているという。ロボットが助けを求めることで、ロボットがどのように行動を決定しているのか透明性が増し、より良いインタラクションにつながるのだとロージー助教授は言う。

プリンストン大学の博士課程に在籍し、この研究の筆頭著者であるアレン・レンは、KnowNoを改善する方法はいくつかあると言う。現在は、KnowNoはロボットの視覚が常に信頼できることを前提としているが、センサーに不具合がある場合は頼りにならないかもしれない。また、モデルを更新して、人間の手助けによる潜在的なエラーを考慮に入れることも可能だ。

AIが不確実性を表現できるようになれば、ロボットをより信頼できるようになるだろう、とマジュンダルは言う。「不確実性を定量化することは、多くのシステムに欠けている部分です。不確実性を定量化することで、ロボットがどれだけ安全で上手く機能するか、より確信が持てるようになるのです」。

- 人気の記事ランキング

-

- A new sodium metal fuel cell could help clean up transportation MITがナトリウム燃料電池を開発、エネルギー密度はリチウムの4倍

- Promotion Call for entries for Innovators Under 35 Japan 2025 「Innovators Under 35 Japan」2025年度候補者募集のお知らせ

- This benchmark used Reddit’s AITA to test how much AI models suck up to us 過剰なLLMの「ヨイショ度」を計測するベンチマークが登場

- A new atomic clock in space could help us measure elevations on Earth 誤差1センチ以内へ、宇宙原子時計で描く新たな地球像

- What is vibe coding, exactly? バイブコーディングとは何か? AIに「委ねる」プログラミング新手法

- june.kim [June Kim]米国版

- I’m an Editorial Fellow at MIT Technology Review, reporting on the intersection of climate, energy, and technology. I’m passionate about using data and graphics to tell compelling human stories. Previously, I produced broadcast and multimedia news at various media organizations in the United States and South Korea, covering topics ranging from immigration to music to public health.