生成AIにアーティストが反撃、汚染データでモデルを壊す新技術

AIによる画像の無断利用にアーティストたちが対抗する新たなツールが開発された。人間の目にはわからない加工を画像データに施すことで、この画像データを訓練に使った生成AIモデルを破壊できるという。 by Melissa Heikkilä2023.10.27

アーティストがこの新しいツールを使用すると、自分の作品をインターネット上にアップロードする前に、作品内のピクセルに対して目に見えない変更を追加できる。人工知能(AI)企業が、この変更を加えた作品を収集し、生成AI(ジェネレーティブAI)の訓練に使用すると、AI学習モデルが無秩序で予測不可能な状態に破壊される可能性がある。

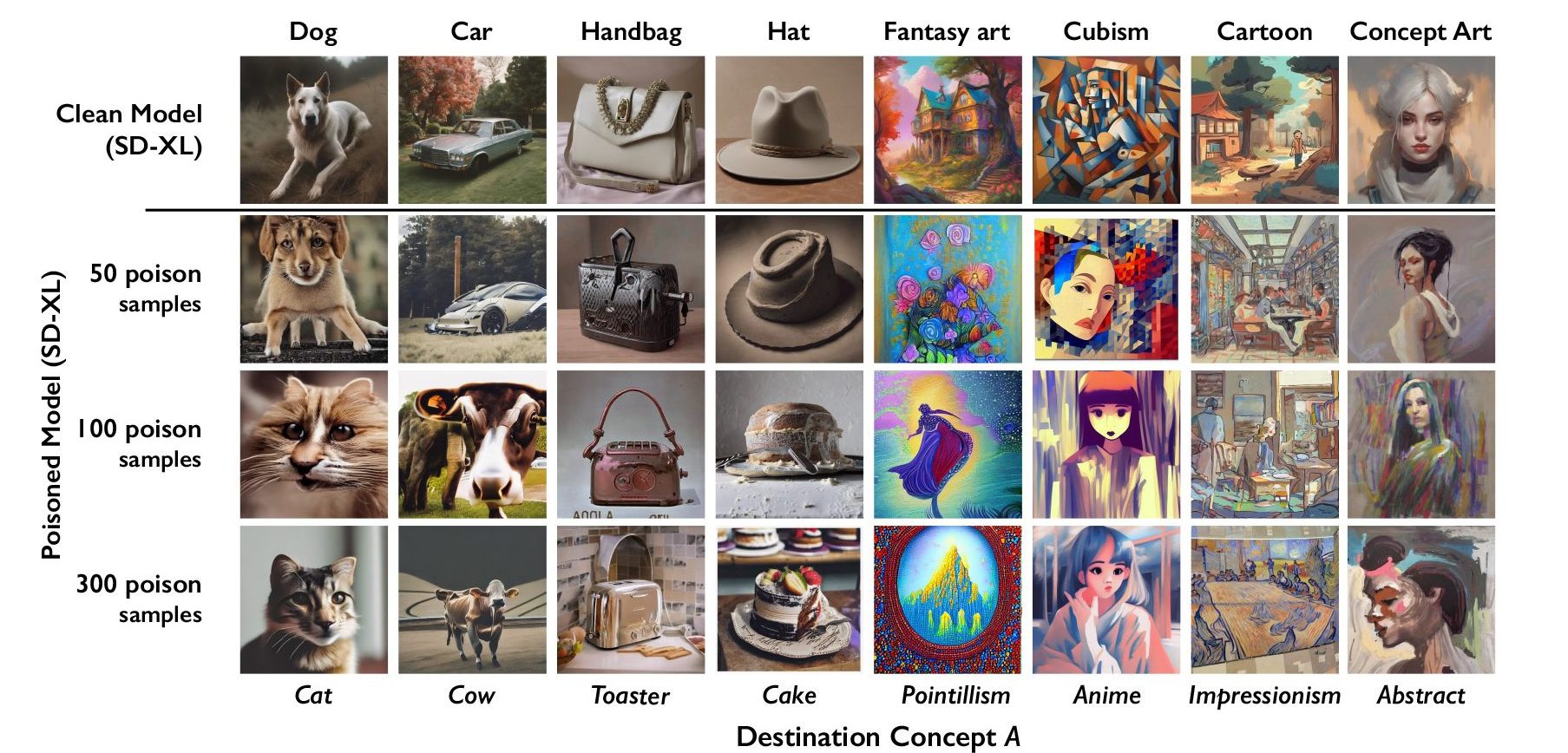

「ナイトシェード(Nightshade)」と呼ばれるこのツールの目的は、アーティストの許可なく作品を使用してモデルを訓練しようとするAI企業に反撃する方法を提供することだ。「ダリー(DALL-E)」、「ミッドジャーニー(Midjourney)」、「ステーブル・ディフュージョン(Stable Diffusion)」といった画像生成AI モデルの訓練データを本ツールで「汚染」すると、モデル出力の一部のレンダリング機能が使いものにならなくなり、以降のイテレーション機能が損傷され、犬が猫になったり車が牛になったりする事態が発生する。MITテクノロジーレビューは、コンピューター・セキュリティ会議「Usenix」の査読に提出されたこの研究の独占プレビューを入手した。

オープンAI(OpenAI)、メタ、グーグル、スタビリティAI(Stability AI )といったAI企業は、「アーティストの著作権素材と個人情報が同意も補償もないまま収集された」と主張するアーティストからの多数の訴訟に直面している。ナイトシェードの開発チームを率いたシカゴ大学のベン・ジャオ教授は、「ナイトシェードがアーティストの著作権や知的財産の軽視に対する強力な抑止力となることで、AI企業とアーティストのパワーバランスを戻す一助になることを期待しています」と語る。MITテクノロジーレビューは、メタ、グーグル、スタビリティAI、オープンAIに対し、どのような対応をとるかコメントを求めたが、回答は得られなかった。

ジャオ教授の研究チームは、アーティストが独自のスタイルをAI企業に収集されないよう「マスキング」するためのツールである「 グレイズ(Glaze)」 も開発している。グレイズもナイトシェードと同様の方法で機能する。つまり、人間の目には見えないレベルで画像ピクセルを変更し、機械学習モデルを操作することで、画像を実際の表示とは異なるものとして解釈させるというものだ。

研究チームは、ナイトシェードをグレイズに統合する考えだ。アーティストは、データ汚染ツールを使用するかどうか選択できる。同チームはまた、ナイトシェードをオープンソース化し、多くの人が独自バージョンを作成できるようにする。「より多くの人がそれを使用し、独自バージョンを作成すればするほど、このツールは強力になります」とジャオ教授は言う。大規模AIモデルのデータセットは数十億もの画像で構成される場合があるため、より多くの汚染画像がモデルの訓練用に収集されるほど、同手法が引き起こすであろうダメージはより大きくなる。

標的型攻撃

ナイトシェードは、生成AIモデルのセキュリティ脆弱性を利用している。つまり、生成AIモデルが膨大なデータ(この場合はインターネットから取得された画像)に基づいて訓練されるという事実を使っている。ナイトシェードは、訓練用画像を使い物にならなくする機能を持つのだ。

「自分の作品をインターネット上にアップロードしたいが、作品の画像をAI企業に収集されたくない」というアーティストは、作品をグレイズにアップロードし、自分の作品とは異なるアートスタイルでマスキングすることも選択できる。さらに、ナイトシェードの使用も選択できる。AI開発者が既存のAIモデルを微調整したり、新たなAIモデルを構築したりするためにより多くのデータを入手しようとインターネット上で画像を収集すると、汚染サンプルがモデル・データセットに入り込んで誤動作を引き起こす仕組みだ。

汚染データ・サンプルはモデルを操作し、例えば、帽子の画像をケーキとして、ハンドバッグの画像をトースターとして学習させることができる。テック企業は破損サンプルをひとつひとつ見つけて削除しなければならず、汚染データの削除は非常に困難だ。

研究チームは、ステーブル・ディフュージョンの最新モデルと、自分たちでゼロから訓練したAIモデルを使用し、この攻撃を検証した。ステーブル・ディフュージョンに犬の汚染画像を50枚だけ提供し、犬の画像を作成するよう命じたところ、足が多すぎたり、漫画のような顔をした奇妙な生き物の画像が出力され始めた。汚染サンプルが300枚あれば、攻撃者はステーブル・ディフュージョンを操作し、猫のように見える犬の画像などを生成されられる。

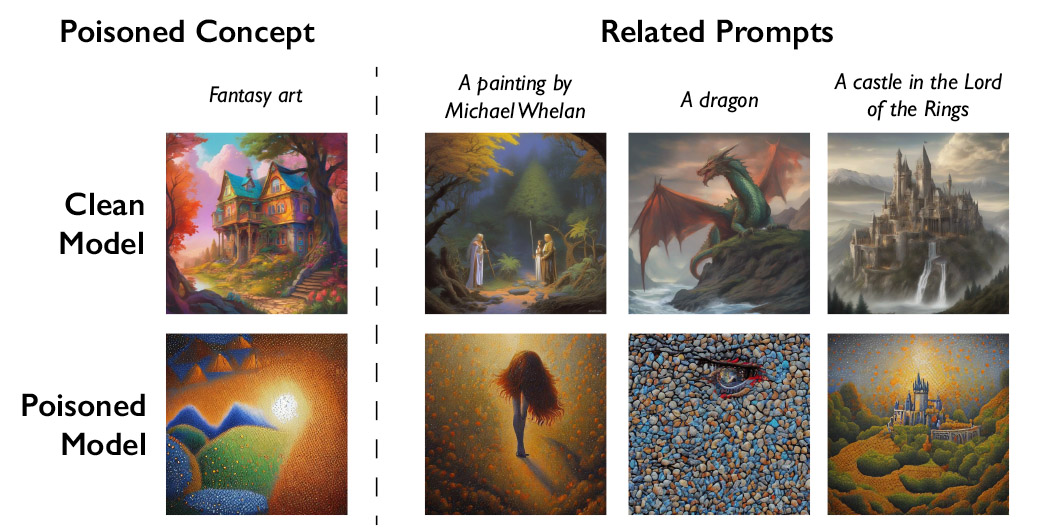

生成AIモデルは単語と単語をつなぐのが得意だが、これも汚染を拡大させるのに役立つ。たとえば、「犬」という単語だけでなく「子犬」、「ハスキー」、「オオカミ」といった類似概念すべてに影響を与えられるからだ。間接的に関連する画像も汚染攻撃の対象となる。たとえばAIモデルが「ファンタジーアート」というプロンプト(指示テキスト)に従って汚染画像を収集すると、「ドラゴン」や「ロードオブザリングの城」というプロンプトによって生成される画像も別物になるよう操作されてしまう。

ジャオ教授は、このデータ汚染技術が悪意ある用途に利用される危険性があることも認める。しかし、「数十億のデータサンプルで訓練された、より大規模な強力モデルに実際にダメージを与えるには、攻撃者は何千枚もの汚染サンプルを用意しなければならないでしょう」と同教授は言う。

AIモデルのセキュリティを研究しているコーネル大学のビタリー・シュマチコフ教授は、「こういった攻撃に対する堅牢な防御策は、まだ見つかっていません。現実には、最新の機械学習モデルに対する汚染攻撃はまだ発生していませんが、時間の問題でしょう」と言い、「今は防御対策に取り組むべき時です」と付け加える(同教授は今回の研究には関与していない)。

同じく、今回の研究に関与していないが、AIモデルのデータ・プライバシーと堅牢性を研究しているウォータールー大学のゴータム・カマス助教授は、「これは素晴らしい研究です」と言う。

今回の研究により、脆弱性が「新しいAIモデルから魔法のように消えることはなく、むしろより深刻化する」ことが分かったとカマス助教授は言う。「特にAIモデルが一層強力になって、人々の信用が増すほど、問題は深刻化する一方でしょう」。

強力な抑止力

深層学習システムのセキュリティを研究しているコロンビア大学のコンピューター・サイエンス教授であるジュンフェン・ヤン(本研究には関与していない)は、「AI企業がナイトシェードを契機としてアーティストの権利をもっと尊重し、たとえばもっとロイヤルティを支払うようになれば、大きな影響を与えられるかもしれません」と話す。

テキストから画像(Text-to-image)生成モデルを開発したスタビリティAIやオープンAIなどのAI企業は、将来バージョンのAIモデルの訓練ではアーティストが画像使用を拒否できるようにするとしている。だがアーティストたちは、それでは不十分だと言う。グレイズを使用したことのあるイラストレーター兼アーティストのエヴァ・トゥーレネントは、「オプトアウト・ポリシー(事前に同意を得ずにデータを収集し、拒否の申し出があれば停止すること)は、テック企業に全権を委ねるものであり、アーティストに大変面倒な手続きを要求するものです」と話す。

トゥーレネントは、ナイトシェードが現状を変えることを期待している。

「AI企業は、ナイトシェードの登場でよく考えるようになるでしょう。同意なしに私たちの仕事を奪えば、AIモデル全体が破壊される可能性がありますから」と、トゥーレネントは言う。

同じくアーティストのオータム・ビバリーは、ナイトシェードやグレイズといったツールのおかげで、再び安心して作品をインターネット上に投稿できるようになったと語る。ビバリーは以前、自分の作品が同意なしに人気画像データベース 「ライオン(LAION)」に収集されているのを見つけて、作品をインターネットから削除したことがある。

「アーティストが自分の作品に力を取り戻せるツールが登場したことに、本当に感謝します」と、ビバリーは言う。

- 人気の記事ランキング

-

- What is vibe coding, exactly? バイブコーディングとは何か? AIに「委ねる」プログラミング新手法

- Promotion MITTR Emerging Technology Nite #32 Plus 中国AIをテーマに、MITTR「生成AI革命4」開催のご案内

- Anthropic can now track the bizarre inner workings of a large language model 大規模言語モデルは内部で 何をやっているのか? 覗いて分かった奇妙な回路

- Tariffs are bad news for batteries トランプ関税で米電池産業に大打撃、主要部品の大半は中国製

- AI companions are the final stage of digital addiction, and lawmakers are taking aim SNS超える中毒性、「AIコンパニオン」に安全対策求める声

- メリッサ・ヘイッキラ [Melissa Heikkilä]米国版 AI担当上級記者

- MITテクノロジーレビューの上級記者として、人工知能とそれがどのように社会を変えていくかを取材している。MITテクノロジーレビュー入社以前は『ポリティコ(POLITICO)』でAI政策や政治関連の記事を執筆していた。英エコノミスト誌での勤務、ニュースキャスターとしての経験も持つ。2020年にフォーブス誌の「30 Under 30」(欧州メディア部門)に選出された。