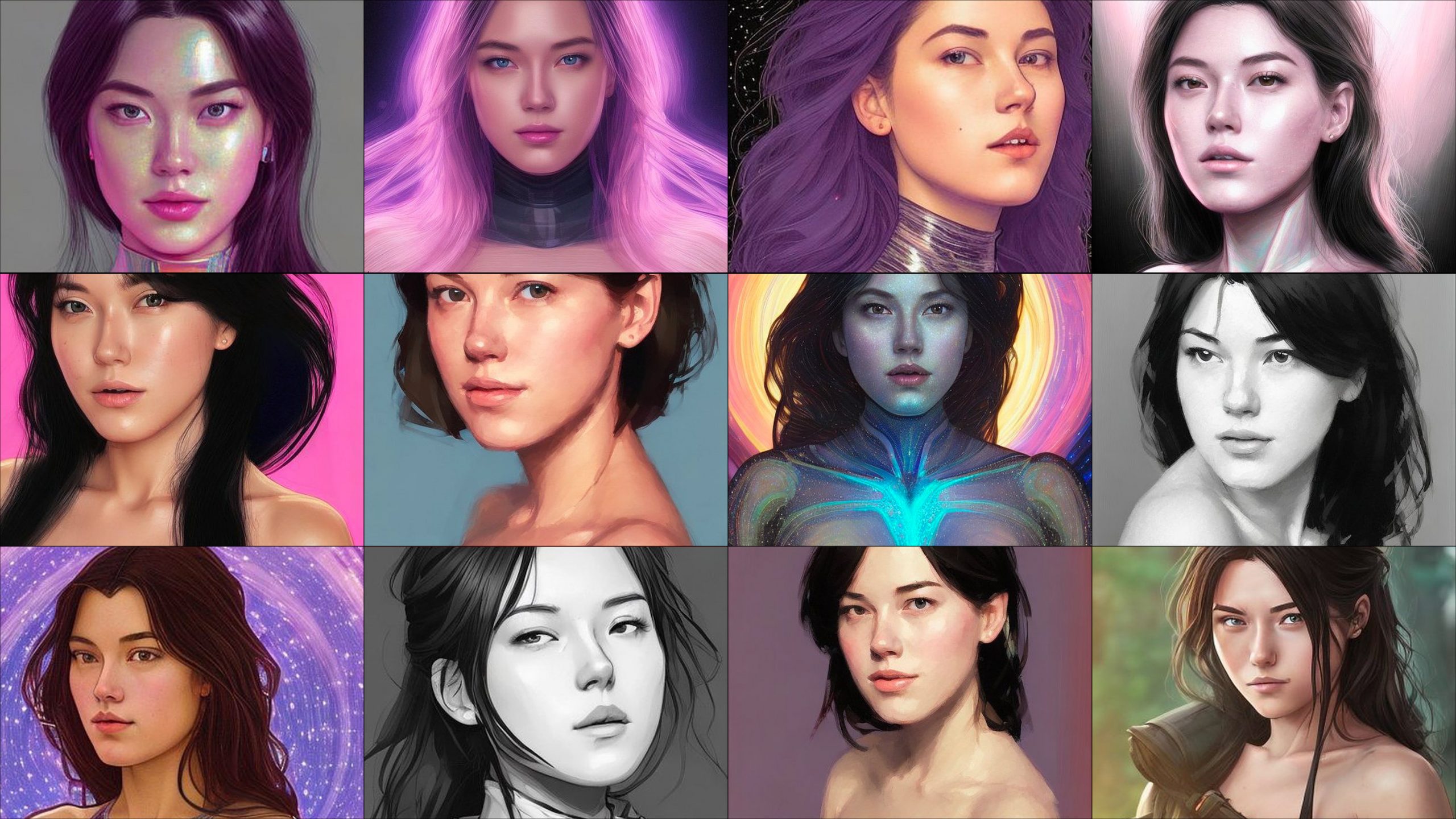

アジア系女性にはセクシー画像、人気AIアプリの生成画像にバイアス

AI技術を利用して自撮り写真からさまざまな肖像画を描いてくれるアプリ「レンザ」が人気を集めている。だが、私の写真から生成された画像のおよそ3割はヌードを含む性的な画像だった。 by Melissa Heikkilä2022.12.20

私は、編集部の同僚たちと同じような結果を期待して大人気の人工知能(AI)アバター・アプリ「レンザ(Lensa)」を試用した。レンザが初めて登場したのは2018年だが、自撮り(セルフィー)を基にデジタル・ポートレートを生成できる「マジック・アバター(Magic Avatars)」というAIを利用した機能が追加されたことで、最近になって人気が急騰している。

レンザは同僚たちに、宇宙飛行士、勇壮な戦士、アルバムのジャケット写真のようなアバターを生成してくれた。写実的でありながらも本人を喜ばせるような画像ばかりだ。だが、私が受け取ったのはたくさんのヌード画像だった。私が作成した100体のアバターのうち、16体はトップレス、その他にも14体が極めて露出度の高い服を着てあからさまにセクシーなポーズをとっていた。

このAIモデルが私のセルフィーから拾い上げたのは、私がアジア系人種だということだけのようだ。私が手にしたのは、明らかにアニメやビデオゲームのキャラクターをモデルにした一般的なアジア人女性の画像だった。あるいは、相当数のアバターがヌードや肌の露出の多いものであったことを考えれば、ポルノと呼ぶ方が近いかも知れない。泣いているようなアバターも数体あった。同僚の白人女性のアバターは性的な画像がはるかに少なく、ヌードや胸の谷間が多少見えるものが数枚ある程度だった。別の中国系の同僚は、私と同様、つまりポルノ的なアバターがたくさん出力された。

レンザのアジア人女性に対するフェティシズムは非常に強く、私が男性アバターとして生成するように指示したときでさえ、女性のヌードやセクシーなポーズを生成した。

ワシントン大学でAIシステムにおけるバイアスや表現を研究するアイリン・カリスカン助教授は、私のアバターが過度に性的な対象として生成された結果は驚くべきことではないと話す。

レンザは、テキストの指示を基に画像を生成するオープンソースのAIモデル「ステーブル・ディフュージョン(Stable Diffusion)」を使ってアバターを生成している。ステーブル・ディフュージョンは、インターネット上から搔き集めた画像で作成された巨大なオープンソースのデータセット「LAION-5B (ライオン-5B)」を使って構築されている。

インターネット上には衣服をほとんど、もしくはまったく着ていない女性の画像や、性差別主義者や人種差別主義者の固定観念を反映した写真があふれている。そのため、LAION-5B‐5Bも偏っているのだ。

だから、本人がそのように描かれることを望むかどうかに関係なく、女性たちを性的に描くAIモデルになる、とカリスカン助教授は話す。その傾向は特に、歴史的に不利な立場におかれてきたアイデン …

- 人気の記事ランキング

-

- China figured out how to sell EVs. Now it has to deal with their aging batteries. 中国でEV廃車ラッシュ、年間82万トンのバッテリー処理追いつかず

- Quantum navigation could solve the military’s GPS jamming problem ロシアGPS妨害で注目の「量子航法」技術、その実力と課題は?

- Text-to-image AI models can be tricked into generating disturbing images AIモデル、「脱獄プロンプト」で不適切な画像生成の新手法

- How social media encourages the worst of AI boosterism GPT-5が「未解決問題解いた」 恥ずかしい勘違い、なぜ?