人間が機械を作り出してからというもの、人々は機械によって滅ぼされる日を恐れてきた。スティーブン・ホーキング博士が、「人工知能(AI)は人類文明に終わりを告げる恐れがある」と警告したのも有名な話だ。だが、こうした見解を持つ人は現実を分かっていないのではないか、と考えるAI研究者も多い。研究者がAIの暴走を恐れていないわけではない。研究者には、AIの暴走がすでに起こっていると分かっている。ただその起こり方が、ほとんどの人が考えているものとは異なるということなのだ。

AIは現在、求職者をスクリーニングし、病気を診断し、犯罪容疑者を特定するまでになっている。こうした意思決定は効率性や公正さを高めるようにしなければいけないが、実際にはそうはなっておらず、逆にAIを訓練した人間のバイアスがAIによって永続化させられる、ということがしばしば起こっている。

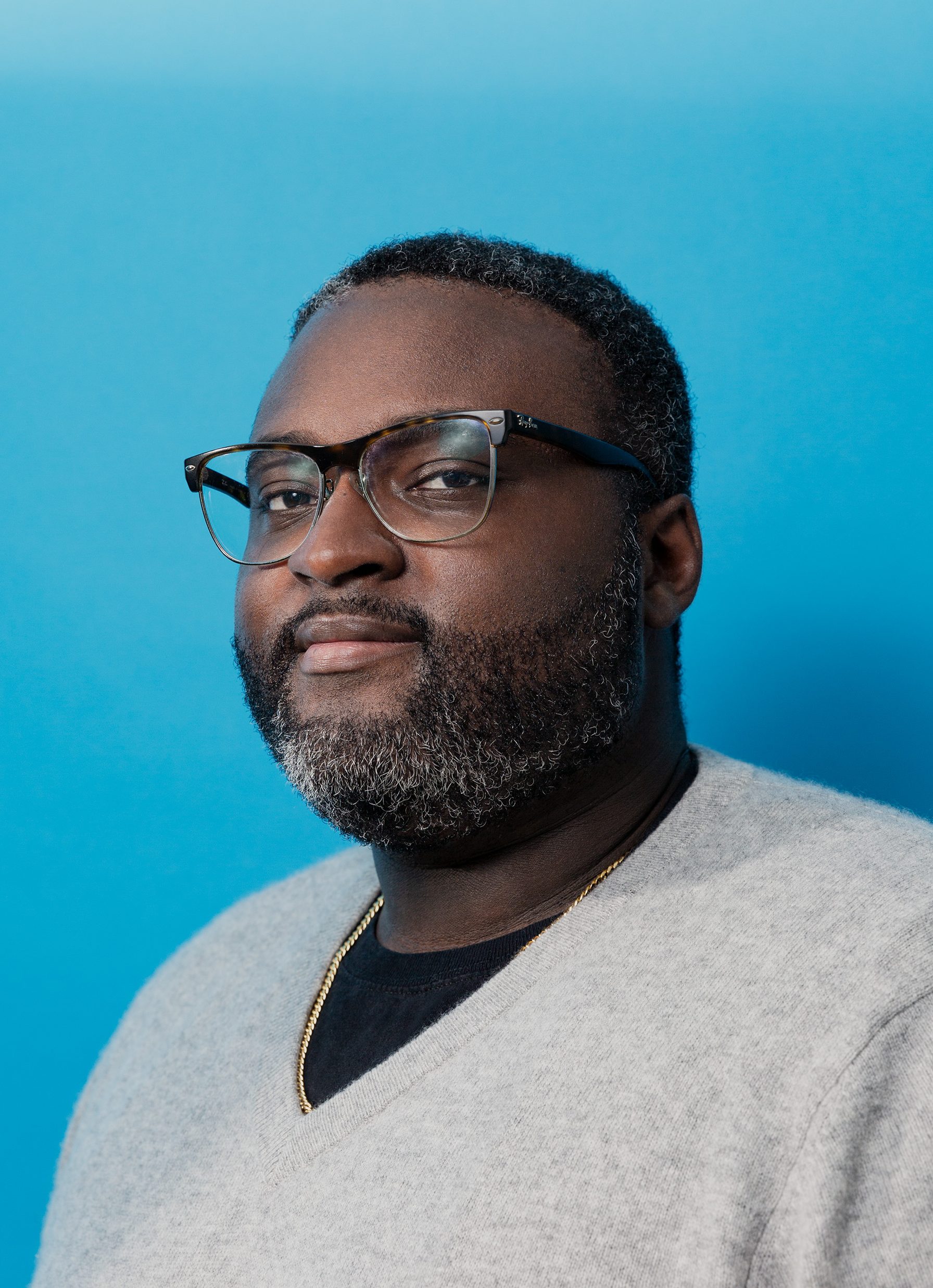

ウィリアム・アイザックは、2014年にグーグルが買収したAIスタートアップ企業であるディープマインド(DeepMind)の倫理・社会チームの上級リサーチ科学者であり、この分野で活躍するAIの専門家、社会科学者、弁護士が年に一度結集する「公平性、説明責任、透明性」会議の共同議長も務めている。アイザックに、AI開発が直面している現在の課題や潜在的な課題、その解決策について話を聞いた。

◆◆◆

——超知性を備えたAIについて心配した方がいいのでしょうか?

質問をずらしたいと思います。予測警備やリスク評価といった短期的なものであれ、スケールアップした高度なシステムといった長期的なものであれ、脅威には重複する部分があります。これらの問題には、歴史に基づいたものも多くあります。ですから、潜在的なリスクにしても、そうしたリスクに対するアプローチの仕方にしても、私たちが考えるほど抽象的なものではないのです。

警告したい分野は3つあります。おそらく最も差し迫っている問題は、価値観の整合性についてです。母集団のさまざまなかたちの嗜好や価値観を理解し、それを実現するためのシステムが、実際にはどのように設計されているのかという問題です。ここ数年、政策立案者や産業界などによって、技術的なシステムに価値観を組み込もうという試みが大規模に実施されています。こうした動きは予測警備、リスク評価、雇用といった分野に顕著です。これらのシステムには、社会を反映したバイアスが何らかの形で表れていることは明白です。理想的なシステムとは、母集団の多数の利害関係者や人々のすべてのニーズを釣り合わせるようなシステムでしょう。ですが、社会は自分たち自身の歴史と志との間で折り合いをどうつけていくのしょうか? その答えを出すのに私たちはまだ苦労している状態ですし、その問いは今後飛躍的に複雑さを増すでしょう。この問題を正しく解決することは、将来だけでなく、今この現在にとっても重要なのです。

2つ目は、実証可能な社会的利益の実現だと考えます。今の段階では、私たちが志す広範な社会的利益をAIテクノロジーが達成できるであろうことを示す経験的証拠が、まだほとんどないのです。

…

- 人気の記事ランキング

-

- Quantum physicists have shrunk and “de-censored” DeepSeek R1 量子技術でDeepSeekを55%小型化、「検閲解除」にも成功

- Promotion Innovators Under 35 Japan Summit 2025 2025年のイノベーターが集結「IU35 Summit」参加者募集

- Google’s new Gemini 3 “vibe-codes” responses and comes with its own agent グーグルが「Gemini 3」発表、質問に応じて回答形式もAIが判断

- How to help friends and family dig out of a conspiracy theory black hole 家族が陰謀論にハマったら: 専門家が語る、 5つの現実的アプローチ

- What is the chance your plane will be hit by space debris? 空からゴミが降ってくる—— 衛星10万基時代のリスク、 航空への影響は?【解説】