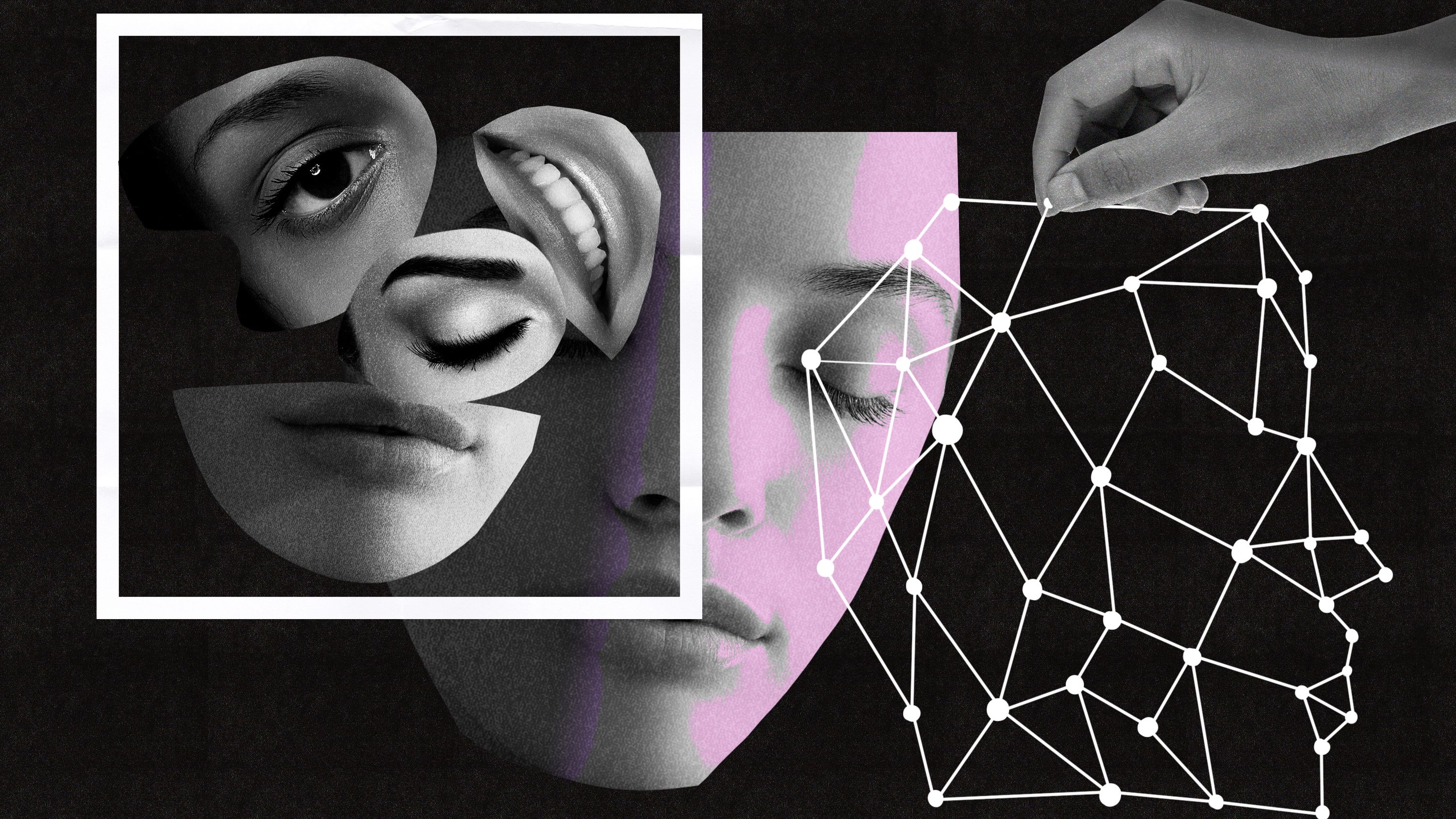

面接をする人工知能(AI)のことを耳にしたことがあるかもしれない。ひょっとすると、実際にAIを相手に面接を受けたことがあるかもしれない。「ハイアービュー(HireVue)」をはじめとする企業は、ソフトウェアが面接の映像を分析し、候補者の「雇用適性スコア」を導き出せると主張する。こうしたアルゴリズムは、顔や姿勢などの外見を評価するだけでなく、対象者が粘り強い性格なのか、あるいはチームとして働くことに長けているのかといったことを雇用主に提示する。評価は候補者の将来に大きな影響を及ぼしかねない。米国と韓国ではAIを活用した採用がより一般化しつつあり、キャリアコンサルタントは大卒者や求人者に対し、アルゴリズム相手の面接対策の訓練をするようになっている。こうしたAIテクノロジーは学校にも導入され、裁判所の映像から嘘を検知する研究にも利用されている。

だが、謳い文句の多くは科学的な合意に基づいていない。姿勢や表情の分析から最高の働き手や学生を選別できることを証明した、査読済みの確固たる研究論文は存在しないのだ(その理由の1つは、アルゴリズムの開発企業が自分たちの手法を明かしていないからだ)。その結果、感情認識の分野は過剰な盛り上がりを見せており、2023年までには250億ドル市場になると見られている。感情認識技術に対しては、テクノロジー倫理主義者や活動家から反発が起こっており、予測的量刑や、家主が借主を決めるための住宅アルゴリズムと同様の差別問題を引き起こす恐れが懸念されている。

感情認識技術を巡る過剰な宣伝に対しては、研究者自身も懸念を抱いている。多くの研究者は、微細な表情や音声を分析するなどのさまざまな手法を用いて人間の表現を識別し、解釈するという自分たちの研究が、確たる科学的根拠のない商業目的で取り入れられて利用されていると考えている。研究者らによると、政府による規制がないことは消費者だけでなく、研究者にとっても良くないことだという。

良い点と悪い点

「感情コンピューティング」とも呼ばれる感情認識技術は、まだ誕生したばかりのテクノロジーだ。AI研究者は、人間の行動様式において定量化できるものとそうでないものの線引きをするための試験をしており、感情に関する基礎科学は発展を続けてきた。ただ、現在でも複数の説があり、たとえば感情は別個に区別することができるのか、それとも連続的なものなのかといった問題がある。一方では、同じ表現が文化ごとに異なる意味を持つ場合もある。昨年7月に実施されたメタ研究は、人の顔を見ただけで感情を判断するのは不可能だと結論付けている。この研究は広く報じられており(この記事もその1つだ)、多くの記事の見出しは「感情認識は信用できない」と伝えている。

感情認識の研究者はすでに限界に気づいている。我々が取材をした研究者らは、自らの研究において、何が可能で何が不可能なのかといったことについては慎重に言葉を選んでいた。多くが強調していたのは、感情認識は個人の内的感情や経験を評価できないということだ。感情認識で可能なのは、対象となる個人の感情が他者にどう認識されるのかを推測すること、あるいはより広範囲にわたる特定集団のトレンドを示すこと(たとえばある映画が、平均的に見て別の映画よりもより好意的な反応を引き出すかどうか、といったこと)だけだ。「まともな研究者であれば、顔の動作単位を分析して …

- 人気の記事ランキング

-

- Anthropic can now track the bizarre inner workings of a large language model 大規模言語モデルは内部で 何をやっているのか? 覗いて分かった奇妙な回路

- Promotion MITTR Emerging Technology Nite #32 Plus 中国AIをテーマに、MITTR「生成AI革命4」開催のご案内

- AI companions are the final stage of digital addiction, and lawmakers are taking aim SNS超える中毒性、「AIコンパニオン」に安全対策求める声

- What is vibe coding, exactly? バイブコーディングとは何か? AIに「委ねる」プログラミング新手法

- Tariffs are bad news for batteries トランプ関税で米電池産業に大打撃、主要部品の大半は中国製