AIはまだ自然言語を理解できていない、AI2が新評価テストを提案

深層学習に基づく自然言語処理技術は最近、長足の進歩を遂げているが、人工知能(AI)は読んだ文をどれだけ本当に理解しているのだろうか?アレン人工知能研究所(AI2)の研究チームは、機械が文の意味をどれだけ理解しているのかを評価するための新たな大規模データセットを作成し、最先端の言語モデルでテストして人間の結果と比較した。 by Karen Hao2020.02.06

ごく最近まで、コンピューターが実際に意味をなす文を作ることは望めなかった。だが自然言語処理(NLP)の分野の目覚ましい発展により、現在ではボタン1つで説得力のある文章を機械が生成できるようになった。

この進歩を支えているのが、膨大な量の文章から単語の使い方と議論の構造の統計的なパターンを見つけ出す深層学習の手法である。だが、アレン人工知能研究所(AI2)が発表した新しい論文は、NLPにおいて依然として欠けている点に注意するよう呼びかけている。機械は、自分が書いている、あるいは読んでいることを本当に理解しているわけではないのだ。

自然言語の理解は、汎用人工知能(AGI)を作る壮大な挑戦における根本的課題だが、学問の世界だけでなく、消費者にも関わりのある問題となる。たとえば、最先端の自然言語モデルに基づいて作られたチャットボットと音声アシスタントは、多くの金融機関や医療機関、政府機関でインターフェイスとして採用されている。言語を本当に理解していないので、このようなシステムは誤りを起こしがちで、重要なサービスになかなかたどり着けない。

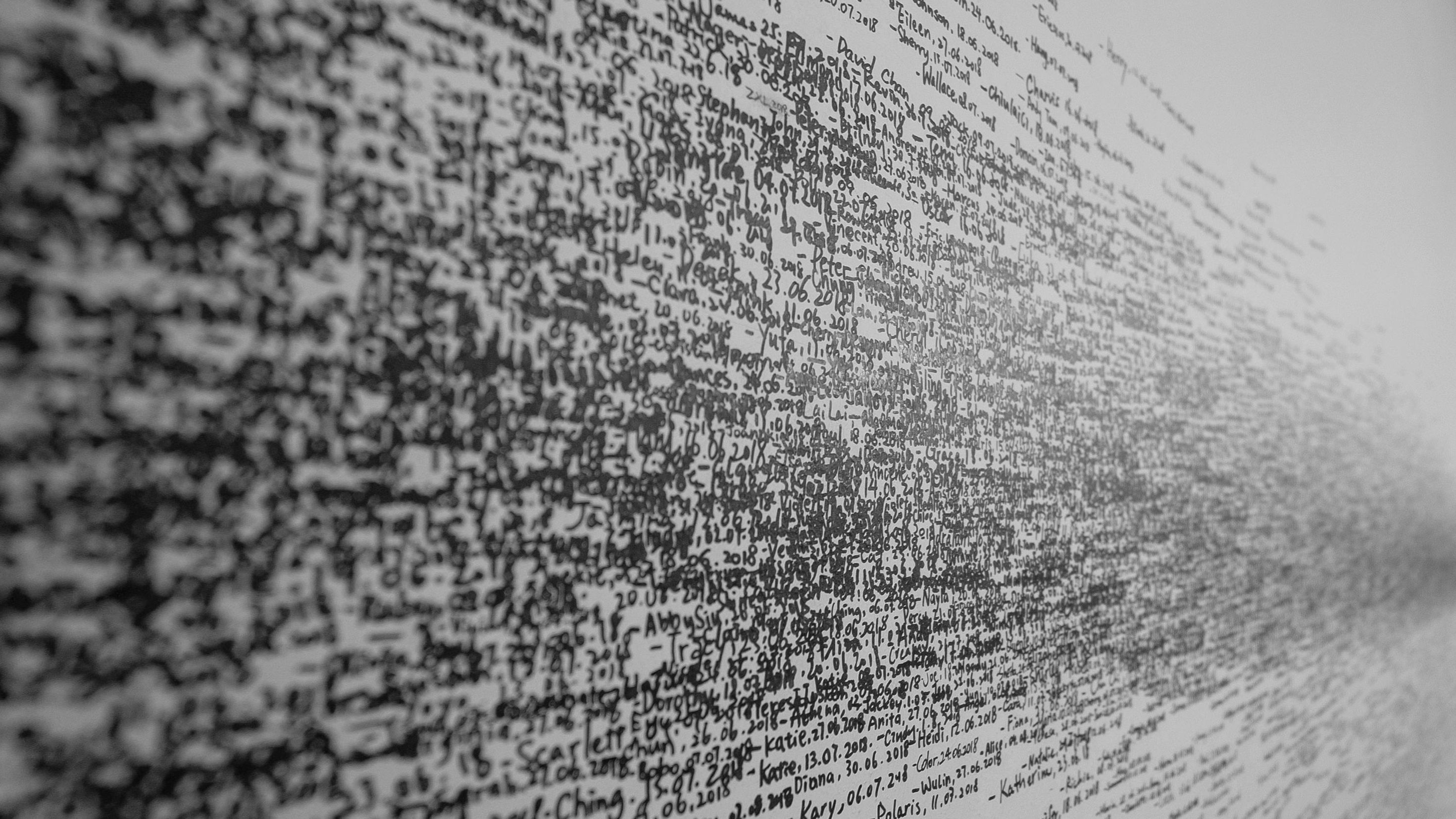

アレン人工知能研究所の研究者たちは「ウィノグラード・スキーマ・チャレンジ」(フェアチャイルド人工知能研究所のヘクター・レベスク研究員が提案した改良版チューリングテストで、スタンフォード大学のコンピューター科学者のテリー・ウィノグラード教授にちなむ)の成果を利用してこうした課題を解決しようとしている。ウィノグラード・スキーマ・チャレンジは、NLPシステムの常識的推論を評価するために2011年に開発されたテストだ。ウィノグラードでは、対になった文から成る273個の質問セットを用いられる。対になった2つの文は、1つの単語以外はまったく同じである。その単語はトリガーと呼ばれ、以下の例に見られるように各文の代名詞の意味を入れ替える。

正解を出すためには、NLPシステムは代名詞が指すものが2つの選択肢のどちらなのかを判断しなくてはならない。この場合は、1番目の文 …

- 人気の記事ランキング

-

- Phase two of military AI has arrived 米軍で導入進む「戦場のLLM」、未解決の3つの課題とは?

- A Google Gemini model now has a “dial” to adjust how much it reasons 推論モデルは「考えすぎ」、グーグルがGeminiに調整機能

- What is vibe coding, exactly? バイブコーディングとは何か? AIに「委ねる」プログラミング新手法

- The awakening of a “silent giant”: How Chinese AI models shocked the world 動き出した「静かな巨人」、中国発のAIモデルが世界に与えた驚き