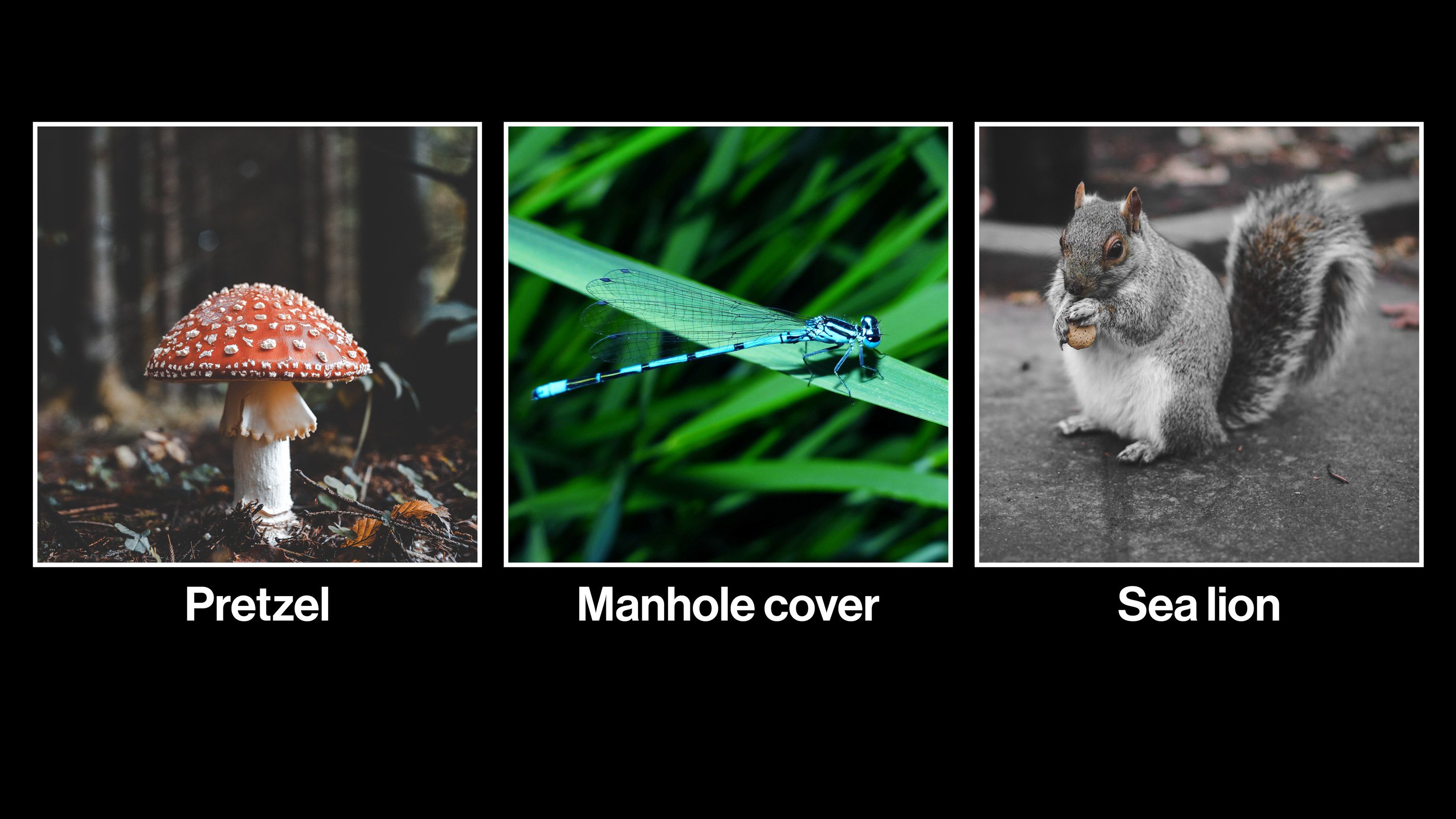

人工知能(AI)は画像に含まれる物体を認識するのに優れているが、その能力を台無しにさせるのもまた容易だ。人間の目には見えない静的ノイズの中に線や塗りをちょっと加えるだけで、画像認識システムを困らせることができてしまう。ときにはそれが致命的な影響を与えることもある。たとえば、一時停止の標識にステッカーを貼り付けことで、自動運転自動車に「制限時速70キロ」と誤認させられる。ステッカーを道路に貼り付ければ、テスラの自動運転自動車を対向車線へ誘導もできる(同じ技術で監視国家から人々の保護もできるので、いい面も悪い面もある)。

これらは「敵対的サンプル(adversarial examples)」と呼ばれ、研究者らは現在、AIシステムを敵対的サンプルから守る方法を開発しようと争って研究を重ねている。だが、この分野における最初期からの研究者の1人であるイアン・グッドフェロー博士と、グーグル・ブレイン(Google Brain)、プリンストン大学の研究者グループは昨年のある論文で、最近の研究成果はあまりに理論に偏っており、要点を外していると主張した …

- 人気の記事ランキング

-

- AI companions are the final stage of digital addiction, and lawmakers are taking aim SNS超える中毒性、「AIコンパニオン」に安全対策求める声

- Promotion MITTR Emerging Technology Nite #32 Plus 中国AIをテーマに、MITTR「生成AI革命4」開催のご案内

- Anthropic can now track the bizarre inner workings of a large language model 大規模言語モデルは内部で 何をやっているのか? 覗いて分かった奇妙な回路

- This Texas chemical plant could get its own nuclear reactors 化学工場に小型原子炉、ダウ・ケミカルらが初の敷地内設置を申請

- Tariffs are bad news for batteries トランプ関税で米電池産業に大打撃、主要部品の大半は中国製