MITテクノロジーレビューでは以前、敵対的サンプル(adversarial examples)の概念を紹介したことがある。深層学習モデルに入力されると、アルゴリズムが正常に機能しなくなるような些細な変更を加えたデータのことである。この3月に開催されたMITテクノロジーレビュー主催の年次カンファレンス「EmTechデジタル」では、カリフォルニア大学バークレー校のセキュリティ専門家、ドーン・ソング教授がこの話題を取り上げ、ステッカーを使って自動運転車に停止サインを時速約72キロメートルのサインと認識させる方法や、巧みに作ったメッセージを使ってクレジットカード番号のような重要な情報をテキストベースのモデルに出力させる方法について述べた。4月には同様に、ホワイトハット・ハッカー(悪意を持ったハッカーの攻撃を防ぐハッカー)がやはりステッカーを使ってテスラ車のオートパイロット機能を惑わせ、反対車線に誘導した方法について発表している。

近年、深層学習がますます人々の生活に浸透するにつれ、研究者は敵対的サンプルが単純な画像分類器からがんの診断システムまであらゆるものに及ぼす影響を説明してきた。中には害のないものもあるが、命に関わることもある。だが、その危険性にもかかわらず、敵対的サンプルはあまり理解されていない。研究者たちは、この問題をどう解決するのか、そもそも解決できるのかどうか、頭を悩ませてきた。

マサチューセッツ工科大学(MIT)の新しい論文により、この問題を克服する可能性のある方法が示された。この方法に従えば、敵対的攻撃を成功させることがかなり難しくなり、はるかに堅牢な深層学習モデルを作り出せるかもしれない。このことを理解するために、まず敵対的サンプルの基礎から見て行こう。

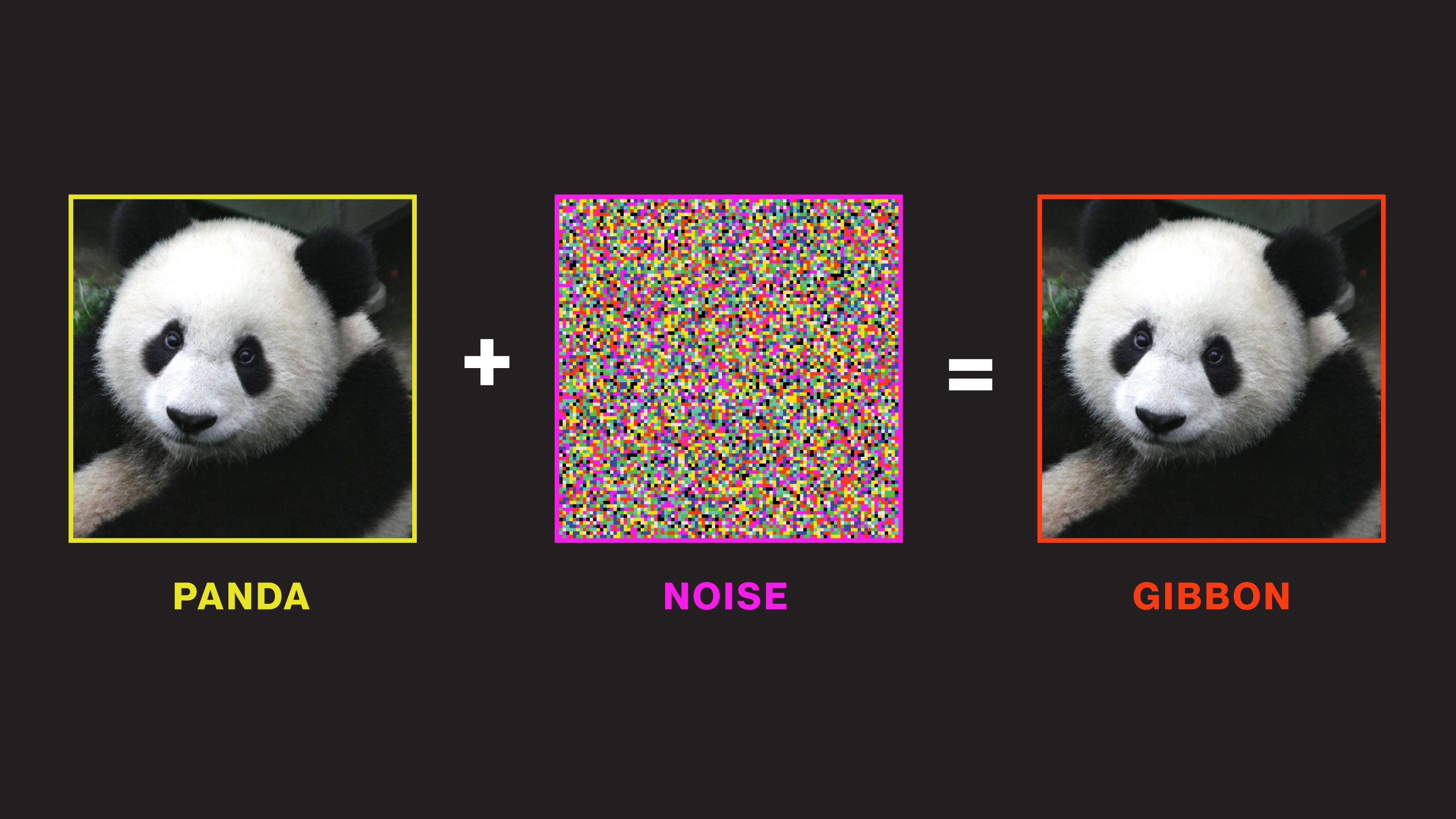

これまで何度も述べてきたように、深層学習の力は、データ内のパターンを認識する卓越した能力から来ている。ニューラルネットワークにラベル付けした何万枚もの動物写真を入力して、どのパターンがパンダに関連づけられ、どのパターンが猿に関連づけられかを学習させる。すると、ニューラルネットワークは、学習したパターンに基づいて、訓練では使われなかった新し …

- 人気の記事ランキング

-

- What is vibe coding, exactly? バイブコーディングとは何か? AIに「委ねる」プログラミング新手法

- A Google Gemini model now has a “dial” to adjust how much it reasons 推論モデルは「考えすぎ」、グーグルがGeminiに調整機能

- Meet the researchers testing the “Armageddon” approach to asteroid defense 惑星防衛の最終戦略 科学者たちが探る 「核爆発」研究の舞台裏

- Anthropic can now track the bizarre inner workings of a large language model 大規模言語モデルは内部で 何をやっているのか? 覗いて分かった奇妙な回路