2014年、MITメディアラボの研究者は「モラル・マシン(Moral Machine)」という実験を考案した。ゲーム形式のプラットホームを作成し、「トロッコ問題(Aを助けるためにBを犠牲してもよいのかという倫理学の思考実験)」のさまざまなバリエーションによって、自動運転自動車はどのように人間の生命を優先するべきかという問題に関する人々の判断をクラウドソーシングで集めるというものだ。その過程において生成されたデータは、さまざまな文化の集約的な倫理的優先事項を理解する手がかりを与えてくれる。

モラル・マシンのネット上での拡散ぶりは、当の研究者たちも予想だにしていなかった。プラットホームの立ち上げから4年後には、233の国と地域の何百万という人々から4000万件もの回答が寄せられ、道徳的な傾向に関する世界最大級の調査となった。

このほど、ネイチャー誌で発表された新しい論文のデータ分析結果は、異文化における倫理感が、文化や経済、地理的位置によっていかに多様化するかを明らかにしている。

トロッコ問題

典型的なトロッコ問題とは以下のようなものだ。暴走するトロッコが線路を猛スピードで走って来るのが見え、このままでは5人の人間に突っ込んでしまう。自分は線路を切り替えて、トロッコを別の線路へ方向転換できるレバーを使える。しかし、そうすれば別の人が非業の死を遂げることになる。レバーを引いて、1人の命を犠牲にして5人の命を救うべきか否か?

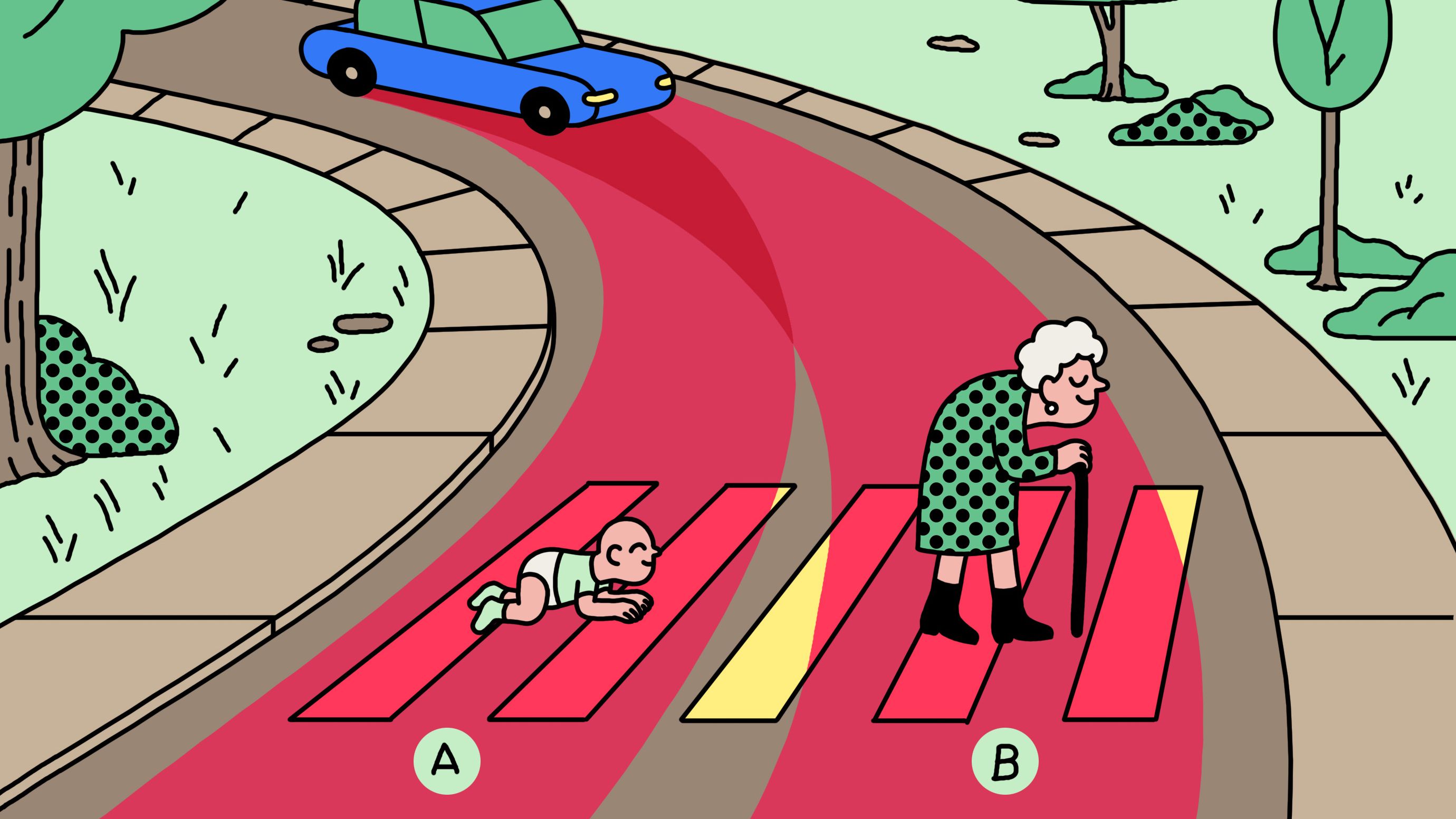

モラル・マシンは、9つの異なる比較例を示し、それぞれへの反応によって人々を分類する実験をした。自動運転自動車は、ペットよりも人間の命を優先、歩行者よりも同乗者の命を優先、少しでも多くの人の命を優先、男性よりも女性を優先、高齢者よりも若者を優先、病人よりも健康な人を優先、社会的地位の高い方を優先、不法者よりも法を守る人間を優先するべきかどうか。そして最後に、自動車はハンドルを切る(行動を起こす)べきか、それともそのまま直進する(行動を起こさない)べきか。

この実験では先の項目のような1対1の比較というよりも、さまざまな組み合わせを参加者に提示した。たとえば、自動運 …

- 人気の記事ランキング

-

- What is vibe coding, exactly? バイブコーディングとは何か? AIに「委ねる」プログラミング新手法

- A Google Gemini model now has a “dial” to adjust how much it reasons 推論モデルは「考えすぎ」、グーグルがGeminiに調整機能

- Meet the researchers testing the “Armageddon” approach to asteroid defense 惑星防衛の最終戦略 科学者たちが探る 「核爆発」研究の舞台裏

- Anthropic can now track the bizarre inner workings of a large language model 大規模言語モデルは内部で 何をやっているのか? 覗いて分かった奇妙な回路