ディープマインド、「AIの暴走」防ぐ開発ガイドラインを発表

アルファベット(グーグル)の子会社であるディープマインドの研究者たちが、人工知能(AI)の開発における安全性を保証する方法について詳細に説明した。

ディープマインドがガイドラインで目指しているのは、問題に対して独自に解決策を学習し、考え出せるような強力なAIシステムが、予期せぬ望ましくない振る舞いを始めないようにすることである。

カギとなるのは、AIシステムの意図した行動を、望ましくない結果を避ける方向に指定することだという。すなわち、予測不可能な事態に対する堅牢性をAIシステムに持たせ、必要に応じて保証を提供したり、行動を無効化したりするのだ。

AIの突飛な行動に関する研究は、学術研究における成長領域だ。奇妙な行動を開始した機械学習システムの例は豊富にあり、大抵は面白いものだ。たとえば、コーストランナーズ(CoastRunners)というゲームを動かしていたAIは、ポイントを稼ぐためにかなり奇怪な方法を編み出した。ゲームの趣旨通りにレースを終えるよりも、レースを終えずに(上に掲載したGIF画像のように)コース周辺の特定の障害物に衝突する方がよりポイントを稼げることを学んだのである。ディープマインドのAIセーフティ・チームはまた、AIが動作中に危険と思われる振る舞いを始めたら、AIが自分自身を停止させる方法についても紹介している。

AIシステムが危険なほどに自律化するのはまだまだ先の話で、過度に恐れる必要はない。いずれにせよ、AIアルゴリズムに潜在する偏見や、多くの機械学習システムのブラックボックス化問題の方が、現在、心配すべき遥かに大きな問題である。

「クラウド」を超えて——次世代データセンターは宇宙を目指す

「クラウド」を超えて——次世代データセンターは宇宙を目指す

嘘発見器のウソを暴いた

嘘発見器のウソを暴いた 高まる気候介入の現実味、

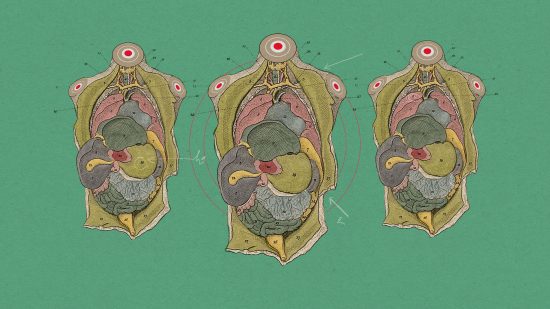

高まる気候介入の現実味、 まるでSF? 科学者が「予備の体」ボディオイドに期待する理由

まるでSF? 科学者が「予備の体」ボディオイドに期待する理由

大規模言語モデルは内部で

大規模言語モデルは内部で