YouTubeが有害コンテンツ対策に1万人体制、機械学習も活用

せっかくのアルゴリズムは効果を発揮していない。フェイスブックと同様にユーチューブ(YouTube)は、過激思想から児童虐待に至るまで様々な有害コンテンツをめぐって非難を浴び続けている。

テック界のリーダーたちは、不快なコンテンツが人の目に触れる前に、人工知能(AI)で自動的に識別することで問題を解決できるとしている。しかし今のところ、ユーザーから報告される前にユーチューブの取り組みによって見つけられているのは、不適切なクリップ動画の75%に過ぎない。

すべての不適切な動画を見つけ出すには、明らかに現在のAIの能力では不十分だ。ユーチューブのスーザン・ウォシッキーCEOは、そうしたメッセージを繰り返し発信しているようだ。新たに投稿したブログ記事でウォシッキーCEOは、ユーチューブはモデレーション(適正化)・チームの大幅な増員を進めており、有害コンテンツの対策にあたるスタッフをグーグル全体で1万人に増やすと説明している。

モデレーション・チームとは何をする人々なのだろうか? 大まかに言えば、これまでとさほど違いはない。「6月以降、当社の信頼・安全管理チームは、内容に暴力や過激思想が含まれていないか、200万本近くの動画を人力で評価しました」とウォシッキーCEOは書いている。「当社はコメントについても断固とした行動をしています。コメントを適正化するための新たなツールの立ち上げ、場合によってはコメント欄を完全に閉鎖しています」。

しかしウォシッキーCEOは、そういった取り組みすべてには別の用途があるとも説明している。 それは、AIの訓練用だ。ウォシッキーCEOは「コンテンツに対して文脈を踏まえた決定を下すには、人間の判断力は非常に重要です」として、モデレーター(モデレーション・チームのスタッフ)がどのように仕事をするのかのデータを収集することで、「機械学習のシステムを訓練し、将来は人間が削除する動画と類似した動画を特定」できるようになるだろうと付け加えた。

全体的にどこかで聞いたことがあるような話だと思うとしたら、フェイスブックが先だって有害コンテンツを取り締まるスタッフを3000人増員したせいだろう。 MITテクノロジーレビューは、 強力で確かなAIを使わず、人員を追加するだけでは不快なコンテンツに対してさほど有効ではないだろうと論じた。目を通すべき動画があまりにも膨大だからだ。

ユーチューブには、1分間で300時間分もの動画がアップロードされている。取り組みがうまくいく可能性は、フェイスブックと同じように薄いだろう。少なくとも、AIのアルゴリズムが生身のモデレーターから必要なことを全て学び終えるまでは。

- 参照元: YouTube

「クラウド」を超えて——次世代データセンターは宇宙を目指す

「クラウド」を超えて——次世代データセンターは宇宙を目指す

嘘発見器のウソを暴いた

嘘発見器のウソを暴いた 高まる気候介入の現実味、

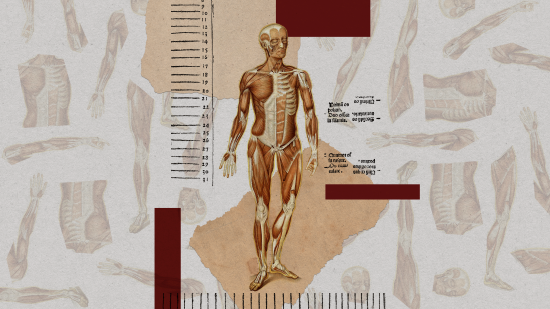

高まる気候介入の現実味、 寄稿:倫理的に調達可能な「予備の体」がもたらす医学革命

寄稿:倫理的に調達可能な「予備の体」がもたらす医学革命

生成AIによる精神疾患治療、初の臨床試験で「人間並み」効果

生成AIによる精神疾患治療、初の臨床試験で「人間並み」効果