AIは画像をどうやって認識しているのか? グーグルが「見える化」

グーグルの研究者たちが、深層学習システムの頭の中をのぞく方法を開発した。結果は興味深くて奇妙なものだ。

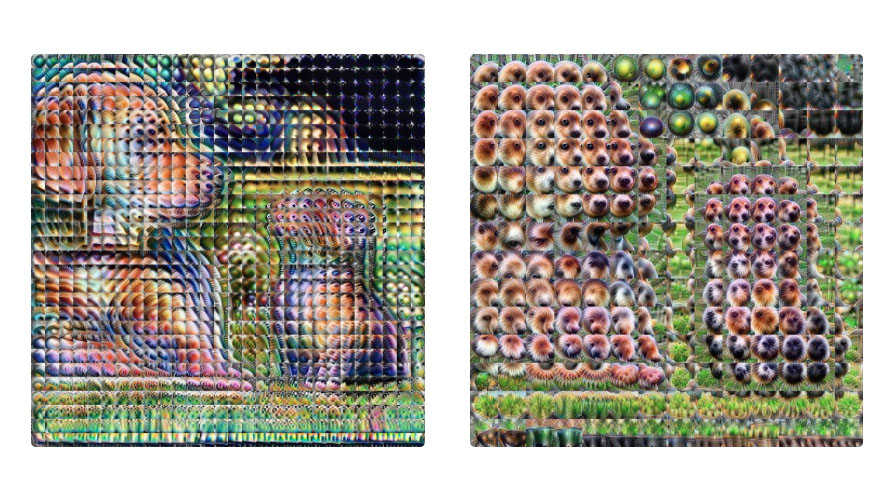

研究チームは、ニューラル・ネットワークがどのように決断を下しているのかを人々がより把握しやすくするためのツールを、いくつかの手法を組み合わせて作成した。画像分類に使用すると、たとえば子猫やラブラドールが何であるかをネットワークがどのように理解しているのか視覚化してくれる。その結果が上の画像であるが、奇妙としか言いようがない。

こうした研究が重要なのは、深層学習は強力だが、不透明であるからだ。深層学習でたとえば自動車を運転させようとする場合、その不透明さは問題になる。そこで、画像認識の際の決断を視覚化できれば、なぜ自律運転自動車が重大なエラーを犯したのかを解明するのに役立つ可能性がある。加えて、決断が正しかったとしても、なぜその決断が下されたのかを人間は知りたがるものだ。

だが、機械に自身のことを説明させる必要があると、誰もが考えているわけではない。 昨年の「神経情報処理システム (NIPS)」 会議での議論において、 フェイスブックのAI研究を率いるヤン・レクン博士は、機械の行動にのみ焦点を当てるべきだと主張している。つまるところは、人間が下す決断についても常に説明ができるわけではないのだ。

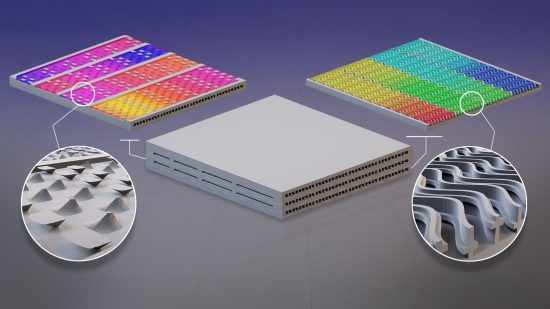

「クラウド」を超えて——次世代データセンターは宇宙を目指す

「クラウド」を超えて——次世代データセンターは宇宙を目指す

嘘発見器のウソを暴いた

嘘発見器のウソを暴いた 高まる気候介入の現実味、

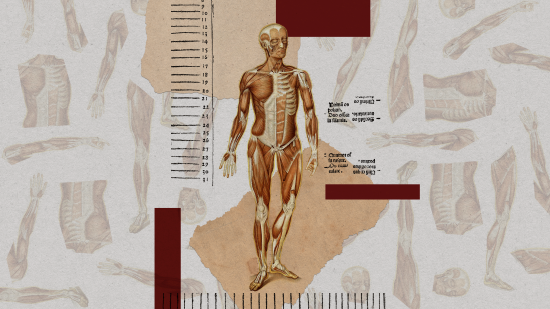

高まる気候介入の現実味、 寄稿:倫理的に調達可能な「予備の体」がもたらす医学革命

寄稿:倫理的に調達可能な「予備の体」がもたらす医学革命

生成AIによる精神疾患治療、初の臨床試験で「人間並み」効果

生成AIによる精神疾患治療、初の臨床試験で「人間並み」効果