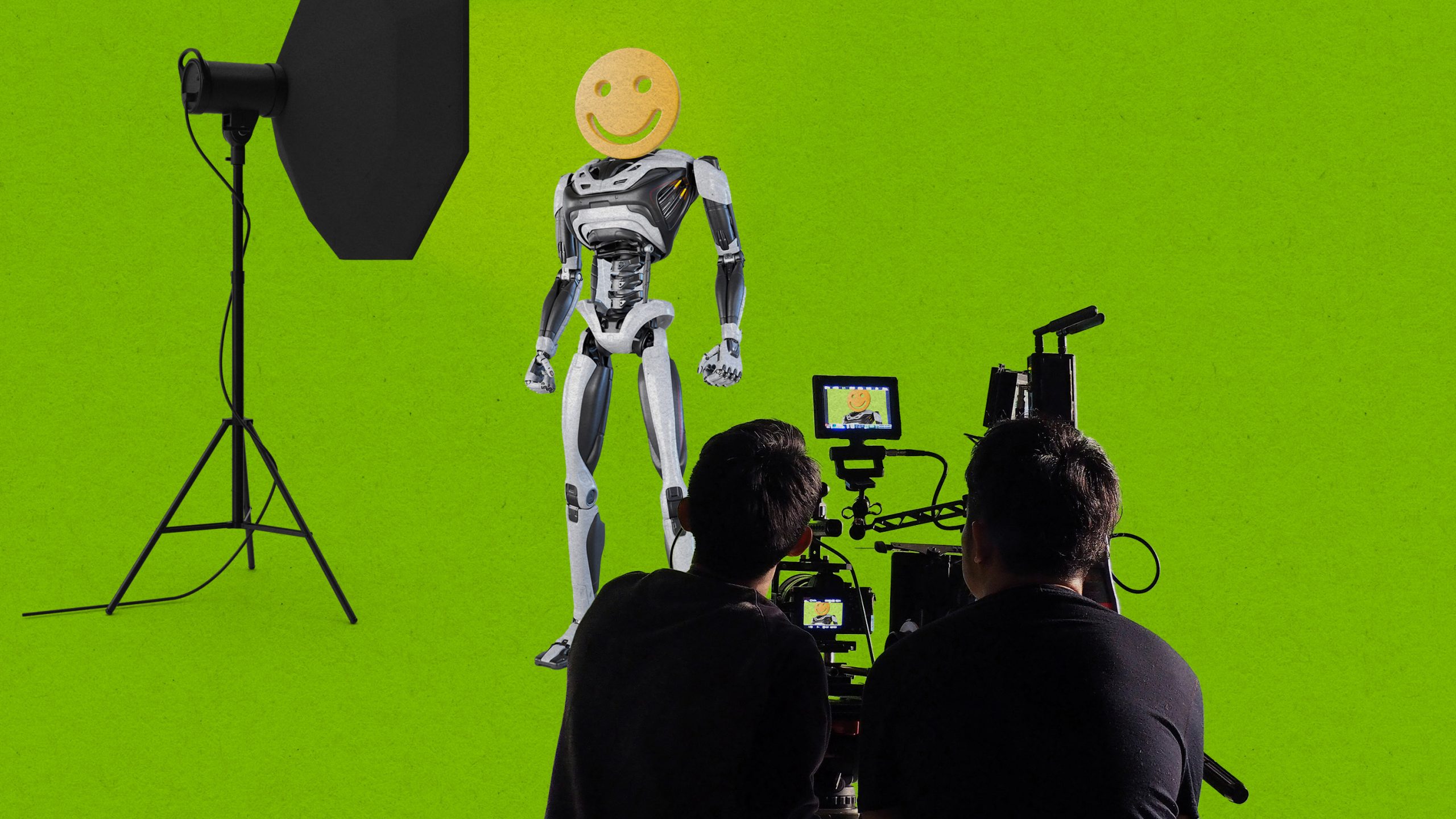

すごすぎる人型ロボット動画、騙されないためのチェックポイント

人型ロボットを開発するスタートアップ企業に多額の資金が注ぎ込まれている。だが、企業が資金調達のために公開する派手な動画は、誇張されていることが多い。注意すべきポイントを専門家に聞いた。 by James O'Donnell2024.09.03

- この記事の3つのポイント

-

- 人型ロボットの開発が加速し、「人型ロボットの夏」が到来

- 魅力的な人型ロボット動画は最高のマーケティング・ツール

- ロボットの自律性や撮影された環境、積載能力などに注目すべき

この記事は米国版ニュースレターを一部再編集したものです。

ご存じないかもしれないが、私たちは今、「人型ロボットの夏」を生きている。少なくとも、この分野の研究をリードするカリフォルニア大学バークレー校の非凡なロボット工学者、ケン・ゴールドバーグ教授はそう感じている。ゴールドバーグ教授はこれまでに、いくつかのロボット企業を創業してきた。今、人型ロボット・スタートアップ企業に資金が注ぎ込まれている。たとえばフィギュアAI(Figure AI)は今年これまでに、6億7500万ドルを調達した。アジリティ・ロボティクス(Agility Robotics)は試験段階を終え、ジョージア州にあるスパンクス(Spanx)の施設で、自称「初の人型ロボット部隊」の稼働を開始した。

しかし、本当に人型ロボットの夏を感じさせてくれているのは、動画である。毎月のように雰囲気があって未来的な新しい動画が登場し、その中で人型ロボットが熱烈に(あるいはゾッとするほど)カメラを見つめていたり、飛び跳ねたり、モノをいくつかの山に仕分けしたりしている。時にはしゃべることさえある。

このような動画は今、ロボット工学の世界で増えている。ゴールドバーグ教授が言う通り、自宅で人型ロボットを起動してチャットGPT(ChatGPT)の最新版と同じように遊ぶことはできない。そのため、資金調達を目指しているスタートアップ企業や学術機関など、人工知能(AI)の波に飛び乗りたい、あるいは自らの進歩を実際に示したいと考えている者たちにとって、優れた人型ロボット動画は利用可能な最高のマーケティング・ツールなのだ。「イメージ、ビジュアル、動画は、大きな役割を果たしています」と、ゴールドバーグ教授は言う。

しかし、それらの動画にはいったい何が映っているのだろうか? 私は今年、何十本もの動画を見たが、正直なところ、感動と恐怖と退屈の間を行ったり来たりすることが多かった。私としては、より洗練された視点を提供することで、問いかけるべき適切な疑問を見つけるのに役立つものであってほしかった。ゴールドバーグ教授が快くその手助けをしてくれた。

映像マジックに気をつけろ

まず、基本的なことをいくつか話そう。最も重要なことは、ロボットが自律的にタスクを実行しているのではなく、画面の外の人間によって遠隔操作されていないか、知ることである。残念ながら、企業が動画の中でそれを開示していない限りそれはわからないし、必ずしも開示されていない。

2つ目の問題は選択バイアスである。完璧なショットを撮るために、何回の撮り直しが必要だったのか? 人型ロボットが感動的な能力でモノを仕分ける姿を披露していても、200回挑戦してやっとその作業を成功させていたとしたら、それは問題だ。

最後に、動画はスピードアップされていないだろうか? そのロボットの能力にあまり関係がない部分をスキップしているのであれば、たいていの場合、それはまったく合理的なことである(「塗料が乾く様子は見たくありません」と、ゴールドバーグ教授は言う)。しかし、もし意図的に何かを隠蔽したり、ロボットを実際よりも効果的に見せたりするために動画がスピードアップされているのであれば、それは警戒に値する。理想を言えば、そのような編集をすることを決めたロボット工学企業や研究室は、すべてを開示すべきである。

手に注目する

人型ロボット動画の中で私が気づいたお決まりの映像は、指を緩やかに丸めて拳にすることで、ロボットの手を誇示する手法だ。そのように多くの使用可能な関節を持つロボットの手は、実際に産業用ロボットで見られるようなグリッパーよりも複雑であると、ゴールドバーグ教授は話す。 しかし、それらの人型ロボットの手は、動画で時々示されているようなことはできないかもしれないという。

たとえば、人型ロボットが歩きながら箱を抱えているシーンがよく見られる。そのショットは、箱の下に指を入れて持ち上げるという、人間がするような手の使い方をしているように思えるかもしれない。しかしゴールドバーグ教授によれば、多くの場合、ロボットは実際のところ肩から力を伝えて箱を水平に挟み込んでいるだけであるという。それでも機能はするが、私が想像していた方法とは違う。ほとんどの動画には、手が何か作業をしているシーンがあまり映っていない。当然ながら、手の器用な動きには、とてつもなく複雑なエンジニアリングが必要だからだ。

環境を評価する

最新の人型ロボット動画は、ロボットがとても上手に歩いたり、さらには走ったりできるようになっていることを証明している。「人間を追い越すかもしれないロボットが、おそらくもうすぐ登場します」と、ゴールドバーグ教授は言う。

とはいえ、動画の中のロボットがどのような環境にいるのか、気をつけて見ることが重要である。床にモノが散乱していたり、チリが落ちたりしていないか? ロボットの邪魔になる人はいないか? 通り道に階段や設備の一部、滑りやすい表面はないか? おそらくないだろう。ロボットがその(確かに感動的な)妙技を披露するのは、一般的に手つかずのピカピカな環境であり、ロボットが人間と一緒に働くとされている倉庫や工場などの場所とはまったく異なっている。

空箱に気をつけろ

人型ロボットの身体能力は、映像から想像できるほどには強くないことがある。私は、腕を伸ばせば届く距離にあるハンマーを持つことさえ、多くの人型ロボットが苦労すると聞いて驚いた。人型ロボットは、重量物を体の中心近くで抱える場合はより多くのモノを運ぶことができるが、腕を伸ばした状態では、積載能力が劇的に変化する。ロボットがベルトから別のベルトへと箱を移動させる様子を見るときは、このことを念頭に置いてほしい。 それらの箱は空箱かもしれないからだ。

人型ロボットの大げさな宣伝の中には、他にも投げかけるべき疑問が数え切れないほどある。中でも特に重要なのは、最終的にいくらの費用がかかる可能性があるのかということだ。しかし、ロボットが私たちの世界により浸透するようになる中で、少なくともこの記事がいくつかの視点を提供することを願っている。

「オープンソースAI」の定義がついにできた

オープンソースAIは現在、いたるところに存在する。問題は、実際のところそれが何なのかということについて、関係者の意見が一致していないことだ。今、私たちはようやくその答えを得られたかもしれない。オープンソースであることの意味の裁定者を自任するオープンソース・イニシアティブ(OSI)が、新しい定義を発表したのだ。OSIは、立法者がAIのリスクから消費者を保護するための規制を策定する上で、この定義が助けとなることを願っている。この定義ではオープンソースAIシステムを、許可を得ることなくどのような目的にも使用することが可能であり、研究者が構成要素を検査してそのシステムの仕組みを研究できるものとしている。定義では使用された訓練データについて透明性を求めているが、モデルの作成者に対してそのようなデータの全面的な公開は義務付けていない。

これまでオープンソースの基準がなかったことで、ある問題が生じていた。オープンAI(OpenAI)とアンソロピック(Anthropic)は自社のモデル、データセット、アルゴリズムを非公開とする決定を下しているので、この2社のAIがクローズドソースであることは分かっている。しかし、一部の専門家は、メタとグーグルの誰でも自由にアクセスし、検査や改造ができるモデルも、真のオープンソースではないと主張する。ユーザーがそれらのモデルを使ってできることがライセンスによって制限されていることと、訓練データセットが公開されていないことがその理由である。合意された定義が役に立つ可能性がある。詳しくは、この記事を読んでほしい。

AI関連のその他のニュース

- AIをファインチューニングして繁栄する方法。AIは私たちを好景気に沸く未来へと続く道に導いてくれるかもしれないが、そこに至るまでには、いくつかの重大な軌道修正が必要になる 。(MITテクノロジーレビュー)

- 新たなシステムにより、ロボットが人工皮膚に頼らず「人間による接触」を感じ取る。最も高性能なロボットでも、人に触れられたことを感じとることは難しい。ロボットと効果的にやりとりするには、通常、コンピューター科学の学位か、少なくともタブレットが必要だ。ハイテク人工皮膚に覆われていなくても接触を感知し、解釈できるようになったロボットのおかげで、それが変わるかもしれない。(MITテクノロジーレビュー)

- 主張:AIは障がい者にとってゲームチェンジャーになる可能性がある。AIベースのソフトウェアは真に支援テクノロジーとなり得るものだ。それがなければ不可能だったことを、人々ができるようにするという事実が、過小評価(あるいは過小報告)されているように思える。(MITテクノロジーレビュー)

- 写真は現実を写すという私たちの基本的な前提が、はかなく消えようとしている。リアルで信憑性のあるフェイク写真を作るのは、今や明らかに簡単なことになった。私たちはそれが意味することに対して準備ができていない。(ザ・ヴァージ)

- 人気の記事ランキング

-

- What’s on the table at this year’s UN climate conference トランプ再選ショック、開幕したCOP29の議論の行方は?

- Google DeepMind has a new way to look inside an AI’s “mind” AIの「頭の中」で何が起きているのか? ディープマインドが新ツール

- Google DeepMind has a new way to look inside an AI’s “mind” AIの「頭の中」で何が起きているのか? ディープマインドが新ツール

- This AI-generated Minecraft may represent the future of real-time video generation AIがリアルタイムで作り出す、驚きのマイクラ風生成動画

- ジェームス・オドネル [James O'Donnell]米国版 AI/ハードウェア担当記者

- 自律自動車や外科用ロボット、チャットボットなどのテクノロジーがもたらす可能性とリスクについて主に取材。MITテクノロジーレビュー入社以前は、PBSの報道番組『フロントライン(FRONTLINE)』の調査報道担当記者。ワシントンポスト、プロパブリカ(ProPublica)、WNYCなどのメディアにも寄稿・出演している。