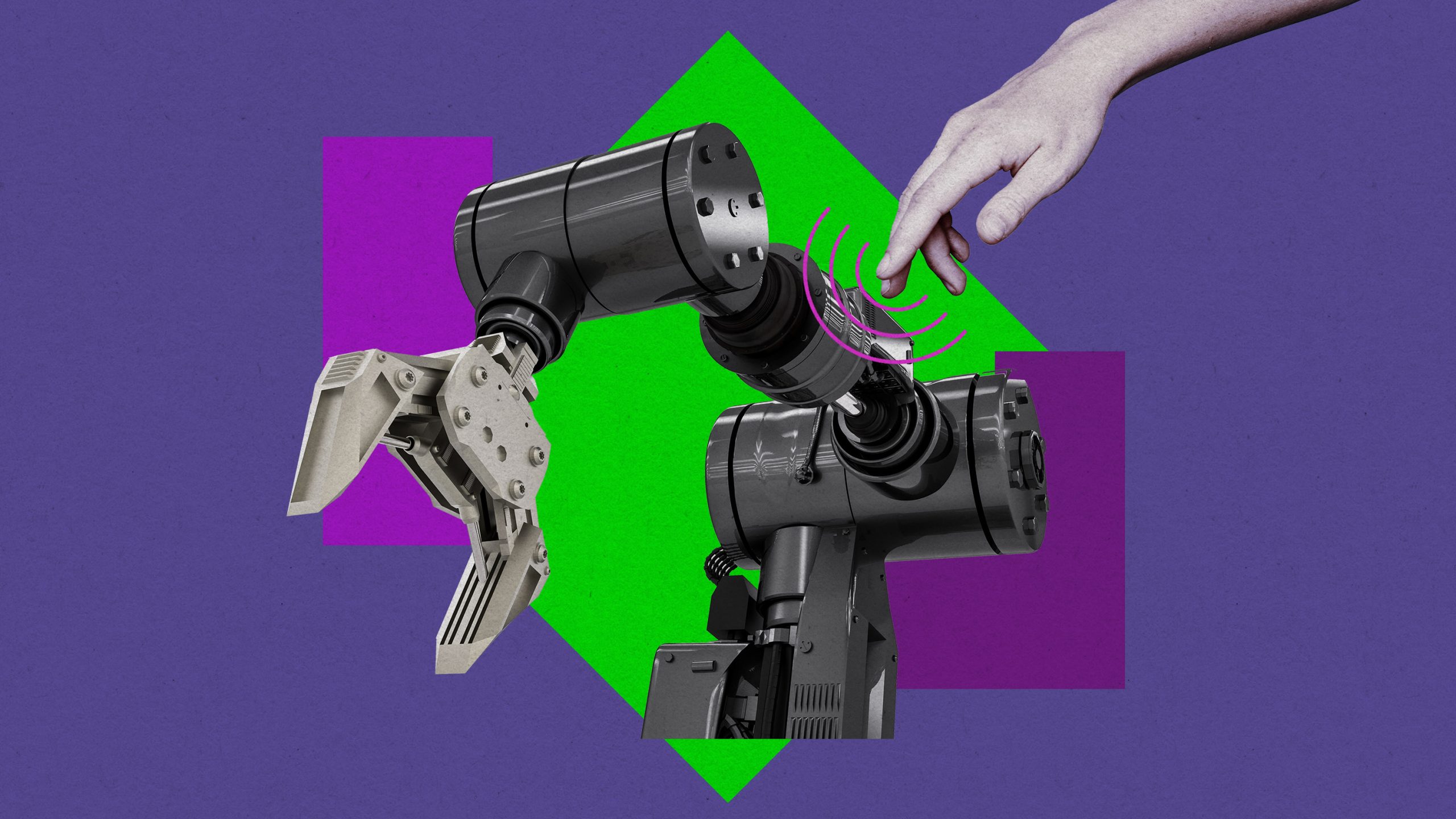

「人工皮膚」なしで触感を実現、ロボット全身がタッチスクリーンに

ドイツの研究チームが人工皮膚を使わずにロボットが触られている場所を検知する方法を開発した。ロボットとよりスムーズかつ直感的にやり取りできる方法として有望かもしれない。 by James O'Donnell2024.08.23

- この記事の3つのポイント

-

- 人工皮膚なしでロボットが人の触れ方を感知できる技術が開発された

- この技術はロボットの関節にかかる圧力を測定しAIで分析する

- ロボットの全身がタッチスクリーンのようになり直感的な操作が可能になる

どんなに高性能なロボットでも、人に触れられたことを感じとることは難しい。ロボットと効果的にやりとりするには、通常、コンピューターサイエンスの学位か、少なくともタブレットが必要だ。しかし、ハイテク人工皮膚で覆われていなくても人間のタッチを感じとって解釈できるロボットのおかげで、状況は変わるかもしれない。 人間とより直感的にやりとりできるロボットの実現に向けた大きな一歩だ。

ドイツ航空宇宙センター(German Aerospace Center )が主導する新たなアプローチが最近、サイエンス・ロボティクス (Science Robotics)に掲載された。研究の内容を理解するため、私たちの体が「触れられたこと」を感知するときの2つのメカニズムについて考えてみよう。左手の掌を上に向けて、左手の小指を軽く押すと、まず初めに指先の皮膚を通してその感触に気づくだろう。これは分かりやすい。手と指だけでも感覚を感じ取る数千の組織があるのだから。ロボット工学者は、ロボットを人工皮膚で覆うことでこれを再現しようとすることが多いが、これは高額なうえ、衝撃や過酷な環境に耐えられない場合もある。

しかし、より強く指を押すと、指関節やその他の関節を通して触れられたことを感じとる、もうひとつのメカニズムがあることに気づくだろう。その感覚、つまりロボット工学の専門用語で使えば「トルクの感覚」こそが、ドイツ航空宇宙センターの研究チームが新たなシステムで再現したものである。

同チームが作ったロボットアームには 6つのセンサーが搭載されており、各センサーはデバイスのどの部分であってもそこにかかる極めて小さな圧力を感知できる。その圧力の強さと角度を正確に測定した後、一連のアルゴリズムによって人がロボットに触れている場所をマッピングし、何を伝えようとしているのか正確に分析できる。たとえば、人がロボットアームの表面のどこにでも指で文字や数字を描くことができて、ロボットはその指の動きから指示を解釈できるようになるかもしれない。ロボットのあらゆる部分がバーチャルなボタンとして利用できるようになるかもしれない。

これはロボットのあらゆる部分が、実質的にタッチスクリーンになるということだが、コストがかからず破損することもない。また配線も不要だ。ドイツ航空宇宙センターの研究員でこの研究の主執筆者であるマゲド・イスカンダルは、次のように語る。

「人間がロボットと密接にやり取りしながらロボットに指示を出すという双方向のやり取りはまだ最適といえる状況ではありません。なぜなら、人が入力デバイスを必要とするからです。もしロボットそのものを入力デバイスとして使えれば、やり取りはよりスムーズになるでしょう」。

このようなシステムは、触覚だけでなく、ロボットとのコミュニケーションの新たな形を、より安価でシンプルに提供できるようになるかもしれない。ベンチャーキャピタルから数十億ドル規模の支援を受け続けているヒューマノイドのような大型ロボットにとって、特に重要なものとなる可能性がある。

ロボット工学者で、バイオロボティクス研究所(BioRobotics Institute)でニューロ・ロボティクス・タッチラボラトリー(Neuro-Robotic Touch Laboratory)を率いるカロジェロ・マリア・オッド准教授は今回の成果を、「センサー」「数学を見事に活用した感覚器官の配置」「新しい人工知能(AI)の手法」といったものをうまく組み合わせた重要な進展であると語る(同準教授は今回の研究には関与していない)。オッド准教授は、開発にはるかに多くの資金が必要なハードウェアよりも、ソフトウェアへの投資が主となるため、かなり早い段階で商用化できる可能性があると語る。

ただし、この手法には注意点がある。ひとつは、この新たなモデルは一度に2点を超える接触には対応できないということだ。工場フロアのようにしっかり制御された環境では問題にならないかもしないが、人間とロボット相互のやり取りが予測しにくい環境では、この点が制約となる可能性がある。また、人が触れた感触をロボットに伝達するのに必要なタイプのセンサーは、市販されてはいるものの、数万ドルするような場合もある。

しかし、オッド准教授は全体像として、皮膚ベースのセンサーと関節ベースのセンサーが統合され、ロボットがより包括的な触覚を得る未来を思い描いている。

「私たち人間や他の動物は、この2つのソリューションの統合を成し遂げました。現実世界で稼働するロボットも、この2つを使って、安全かつスムーズに世界と対話し、学習するようになることを期待しています」。

- 人気の記事ランキング

-

- What’s on the table at this year’s UN climate conference トランプ再選ショック、開幕したCOP29の議論の行方は?

- Google DeepMind has a new way to look inside an AI’s “mind” AIの「頭の中」で何が起きているのか? ディープマインドが新ツール

- Google DeepMind has a new way to look inside an AI’s “mind” AIの「頭の中」で何が起きているのか? ディープマインドが新ツール

- This AI-generated Minecraft may represent the future of real-time video generation AIがリアルタイムで作り出す、驚きのマイクラ風生成動画

- ジェームス・オドネル [James O'Donnell]米国版 AI/ハードウェア担当記者

- 自律自動車や外科用ロボット、チャットボットなどのテクノロジーがもたらす可能性とリスクについて主に取材。MITテクノロジーレビュー入社以前は、PBSの報道番組『フロントライン(FRONTLINE)』の調査報道担当記者。ワシントンポスト、プロパブリカ(ProPublica)、WNYCなどのメディアにも寄稿・出演している。