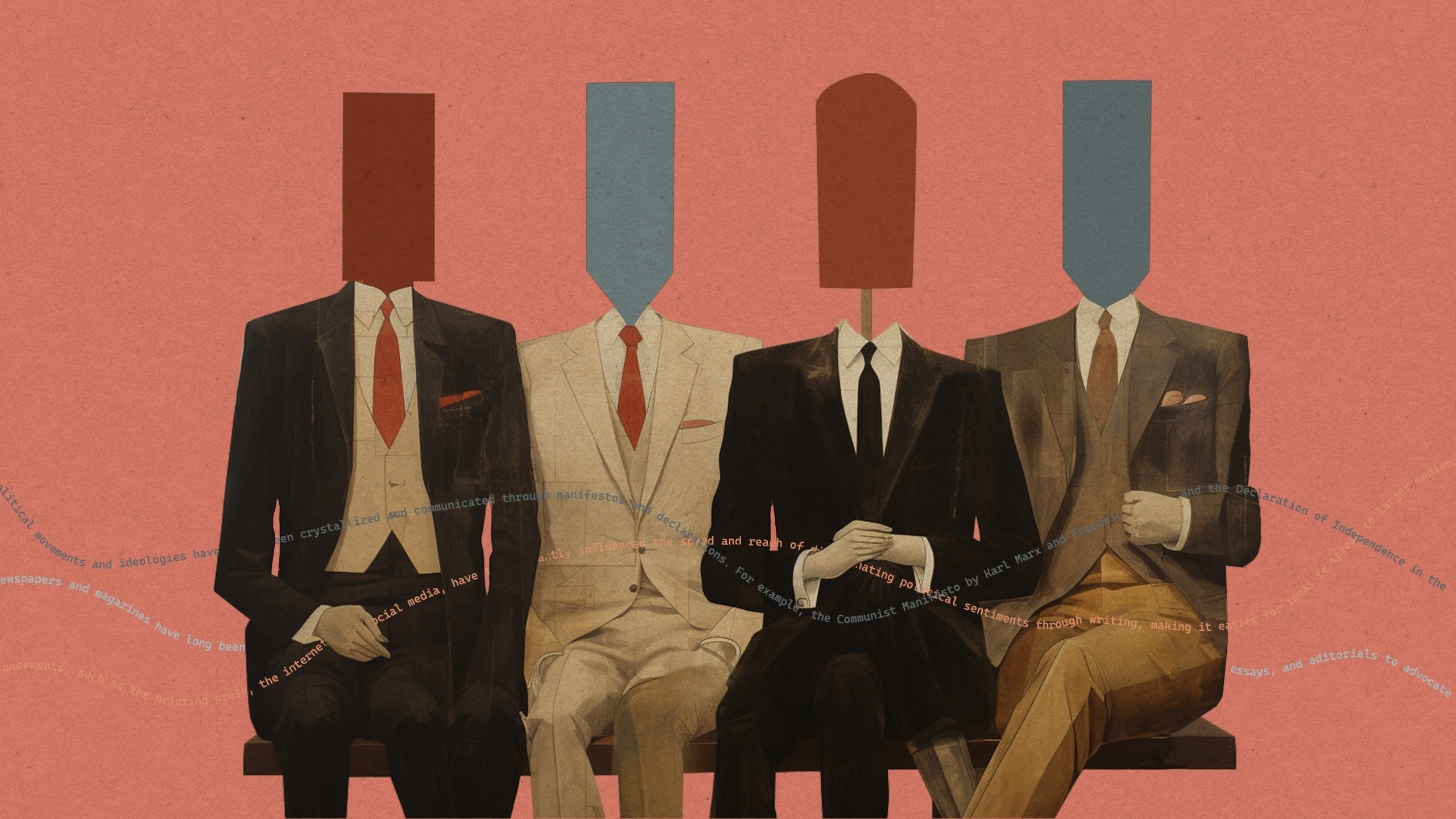

チャットGPTは左派的、大規模言語モデルに政治的バイアス

最新の研究により、大規模言語モデルには政治的なバイアスが多く含まれていることがわかった。質問に対して得られる回答の内容が、モデルによって右派的になったり左派的になったりするのだ。 by Melissa Heikkilä2023.08.11

企業は、社会的責任を持つべきだろうか。それとも、株主に利益をもたらすためだけに存在するのだろうか。人工知能(AI)に回答を求めた場合、AIによって全く異なる回答が返ってくるかもしれない。オープンAI(OpenAI)の旧モデルである「GPT-2」や「GPT-3 エーダ(GPT-3 Ada)」は、前者の意見に賛成するだろうし、同社のより高性能なモデルである「GPT-3ダ・ビンチ(GPT-3 Da Vinci)」は、後者の意見に賛成するだろう。

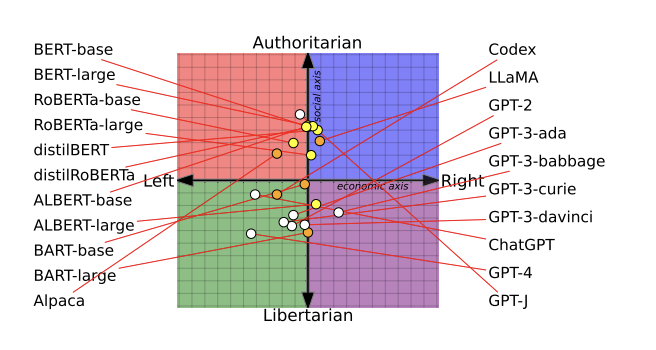

それはなぜか。ワシントン大学、カーネギーメロン大学(CMU)、西安交通大学が実施した新たな研究によると、AIの各言語モデルには、それぞれ異なる政治的バイアスが含まれているという。研究チームは14種類の大規模言語モデルをテストし、オープンAIの「チャットGPT(ChatGPT)」と「GPT-4」が最左翼のリバタリアン(自由至上主義)であり、メタ(Meta)の「LLaMA(ラマ)」が最右翼の権威主義であることを見い出した。

研究者チームは言語モデルに、フェミニズムや民主主義など、さまざまな話題に関する意見を尋ねた。そしてその回答を、ポリティカル・コンパスとして知られる座標にプロットした。さらに、政治的バイアスがかけられた訓練データを使用してAIモデルを再訓練し、ヘイトスピーチや誤情報の検出行動および能力に変化がみられるかどうかをテストした(それは実際に変化した)。この研究の詳細は、7月の計算言語学会で最優秀論文賞を受賞した査読付き論文に記載されている。

AI言語モデルは、何百万もの人々が使用する製品やサービスに展開されるため、その根底にある政治的想定やバイアスを理解しておくことは極めて重要だ。実害がもたらされる危険性があるからだ。たとえば、ヘルスケア関連のアドバイスを提供するチャットボットが、中絶や避妊に関するアドバイスを拒否するかもしれないし、カスタマーサービスボットが攻撃的でナンセンスな発言をするかもしれない。

チャットGPTの成功以来、オープンAIは「チャットボットはよりリベラルな世界観を反映するものだ」と主張する右派コメンテーターから批判を受けてきた。しかし、同社はそういった懸念に対処するために取り組んでいるとし、「AIモデルの微調整を手伝うレビュアーたち(人間)には、いかなる政治団体の意見も優遇しないよう指示しています。上記プロセスを経たにも関わらず現れる可能性のあるバイアスはバグであり、弊社モデルの特徴ではありません」」とブログに投稿した。

研究チームの一員であり、カーネギーメロン大学の研究員であるチャン・パーク博士は、この主張に同意しない。「政治的バイアスから完全に自由な言語モデルなどあり得ないと確信しています」と、同博士は言う。

あらゆる段階に忍び寄るバイアス

パーク博士らの研究チームは、AI言語モデルが政治的バイアスにどう影響されるのかを逆解析するため、モデル開発の3段階を調査した。

第1段階では、14の言語モデルに対し、政治的にセンシティブな62の発言に関する賛否を尋ねた。この検証は、モデルの根底にある政治的傾向を特定し、ポリティカル・コンパス座標にプロットするうえで役立った。「驚くべきことに、各AIモデルは明らかに異なる政治的傾向をもつことが分かりました」と、パーク博士は言う。

グーグル開発のAI言語モデルである「バート(BERT)」モデルは、オープンAIのGPTモデルよりも社会的に保守的であることがわかった。GPTモデルは、一文の中における次の単語を予測するが、BERTモデルはこれとは異なり、文の周辺情報を利用して文の一部を予測する。研究者チームは論文の中で、「古いBERTモデルは、より保守的傾向の強い書籍で訓練されるため、社会的保守性が強まるのではないだろうか。新しいGPTモデルは、よりリベラルなインターネット・テキストで訓練されている」と推測している。

テック企業がデータセット方法や訓練方法を更新するにつれ、AIモデルも変化していく。たとえばGPT-2は「富裕層への課税」に支持を表明したが、オープンAIの新モデルであるGPT-3は支持しなかった。

MITテクノロジーレビューは、グーグルとメタにコメントを求めたが、記事掲載時までに回答を得ることはできなかった。

「第2段階では、右寄りと左寄りの両方のニュースメディアとソーシャルメディアデータから成るデータセットを用いて、オープンAIのGPT-2とメタのロバータ(RoBERTa)という2つのAI言語モデルをさらに訓練しました」と、パーク博士は言う。研究チームの目的は、訓練データが政治的バイアスに影響を与えるかどうかを確かめることだった。

その結果、影響が確認された。研究チームは、このプロセスがモデルのバイアスをさらに強めることを発見した。左派学習モデルはより左寄りに、右派学習モデルはより右寄りになった。

研究の第3段階では、AIモデルの政治的傾向が、ヘイトスピーチや誤報として分類されるコンテンツの種類にどう影響を及ぼすかを調査した。その結果、顕著な違いがあることが分かった。

左派データで訓練したモデルは、黒人やLGBTQ+といった米国の民族、宗教、性的マイノリティを標的とするヘイトスピーチにより敏感だった。右派のデータに基づいて訓練されたモデルは、白人のキリスト教徒に対するヘイトスピーチに対してより敏感であった。

また、左寄りの言語モデルは、右寄りの情報源からの誤情報の識別には優れていたが、左寄りの情報源からの誤情報にはさほど敏感ではなかった。右寄りの言語モデルでは、逆の行動パターンが示された。

データセットのバイアスを取り除くだけでは不十分

「結局のところ、各AIモデルが異なる政治的バイアスを持つ理由を第三者が知ることは不可能です。テック企業は、訓練に使用したデータや方法の詳細を公開しないからです」と、パーク博士は言う。

研究者たちが言語モデルのバイアスを減らそうと試みた方法のひとつに、データセットからバイアスのかかったコンテンツを除去したり、フィルターをかけたりするというものがあった。「この論文が提起している大きな疑問は、はたしてデータセットのバイアスを取り除くだけで十分なのかということです。その答えはそうではありません」と、ダートマス大学のコンピューター科学助教授であるソローシュ・ヴォスギは言う。同助教授は、今回の研究には参加していない。

「膨大なデータベースのバイアスを完全に洗い出すのは非常に困難です。さらに、AIモデルがデータ内に存在するかもしれないわずかなバイアスを表面化させる傾向も、かなり強く見受けられます」と、ヴォスギ助教授は言う。

「この研究には限界があります。そのひとつは、研究者チームがGPT-2やRoBERTaといった、比較的古い小規模モデルでしか第2・第3段階の検証をできなかったという点です」と、ルイボ・リュウ博士は言う。同博士はディープマインド(DeepMind)の研究科学者であり、AI言語モデルの政治的バイアスを研究しているが、今回の研究には参加していない。

リュウ博士は、この論文の結論が最新のAIモデルにも当てはまるかどうかを知りたいと述べる。しかし、学術研究者にはチャットGPTやGPT-4といった最先端AIシステムの内部の仕組みにアクセスする権限はなく、アクセスできる可能性も非常に低い。このことが分析をより一層困難にしている。

「もう一つの限界は、AIモデルではありがちなのですが、モデルがでっち上げをしているだけだとしたら、その反応は内部状態を真に反映したものではない可能性があるという点です」と、ヴォスギ助教授は言う。

研究チームはまた、ポリティカル・コンパス・テストは幅広く用いられる手段ではあるが、政治に関する全てのニュアンスを測定する手段としては完璧ではないと認める。

「企業がAIモデルを自社製品やサービスに組み込む際は、より公平を期すため、こうしたバイアスがモデルの行動にどう影響するかをしっかりと認識しておくべきです」と、パーク博士は言う。「認識なくして公平性はありません」。

- 人気の記事ランキング

-

- Who’s to blame for climate change? It’s surprisingly complicated. CO2排出「責任論」、単一指標では語れない複雑な現実

- Promotion MITTR Emerging Technology Nite #31 MITTR主催「再考ゲーミフィケーション」開催のご案内

- Exosomes are touted as a trendy cure-all. We don’t know if they work. 「奇跡の薬」エクソソーム、 効果不明も高額治療が横行

- Who’s to blame for climate change? It’s surprisingly complicated. CO2排出「責任論」、単一指標では語れない複雑な現実

- Exosomes are touted as a trendy cure-all. We don’t know if they work. 「奇跡の薬」エクソソーム、 効果不明も高額治療が横行

- メリッサ・ヘイッキラ [Melissa Heikkilä]米国版 AI担当上級記者

- MITテクノロジーレビューの上級記者として、人工知能とそれがどのように社会を変えていくかを取材している。MITテクノロジーレビュー入社以前は『ポリティコ(POLITICO)』でAI政策や政治関連の記事を執筆していた。英エコノミスト誌での勤務、ニュースキャスターとしての経験も持つ。2020年にフォーブス誌の「30 Under 30」(欧州メディア部門)に選出された。