AIによる「人類滅亡」回避、原子力の安全管理にヒント

強力な人工知能が人類滅亡を招く——こう心配する声が欧米で高まりつつある。企業はどのようにしてAIによる破滅を回避しようと提案しているのだろうか。 by Melissa Heikkilä2023.06.08

この記事は米国版ニュースレターを一部再編集したものです。

いつか人類を滅亡させるほど強力な人工知能(AI)が開発されるかもしれない。こう考える専門家グループの警告がここ週週間で、大きな声になりつつある。

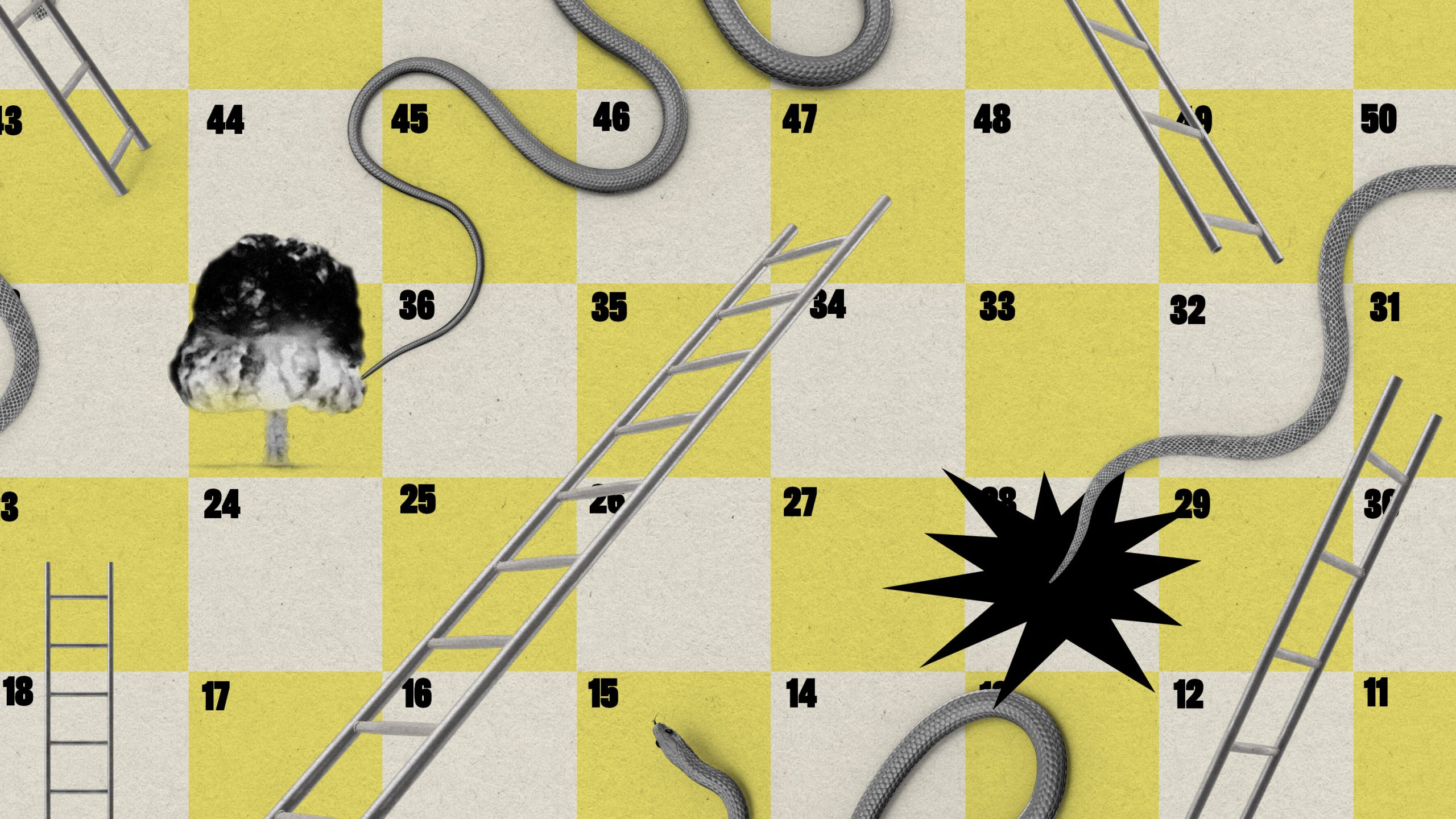

AI開発の一時停止を求めてAI界の著名人を含む3万人以上が署名した最初の公開書簡に続き、テック企業のリーダーやAI専門家からなるグループが新たに公開書簡を発表した。AIによる人類滅亡のリスクを軽減することは、パンデミックや核戦争を防ぐことと同等の世界的優先事項であるべきだと宣言する内容だ。

では、企業はどのようにしてAIによる破滅を回避しようと提案しているのだろうか? オックスフォード大学、ケンブリッジ大学、トロント大学、モントリオール大学、グーグル・ディープマインド(DeepMind)、オープンAI(OpenAI)、アンソロピック(Anthropic)、AI研究の複数のNPO、チューリング賞受賞者のヨシュア・ベンジョらからなる研究チームが、新たな論文である提案を発表している。

論文では、AI開発者はそのモデルが「極端な」リスクを引き起こす可能性を開発のごく初期段階に、できれば訓練を開始する前にでも評価すべきだと指摘している。こうしたリスクには、AIモデルが人間を操ったり欺いたりする可能性、武器にアクセスする可能性、悪用可能なサイバーセキュリティの脆弱性を見つける可能性などが含まれる。

このような評価プロセスは、開発者にとってそのモデルを進めていくべきかどうかを判断する材料になる。リスクが高すぎると判断された場合、それが軽減できるまで開発を一時停止するよう研究チームは提言している。

「最先端で開発を進めているAI企業には、新たに浮上する問題に目を光らせ、早い段階で発見し、できるだけ早急に対処できるようにする責任があります」。ディープマインドの研究科学者で今回の論文の筆頭著者であるトビー・シェブレーンはこう述べる。

AI開発者は、モデルの危険度の高い能力を調査し、モデルがその能力を適用する性質があるかどうかを判断する必要があるとシェブレーンは言う。

ディープマインドは、AI言語モデルに人間を操る能力があるかどうかをテストする方法の1つとして、「Make-me-say(私に言わせて)」というゲームを使っている。ゲームの中でモデルは、人間に対してある特定の、たとえば「キリン」というような単語を入力させようとする。そして、研究者がそのモデルの成功率を測定するのだ。

同様のタスクを、より危険度の高いさまざまな能力に対して作成できる。開発者がモデルのパフォーマンスを詳細に示すダッシュボードを構築できるようになれば、モデルがどのように悪用され得るかを研究者が判断することが可能になり、そこに期待しているとシェブレーンは言う。

次の段階は、AIモデルが展開される前と展開された後のリスクを外部の監査人や研究者に評価させることだ。 テック企業は外部の監査や調査が必要であることを認識してはいるだろうが、外部の人間が評価するのに実際どこまでアクセスする必要があるかについてはさまざまに意見が分かれるところだ。

シェブレーンは、AI企業が外部の研究者にデータやアルゴリズムへの完全なアクセスを与えるべきだとまでは言わないが、AIモデルにはできる限り多くの目が注がれる必要があると述べている。

これらの方法ですら「未熟」であり、十分に厳格なものだとは到底言えないと語るのは、サイバーセキュリティの調査・コンサルティング会社であるトレイル・オブ・ビッツ(Trail of Bits)で機械学習保証を担当するエンジニアリング部長、ハイディ・クラーフだ。クラーフ部長は、前職では原子力発電所の安全性を評価・検証する仕事に就いていた人物である。

AI業界にとっては、80年以上にわたる核兵器関連の安全性研究とリスク軽減から教訓を引き出すほうがもっと役に立つとクラーフ部長は語る。原子力にまつわる厳格な検査体制は、利益追求のためではなく、現実的な人類存続の脅威のために敷かれたものだからだ。

AI界隈では、核戦争や原子力発電所、原子力の安全性についての言及は多いが、原子力の規制や原子力システム用ソフトウェアの構築方法について言及している論文はまったくないとクラーフ部長は言う。

AIコミュニティが原子力リスクから学べる唯一最大のことは、トレーサビリティ(追跡可能性)の重要性だ。つまりは、あらゆる働きとコンポーネントを精査し、細部まで最新の注意を払って分析・記録することである。

たとえば、原子力発電所には、システムが誰にも害を与えないことを証明する何千ページもの文書があるとクラーフ部長は言う。一方、AI開発では開発者たちが、モデルの性能の詳細を手短に説明するカードをまとめ始めたばかりだ。

「リスクをくまなく調べるには、体系的な方法が必要です。行き当たりばったりで『ああ、こういうことが起こり得るな。ちょっと書き留めておこう』というようなやり方ではだめなのです」とクラーフ部長は話す。

一方、ディープマインドのシェブレーンは、どちらかのやり方を排除しなければならないものではないと言う。「望むのは、AI分野が幅広いリスクをカバーできる多くの素晴らしいモデル評価を存在し(中略)、モデル評価が中心的な(だが決して唯一ではない)ツールとなって優れた管理体制を敷くことです」。

現時点でAI企業は、アルゴリズムに投入されたデータセットの包括的理解すらできておらず、AI言語モデルがどのように結果を生み出しているのかを完全には把握していない。そこは変わらなければならないとシェブレーンは言う。

「ある特定のモデルをじっくりと理解するための研究が、さまざまな幅広いリスクに適切に対処するのに役立つことでしょう」。

こうした基本や小さな問題を無視して極端なリスクにばかり目を向けていれば、影響が複合化し、さらに大きな害につながる恐れがあるとクラーフ部長は言う。「私たちはハイハイすらできないのに、走ることをしようとしているのです」。

◆

AI生成による映像が映画をどう変えるか?

AIが生成した短編映画『ザ・フロスト(The Frost)』の独占公開映像をお届けしよう。12分間のこの映画のショットはすべて、オープンAIの画像生成AIシステムであるDALL-E 2(ダリー2)が生成したものだ。まだ馴染みのないこの新ジャンルの中でも、きわめて印象的な(そして奇妙な)作品の1つだ。

新しいテクノロジーを最初に試すのは、たいていアーティストたちである。しかし、AI生成動画の短期的な未来は、広告業界によって形作られている。この映画を制作したデトロイトの映像制作会社であるウェイマーク(Waymark)は、生成AIをどのように自社製品へ組み込むことができるか探るために、ザ・フロストを制作した。『ザ・フロスト』を制作した。 ウィル・ダグラス・ヘブンが執筆した記事はこちらから読める。

AI関連のその他のニュース

ステーブル・ディフュージョン(Stable Diffusion)の成功を自分の手柄とするAI企業創業者には、誇張の歴史がある。スタビリティAI(Stability AI)の創業者であるエマド・モスタクの、非常に誇張された誤解を招く主張についての痛烈な批判記事。元従業員や現従業員へのインタビューからは、ビジネスで成功するためにはルールを曲げることもいとわない厚顔な野心家の姿が浮かび上がってくる。(フォーブス)

チャットGPTに仕事を奪われた人たちは、犬を散歩させたり、エアコンを直したりしている。これは気の滅入る記事だった。企業はコスト削減のために、人間の作業よりも凡庸なAI生成コンテンツを選択するようになっており、利益を得ているのは、サービスへのアクセスを販売するテック企業だ。(ワシントンポスト紙)

ある摂食障害相談のホットラインは、「有害な」回答をしたチャットボットを停止するはめになった。このチャットボットは、すぐに弱者に対して有害なコンテンツを吐き出し始め、わずか2日で役を降ろされた。この話は、繊細さが要求される仕事をAI言語テクノロジーに任せることを考えている組織に対しての警告となることだろう。(ヴァイス)

チャットGPTの秘密の読書リスト。オープンAIは、チャットGPTやその後継であるGPT-4の訓練にどのようなデータが使われたのかを我々に明かしてくれてはいない。だが新たな論文によると、このチャットボットは、ジョン・ロナルド・ロウエル・トールキンから『銀河ヒッチハイク・ガイド』まで、驚異的な量のサイエンス・フィクションやファンタジーで訓練されていることが分かった。AIモデルに与えられるテキストは重要だ。彼らの価値観を作り出し、彼らの振る舞いに影響を与えるからだ。(インサイダー)

タコのような生物がAIの姿を象徴するようになった理由。サイエンス・フィクション作家のハワード・フィリップス・ラヴクラフトが1930年代に想像した架空の生物であるショゴス(Shoggoth)は、AI業界では内輪ジョークのネタになっている。テック企業が「人間のフィードバックによる強化学習(RLHF:Reinforcement Learning from Human Feedback)」という手法を使って言語モデルの振る舞いを改善しようとしても、醜いモンスターを覆い隠すマスクという結果にしかならないのだという。(ニューヨーク・タイムズ紙)

- 人気の記事ランキング

-

- Who’s to blame for climate change? It’s surprisingly complicated. CO2排出「責任論」、単一指標では語れない複雑な現実

- Promotion MITTR Emerging Technology Nite #31 MITTR主催「再考ゲーミフィケーション」開催のご案内

- Exosomes are touted as a trendy cure-all. We don’t know if they work. 「奇跡の薬」エクソソーム、 効果不明も高額治療が横行

- Who’s to blame for climate change? It’s surprisingly complicated. CO2排出「責任論」、単一指標では語れない複雑な現実

- Exosomes are touted as a trendy cure-all. We don’t know if they work. 「奇跡の薬」エクソソーム、 効果不明も高額治療が横行

- メリッサ・ヘイッキラ [Melissa Heikkilä]米国版 AI担当上級記者

- MITテクノロジーレビューの上級記者として、人工知能とそれがどのように社会を変えていくかを取材している。MITテクノロジーレビュー入社以前は『ポリティコ(POLITICO)』でAI政策や政治関連の記事を執筆していた。英エコノミスト誌での勤務、ニュースキャスターとしての経験も持つ。2020年にフォーブス誌の「30 Under 30」(欧州メディア部門)に選出された。