典型的な自然言語処理モデルの訓練には膨大な計算パワーが必要であり、大量の二酸化炭素を排出する。その量は、米国製セダン車が耐用年数内に放出する炭素量のほぼ5倍に相当する。画像認識モデルの訓練で消費されるエネルギーは、一般的な住宅で消費されるエネルギーの2週間分だ。大手テック企業は1日に複数回、こうしたモデルの訓練を実施している。

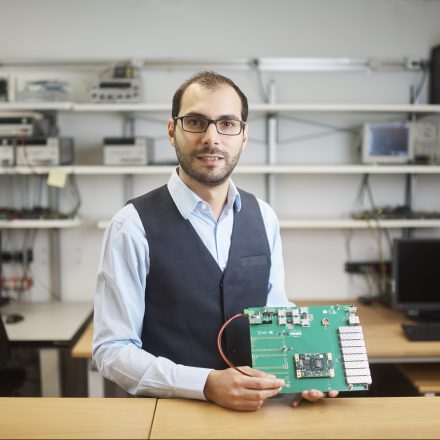

現代のコンピューティングではメモリとプロセッサーの間でデータを絶えず転送する必要があり、エネルギーの多くはそのために使用されている。マニュエル・ル・ガロはIBMの研究チームと協力して、より高速でエネルギー効率が高く、しかも高精度な、新しい種類のコンピューティング・アーキテクチャを実現するためのテクノロジーを開発している。

ル・ガロの研究チームは、メモリ自体を使用してデータを処理するシステムを開発した。これまでの研究ですでに、精度と大幅なエネルギー節約の両方を実現できることが示されている。研究チームは最近、従来の方法で実行した場合のわずか1%のエネルギーで処理を完了した。

金融分野から生命科学に至るまでの企業が人工知能(AI)モデルを改善するため絶えず訓練を実施しており、今後もエネルギー需要は急増するだろう。「私たちの手法により、二酸化炭素排出量と、モデルの訓練に費やされるエネルギーは確実に削減され、モデルの高速化とエネルギー効率向上が可能になります」とル・ガロは言う。

- 人気の記事ランキング

-

- Why handing over total control to AI agents would be a huge mistake 「AIがやりました」 便利すぎるエージェント丸投げが危うい理由

- OpenAI has released its first research into how using ChatGPT affects people’s emotional wellbeing チャットGPTとの対話で孤独は深まる? オープンAIとMITが研究

- An ancient man’s remains were hacked apart and kept in a garage 切り刻まれた古代人、破壊的発掘から保存重視へと変わる考古学

- How to have a child in the digital age 「あなたはもうママですね」 ネット・デジタルが約束する 「完璧な出産」の幻想

| タグ | |

|---|---|

| クレジット | Samuel Trümpy |

| 著者 | MIT Technology Review編集部 [MIT Technology Review Editors] |