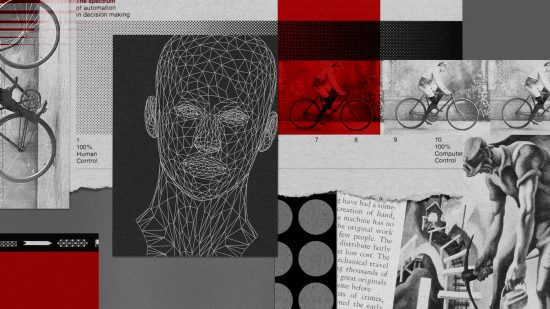

強化学習は自動運転車に使えるか? 新手法で「安全性」を模索

罰と報酬を手がかりにした機械学習の手法である強化学習 (RL)は、機械に新しい環境への適用を教える、強力な手法となり得るものだ。

ディープマインドのアルファ碁( AlphaGo)は強化学習を使うことで、初対局にも関わらず世界最強の囲碁棋士を打ち負かした。強化学習はまた、変化する状況下で動作するロボットを作るのにも効果的だと分かっている。

だが、強化学習には限界がある。学習によって徐々に動きを洗練させていくためには、機械が繰り返しミスをする必要があるのだ。研究室の中やボードゲームをしている最中は問題ないかもしれないが、ミスが致命的になりうる自動運転車などへの応用には理想的ではない。

課題を解決するためにこれまで研究者らは、機械が実世界で訓練しなくても済むようにさまざまな方法を開発してきた。たとえば、シミュレーション環境の中でデータに基づいて機械を訓練する方法がある。物理的な世界をデジタルで安全に再現した環境下であれば、車は交通データから運転を学べる。そうすることで、人間を危険にさらすことなく、試行錯誤の段階を通過できるわけだ。

だがこの解決策は完璧ではない。訓練データの範疇を超えた状況に遭遇したときに、機械が想定外のミスを起こすリスクは依然として残っている。たとえばニューヨーク大学の研究者はある事例で、自動運転車が対向車に向かって90度ターンすることがあることを発見した(幸いにもシミュレーション環境だったが)。これは訓練データが、その種のシナリオを包括していなかったためだ。言うにも及ばず、これでは自動運転車やロボット医師の安全な訓練は難しい。

ニューヨーク大学の研究チームは、フェイスブックAI研究所のヤン・ルカン所長らとともに現在、この問題を克服できる新しい方法を提案している 。正確な運転方法を学ぶ自動車に罰と報酬を与えるのに加え、訓練データが不十分なシナリオに迷い込んだ場合も罰を課すというものだ。

これによって、自動運転車は未知の領域に直面しても大胆なターンなどの動きをするのではなく、慎重に運転せざるを得なくなる、と研究の共同執筆者の1人であるミカエル・ヘナフは説明する。

新しい方法を試した研究チームは、以前の方法よりも、混雑した道路を安全に移動する能力が向上したことを確認した。それでも依然として、人間による運転ほどには優れていない。さらなる研究が必要だ。

「テクノロジーは人をダメにする」プラトンも恐れた人類の葛藤の歴史

「テクノロジーは人をダメにする」プラトンも恐れた人類の葛藤の歴史  メディアの主役に躍り出た動画は、活字文化に終わりを告げるか?

メディアの主役に躍り出た動画は、活字文化に終わりを告げるか?

eムック「宇宙探査新時代 先端技術が拓くフロンティア」特集号

eムック「宇宙探査新時代 先端技術が拓くフロンティア」特集号

卵巣がんとの闘い

卵巣がんとの闘い 選挙干渉、AIより古典的手法が主流 米大統領選の対策は?

選挙干渉、AIより古典的手法が主流 米大統領選の対策は?